CNN各种结构作用简析

demi 在 周二, 04/07/2020 - 16:25 提交

CNN主要实现的就是特征提取,最经典的应用就是从多个图片中提取出有用的信息。这个过程对于人来说是个黑盒的过程,人们并不能很确切的知道里面发生了什么。结果也是非常抽象的,但是却能学习到很好的效果。

CNN主要实现的就是特征提取,最经典的应用就是从多个图片中提取出有用的信息。这个过程对于人来说是个黑盒的过程,人们并不能很确切的知道里面发生了什么。结果也是非常抽象的,但是却能学习到很好的效果。

我们之所以使用卷积后的特征,是因为图像具有“静态型”的属性,也就意味着在一个图像区域的特征极有可能在另一个区域同样适用。所以,当我们描述一个大的图像的时候就可以对不同位置的特征进行聚合统计这种统计方式不仅可以降低纬度,还不容易过拟合。

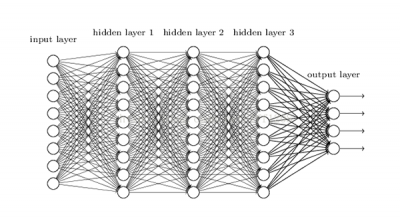

感知机包含有输入层、输出层和一个隐藏层。输入的特征向量通过隐藏层变换到达输出层,由输出层得到分类结果。

CNN组成:Convolutional layer,Pooling layer,Fully Connected layer。

CNN网络是一种用来处理局部和整体相关性的计算网络结构,被应用在图像识别(CV)、自然语言处理(NLP)甚至是语音识别领域,因为图像数据具有显著的局部与整体关系,其在图像识别领域的应用获得了巨大的成功。

虽然现在CNN可以自己进行特征提取,但还是需要对OpenCV传统的特征提取方法有一些了解

我们知道在CNN网络中,会有各种size的卷积层,比如常见的3x3,5x5等,卷积操作是卷积核在图像上滑动相乘求和的过程,起到对图像进行过滤特征提取的功能。

卷积神经网络由输入层,卷积层,激活函数,池化层,全连接层组成。卷积操作是使用一个二维的卷积核在一个批处理的图片上进行不断扫描。具体操作是将一个卷积核在每张图片上按照一个合适的尺寸在每个通道上面进行扫描。

卷积层输入特征图(input feature map)的尺寸为

在卷积神经网络中,感受野是一个非常重要的概念,今天,我们具体来看一下感受野的相关概念以及如何计算感受野。