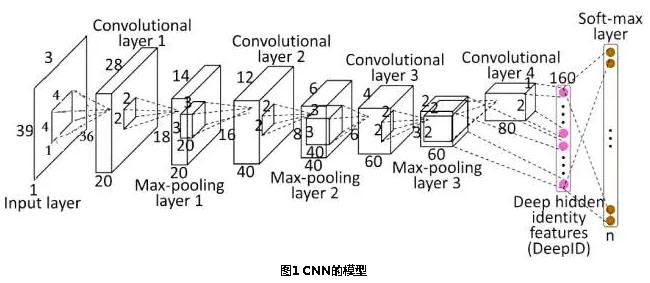

1. 卷积神经网络由输入层,卷积层,激活函数,池化层,全连接层组成.

input(输入层)--conv(卷积层)--relu(激活函数)--pool(池化层)--fc(全连接层)

2. 卷积层:

主要用来进行特征的提取

卷积操作是使用一个二维的卷积核在一个批处理的图片上进行不断扫描。具体操作是将一个卷积核在每张图片上按照一个合适的尺寸在每个通道上面进行扫描。

tf.nn.conv2d(input, filter, strides, padding, use_cudnn_on_gpu=None, name=None)

这个函数的作用是对一个四维的输入数据 input 和四维的卷积核 filter 进行操作,然后对输入数据进行一个二维的卷积操作,最后得到卷积之后的结果。

tf.nn.bias_add(value, bias, name = None):这个函数的作用是将偏差项 bias 加到 value 上面。

3.激活函数

在神经网络中,激活函数的作用是能够给神经网络加入一些非线性因素,使得神经网络可以更好地解决较为复杂的问题。

在神经网络中,我们有很多的非线性函数来作为激活函数,比如连续的平滑非线性函数(sigmoid,tanh和softplus),连续但不平滑的非线性函数(relu,relu6和relu_x)和随机正则化函数(dropout)。

所有的激活函数都是单独应用在每个元素上面的,并且输出张量的维度和输入张量的维度一样。

常用的激活函数:

(1)tf.nn.relu(features, name = None):这个函数的作用是计算激活函数relu,即max(features, 0)

(2)tf.nn.relu6(features, name = None):这个函数的作用是计算激活函数relu6,即min(max(features, 0), 6)

(3)tf.nn.softplus(features, name = None):这个函数的作用是计算激活函数softplus,即log( exp( features ) + 1)。

(4)tf.sigmoid(x, name = None):这个函数的作用是计算 x 的 sigmoid 函数。具体计算公式为 y = 1 / (1 + exp(-x))。

(5)tf.tanh(x, name = None):这个函数的作用是计算 x 的 tanh 函数。具体计算公式为 ( exp(x) - exp(-x) ) / ( exp(x) + exp(-x) )。

激活函数应该具有的特征:

(1)非线性。线性激活层对于深层神经网络没有作用,因为其作用以后仍然是输入的各种线性变换。。

(2)连续可微。梯度下降法的要求。

(3)范围最好不饱和,当有饱和的区间段时,若系统优化进入到该段,梯度近似为0,网络的学习就会停止。

(4)单调性,当激活函数是单调时,单层神经网络的误差函数是凸的,好优化。

(5)在原点处近似线性,这样当权值初始化为接近0的随机值时,网络可以学习的较快,不用可以调节网络的初始值。

4. 池化层

主要是对输入的特征图进行压缩,一方面使特征图变小,简化网络计算负责度,另一方面进行特征压缩,提取主要特征。

迟化操作一般有两种:Avy Pooling和max Pooling

max Pooling:计算迟化区域中元素的最大值

5. Dropout 防止过拟合

当训练数据量比较小时,可能会出现因为追求最小差值导致训练出来的模型极度符合训练集,但是缺乏普适性,不能表达训练数据之外的数据

解决方案:

tf.nn.dropout(x, keep_prob, noise_shape = None, seed = None, name = None)

Dropout就是在不同的训练过程中随机扔掉一部分神经元也就是让某个神经元的激活值以一定的概率p,让其停止工作,这次训练过程中不更新权值,也不参加神经网络的计算。但是它的权重得保留下来(只是暂时不更新而已),因为下次样本输入时它可能又得工作了。如下图:

6. 全连接层

连接所有的特征,将输出值送给分类器

7.总体的结构

来源:博客园 - Curry秀,转载此文目的在于传递更多信息,版权归原作者所有。