适用于所有场景的统一架构GPU及生态

demi 在 周五, 12/20/2019 - 11:32 提交

2019年12月18-19日由国际测试委员会(BenchCouncil)主办的国际芯片大会在北京怀柔中国科学院大学国际会议中心成功举办。Imagination市场及生态高级总监时昕博士在领域芯片及生态分论坛做了题目为“适用于所有场景的统一架构GPU及生态 ”的主题演讲。

GPU,全称为图形处理单元(Graphics Processing Unit),是一种专用于处理图形和图像计算的处理器。起初,GPU主要用于图形渲染,但随着计算需求的增加,尤其是在科学计算、深度学习和其他并行计算领域,GPU的通用计算能力逐渐受到重视。

GPU相对于传统的中央处理单元(CPU)在设计上有一些显著的区别。CPU更适用于处理通用的控制流任务,而GPU则专注于高度并行的数据处理。GPU通常拥有大量的小型处理单元,被设计成能够同时处理大量相似的任务,例如图形渲染中的像素计算或深度学习中的矩阵运算。

总体而言,GPU在图形处理领域的成功应用和对并行计算需求的响应使其逐渐演变成为通用计算设备,广泛用于加速各种科学和工程计算应用。

2019年12月18-19日由国际测试委员会(BenchCouncil)主办的国际芯片大会在北京怀柔中国科学院大学国际会议中心成功举办。Imagination市场及生态高级总监时昕博士在领域芯片及生态分论坛做了题目为“适用于所有场景的统一架构GPU及生态 ”的主题演讲。

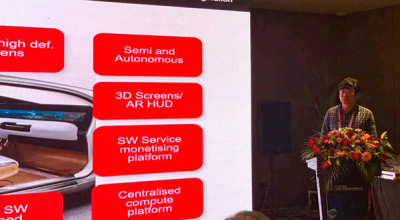

汽车正在变得越来越智能,但是如果汽车行业要实现完全自动驾驶的目标,他们还有很长的路要走。尽管业界还在讨论实现全自动化所需的理想技术组合,但是有一点是明确的,那就是人工智能,尤其是神经网络将发挥重要作用。

2019年12月18-19日,由国际测试委员会(BenchCouncil)主办的国际芯片大会将在北京怀柔中国科学院大学国际会议中心举办,本次会议以「构建自主可控和开放的芯片产业」为主题,旨在探讨如何建立自主可控和开放的芯片产业,在实现芯片等关键技术自主可控的同时,充分利用国际分工协作,提高芯片产业发展的可持续性。

世界上几乎没有公司能够声称其图形市场可以追溯到90年代的“黄金时代”,在那个时代的少数幸存者中当然有NVIDIA和AMD(以前称为ATI),但也有Imagination Technologies。该公司自图形加速器成立之初就存在,并且行业正在发生变化。在2000年初至中期,该公司不再使用台式机,而是专注于提供针对移动设备优化的GPU IP。

12月3日消息,Imagination Technologies公司针对图像及视频应用,发布了PowerVR 第十代(Series10)图形处理架构IMG A系列(IMG A-Series)。据称,IMG A系列是Imagination Technologies有史以来发布的性能最强大的图形处理器(GPU)半导体知识产权(IP)产品,首次搭载该IP的SoC器件预计在2020年出货。

2019年12月3日 Imagination Technologies宣布推出其第十代PowerVR图形处理架构IMG A系列(IMG A-Series)。IMG A系列可以支持汽车电子(包括辅助驾驶/自动驾驶)、AIoT、计算、数字电视/机顶盒/数字电视盒(DTV / STB / OTT)、移动设备和服务器等应用。

它是一款能同时处理图形和人工智能应用的GPU,还是一款可以智能调度实现多APP流畅应用的GPU!更是有史以来可带来绝佳流畅图形体验的最快GPU !

12月3日 | 上海卓美亚喜玛拉雅酒店——诚挚的邀请您加入Imagination Inspire年度技术盛会,揭秘赋能万物的全新GPU系列!

在当前的科技圈,最火的技术名词莫过于 5G 和 AI。5G 作为一种全新的网络架构,提供 10Gbps 以上的峰值速率、更佳的移动性能、毫秒级时延和超高密度连接;AI 则是研究使计算机来模拟人的某些思维过程和智能行为(如学习、推理、思考、规划等),主要包括计算机实现智能的原理、制造类似于人脑智能的计算机,使计算机能实现更高层次的应用。

10月25-26日,第十四届“中国芯”集成电路产业促进大会在青岛举行。Imagination积极参与本次大会,负责中国的汽车市场总监郑魁先生在汽车电子芯片论坛上发表了题为“车用GPU+AI计算架构,引领汽车智能化时代”的演讲。