GPU Raycasting的两种实现方法

demi 在 周一, 12/10/2018 - 16:43 提交

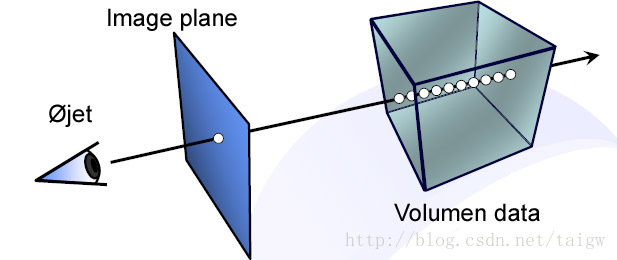

Raycasting的核心是从每一个屏幕像素处发射一条光纤,然后让其穿过整个体数据。基于GPU的Raycasting可以独立,并行地计算每条光线,从而能大大提高速度,实现实时绘制效果。绘制时的过程一般是绘制一个长方体,并且以体数据作为三维纹理。

根据光线的方向和终点的确定方法的不同,Raycasting有两种实现:

1,基于光线起点和相机位置。将相机位置由世界坐标通过模型视图投影矩阵反变换到长方体的局部坐标空间。每个fragment的坐标作为光线的起点,由变换后的相机位置与光线起点确定光线的方向,在沿着光线方向从起点前进时,每到达一个新的点,判断其是否在长方体内,如果不在,则结束这条光线。