公司领先的GPU、NNA、GPU+NNA等多种灵活的硬件设计方案和完善的软件和工具链,可为芯片设计公司带来满足应用市场需求的最佳技术与生态组合

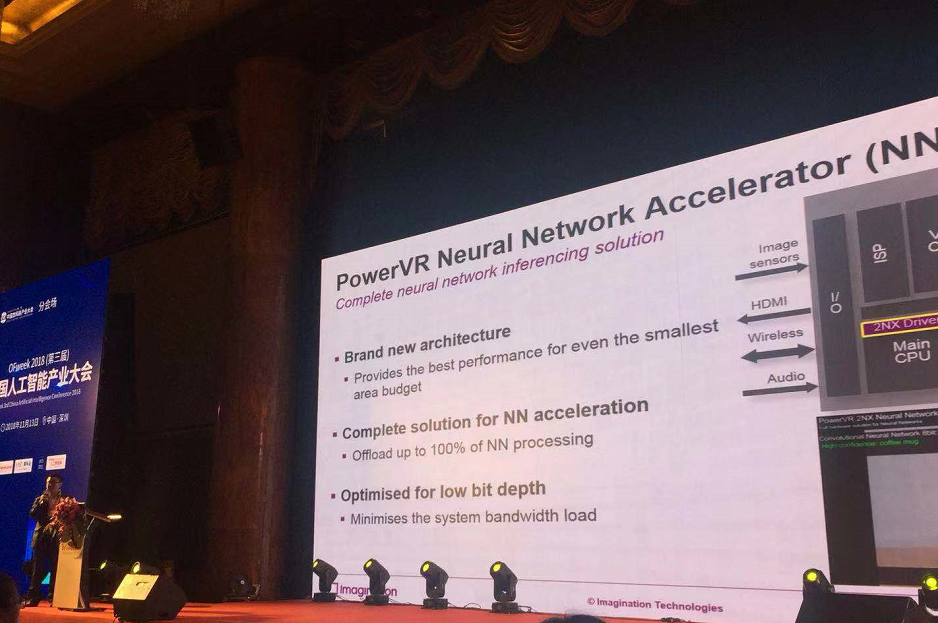

在11月13日于深圳举办的“OFweek 2018(第三届)中国人工智能产业大会AI技术专场”上,Imagination Technologies首席技术方案工程师李安发表了题为《运用GPU+NNA 实现设备端异构计算》的精彩演进,并介绍了公司领先的图形处理器(GPU)、用于人工智能的神经网络加速器(NNA)、GPU+NNA和片上存储架构和软件。 (这里提到的片上存储架构改成“GPU+NNA等多种灵活的系统架构设计和软件。”

Imagination在过去的近30年中,一直为业界提供领先的GPU硅知识产权(IP)产品,它们被广泛地应用于移动电话、平板电脑、数字电视、汽车电子和智能安防等等应用,客户包括苹果公司和联发科技等国际企业,以及紫光展锐、瑞芯微等国内领先芯片设计公司。其GPU内核全球累计销量已经超过130亿个,为各类电子产品的创新提供了很好的支撑。

去年9月,Imagination发布了基于其全新开发的神经网络专用PowerVR架构来实现的PowerVR Series2NX神经网络加速器(NNA),该系列加速器每个时钟周期最高可处理2048个MAC(每秒4.1兆次运算),代表了市场上单位面积(每平方毫米)上最高的性能。自此,Imagination以一整套覆盖全部处理链路的硬件(包括NNA、GPU和专用处理器)、软件(包括驱动软件、SDK和各种工具)以及生态系统(开源软件和机器学习框架),为芯片设计企业和应用公司通过创新进军人工智能领域开启了便捷之道。

李安介绍到,Imagination的人工智能解决方案共有三种,一种是只选择NNA加速器的方案,其特点是高性能、高性价比,具有一定的灵活性;第二种是纯粹GPU方案,它具有经过验证的性能和通用计算高灵活性;第三种为GPU + NNA解决方案,它把GPU的灵活性与NNA的高性能加速结合在一起,无论客户采用通用AI算法和网络,还是全新的、颠覆性的AI算法和网络,Imagination都可以根据客户的不同需求,为客户量身定制出领先市场的人工智能解决方案。

片上存储器(on chip memory)是Imagination架构的一个特色,可以降低存储带宽以及延迟,并可与芯片上的其他内核共同分享,从而在提高性能、支持更快速处理的同时降低了成本,李安补充道。此外,在AI领域目前还没有开放通用的API,以及桌面系统优先的情况下,AI项目需要软件和工具链才能够快速落地;而在此方面,Imagination有完整的驱动软件和SDK,成为了Imagination解决方案的另一个特点。

Imagination提供的API包括IMG DNN和Android NN HAL,不仅可以用同一套API来满足多种方案的开发需求,无论是上面三种硬件方案的哪一种都可以通用,而且还支持在GPU和NNA之间互联互通。作为面向终端应用的方案,Imagination作为安卓(Android)的神经网络应用程序编程接口(Neural Networks API,NNAPI)标准制定的参与者之一,其软件可以完美支持,开发人员使用NNAPI可以将神经网络功能带入基于Android的移动设备。所以,Imagination的软件能完全支持各种常见Linux、RTOS、Android操作系统。

在回答听众的问题时,李安表示:Imagination的PowerVR Series2NX已经获得手机、汽车电子和消费类电子类芯片厂商的采用,国内也已经有芯片设计公司完成流片,其产品正在测试之中,将于明年上半年进入市场。此外,Imagination的IP产品面向方兴未艾的AI终端产品和边缘计算,以及汽车市场,未来应用市场极为广阔。