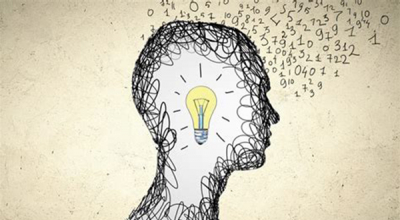

简单易懂的讲解深度学习(入门系列之六)

demi 在 周二, 12/11/2018 - 10:07 提交

“损失函数减肥用,神经网络调权重”

在上一讲中,由于感知机不能解决“异或”问题,明斯基并无恶意却把AI冷藏了二十载。但是解决“异或”问题,其实就是能否解决非线性可分问题。如何来解决这个问题呢???

简单总结,其就是用更加复杂网络(利用多层前馈网络——经典的全连接前馈神经网络与BP)。接下来,我们将详细讨论该问题。

6.1 复杂网络解决“异或”问题

我们知道了深度学习是一个包括很多隐含层的复杂网络。感知机之所以当初无法解决“非线性可分”问题,是因为相比于深度学习这个复杂网络,感知机太过于简单”。

如上所讲,想解决“异或”问题,就需要使用多层网络。这是因为,多层网络可以学习更高层语义的特征,其特征表达能力更强。因此,我们在输入层和输出层之间,添加一层神经元,将其称之为隐含层(“隐层”)。于是隐层和输出层中的神经元都有激活函数。

假设各个神经元的阈值均为0.5,权值如图6-1所示,就可实现“异或”功能。