9月15日,由Design&Reuse主办的IP SoC China 2020大会以在线方式举行。会议邀请了多家领先半导体企业,尤其是半导体知识产权(Silicon IP)厂商的高管或技术专家,围绕人工智能、汽车、RISC-V、物联网、视频、网络和接口、设计平台等话题发表了精彩演讲,并在线回答了参会者的问题。

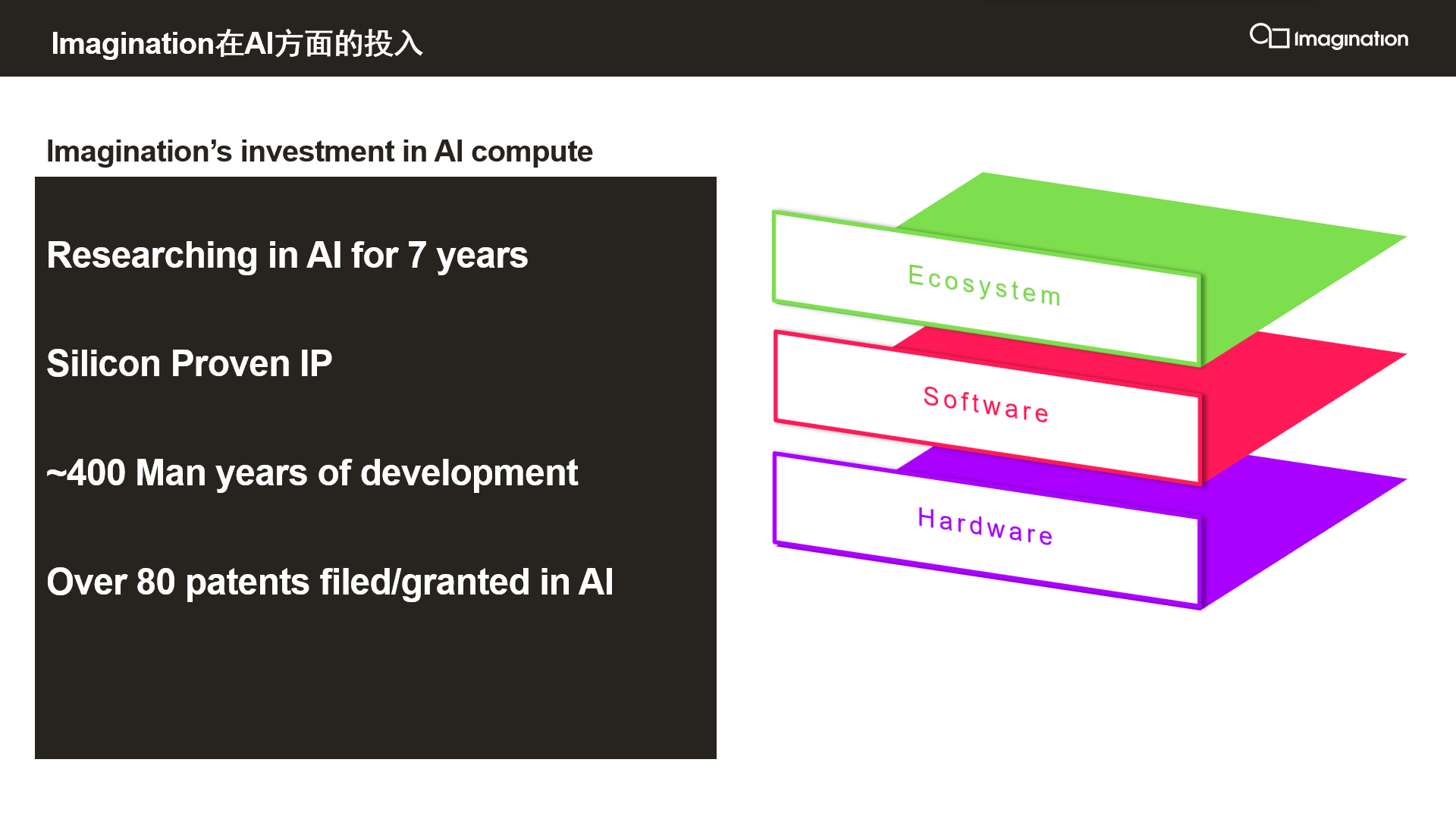

Imagination Technologies作为全球领先的半导体IP厂商受邀在人工智能(AI)分会上发表主题演讲并参与问答环节。随着AI技术和应用的发展越发火热,Imagination不断加大对AI领域的投入。截至目前,Imagination针对AI的研究已经超过7年,积累了80多项已申请或已批准的AI专利,其可支持多种AI应用的PowerVR图形处理器(GPU)和神经网络加速器(NNA)IP获得了业界的一致认可。

AI芯片市场需求潜力巨大

本次会议上,Imagination中国区战略市场与生态高级总监时昕带来了题为“高效开发和部署AI应用——从云到边缘”的演讲,从AI芯片的发展趋势,Imagination Series3NX NNA的特性和优势,Imagination NNA和GPU协同工作以支持AI应用等方面进行了精彩分享。

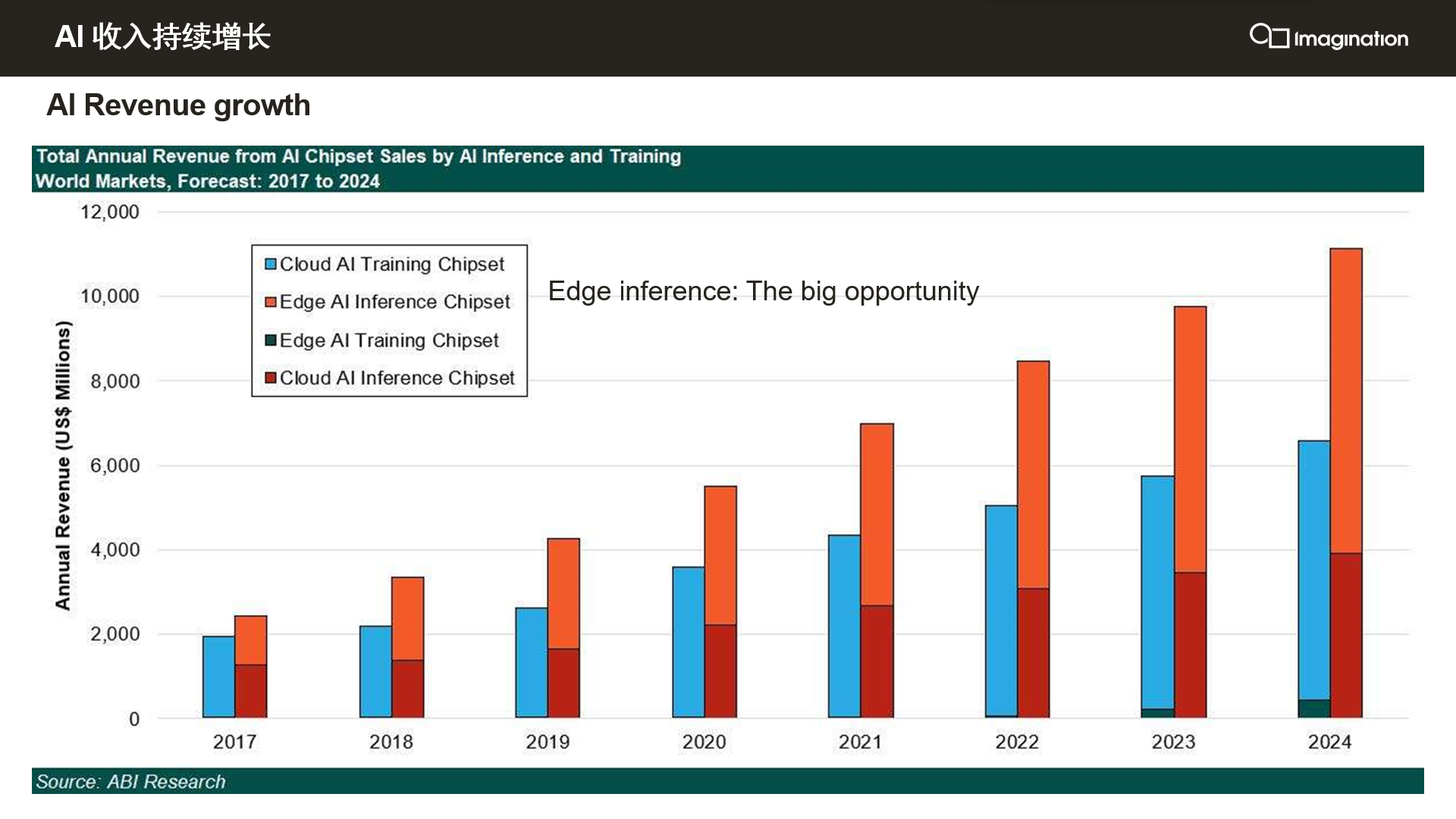

时昕表示:“近几年,AI获得了非常多的应用,在云端和边缘侧都有很多市场机会。根据ABI Research的预测,未来最大的需求是边缘侧的推理芯片,在2024年大约有70亿美元的市场需求,云端的推理芯片也有大约40亿美元的需求,这110亿美元的市场空间意味着Imagination的AI IP可以帮助我们的芯片客户去争取巨大的市场机会。统一架构的芯片既可用于云端,也可用于边缘,从而能使客户有效降低芯片的设计与流片成本。”

Imagination的AI芯片IP有哪些优势?

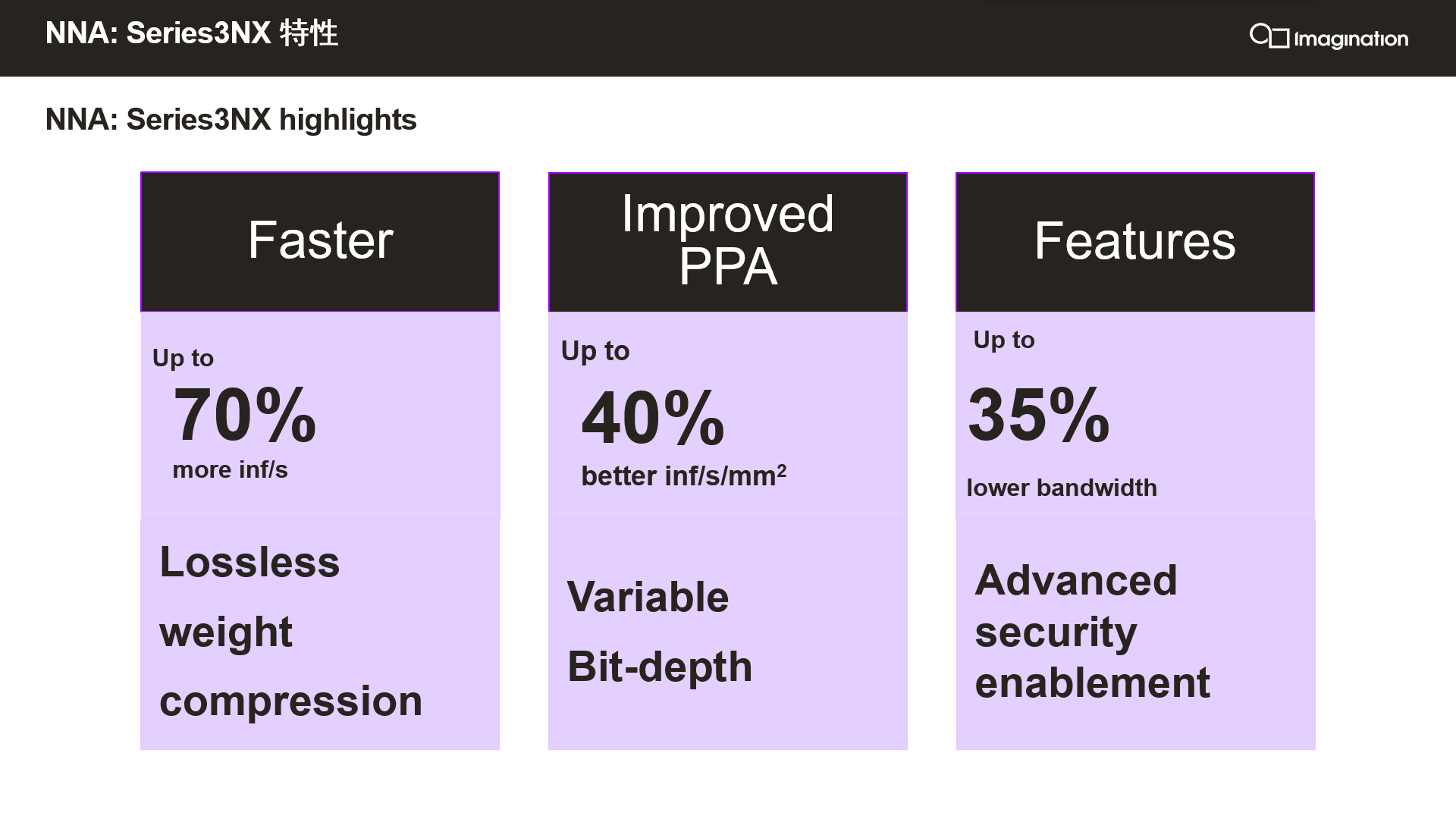

在演讲中,时昕重点介绍了Imagination PowerVR Series3NX NNA的性能优势和对各类应用场景的广泛支持:“相比我们前一代的2NX NNA,3NX NNA可以在更低功耗的基础上提供70%的算力提升,同时也会提供更多的位宽选择,PPA(性能、功耗、面积)指标会比2NX高很多。”

此前,Imagination的2NX NNA曾经在很多AI Benchmark榜单上霸榜,随着基于3NX NNA IP的芯片面世,也将为终端产品带来更好的体验。

另外,时昕表示,“3NX NNA拥有非常强的算力可配置性,可以提供从1 TOPS到上百TOPS的算力,以满足丰富的AI应用场景对算力的不同需求。对于强调低功耗但性能要求不严苛的场景,例如一些物联网设备,可以选用我们较小的单核NNA;对于场景复杂度和算力需求很高的应用,例如自动驾驶,我们可以通过多核形式提供上百TOPS的算力,客户可以根据自身需求进行灵活的、有针对性的选择。”

借助NNPU技术预处理图像

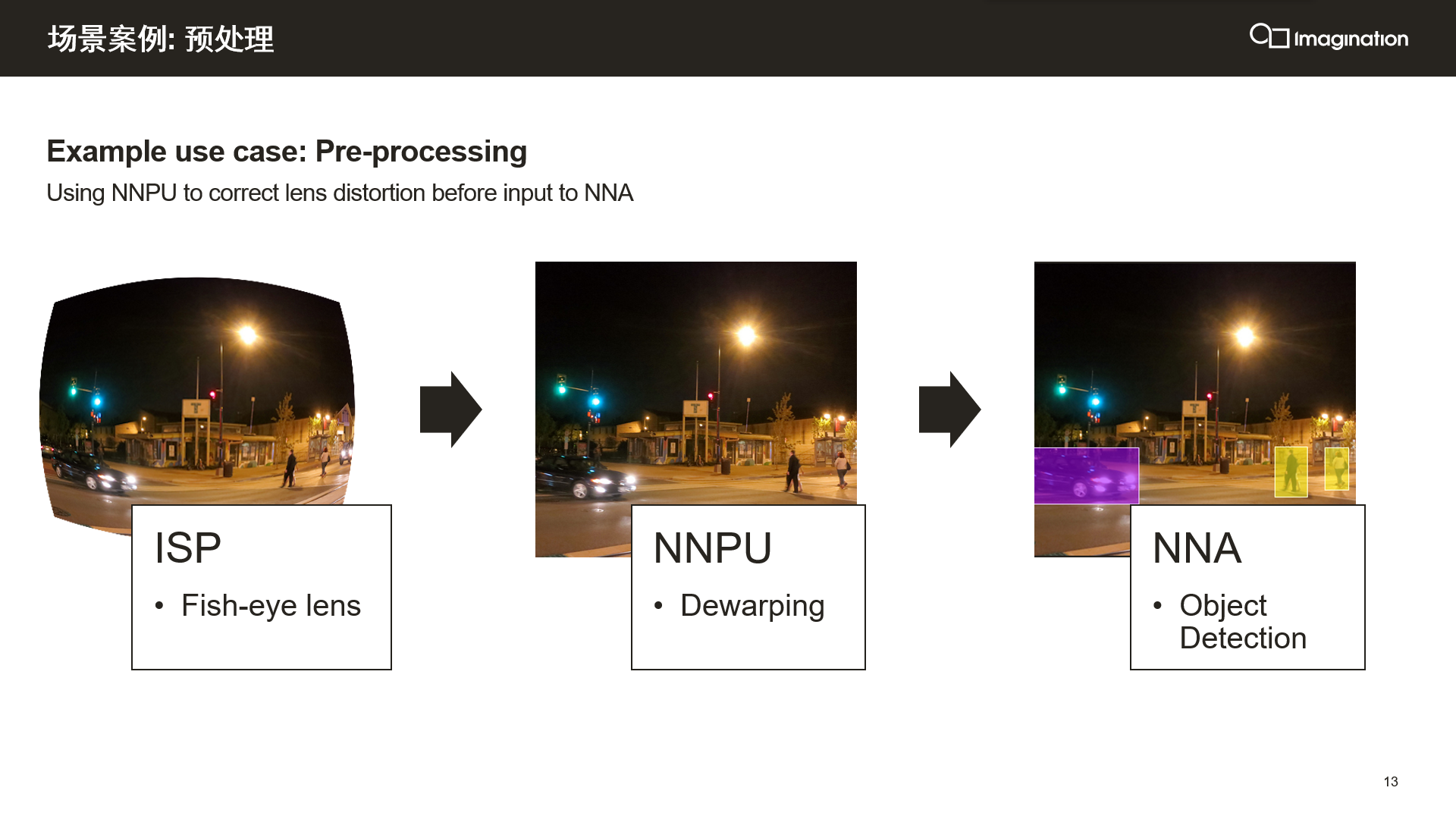

在介绍3NX NNA时,时昕特别强调了Imagination的NNPU技术。NNPU是3NX在2NX基础上新增的一个可编程计算模块,可以针对NNA无法处理的一些计算进行预处理。

例如,通常为了获得更广的视角会使用鱼眼相机,但是拍摄出来的视频会存在畸变,这时就可以使用NNPU利用Dewarping等算法对图像进行校正;又如,多摄像头环绕视图的视频拼接也可以使用NNPU来处理。在NNPU进行预处理之后,再将视频交给NNA,由其针对目标检测/识别等应用进行非常高效的计算和处理。

AI协同构建强大计算平台

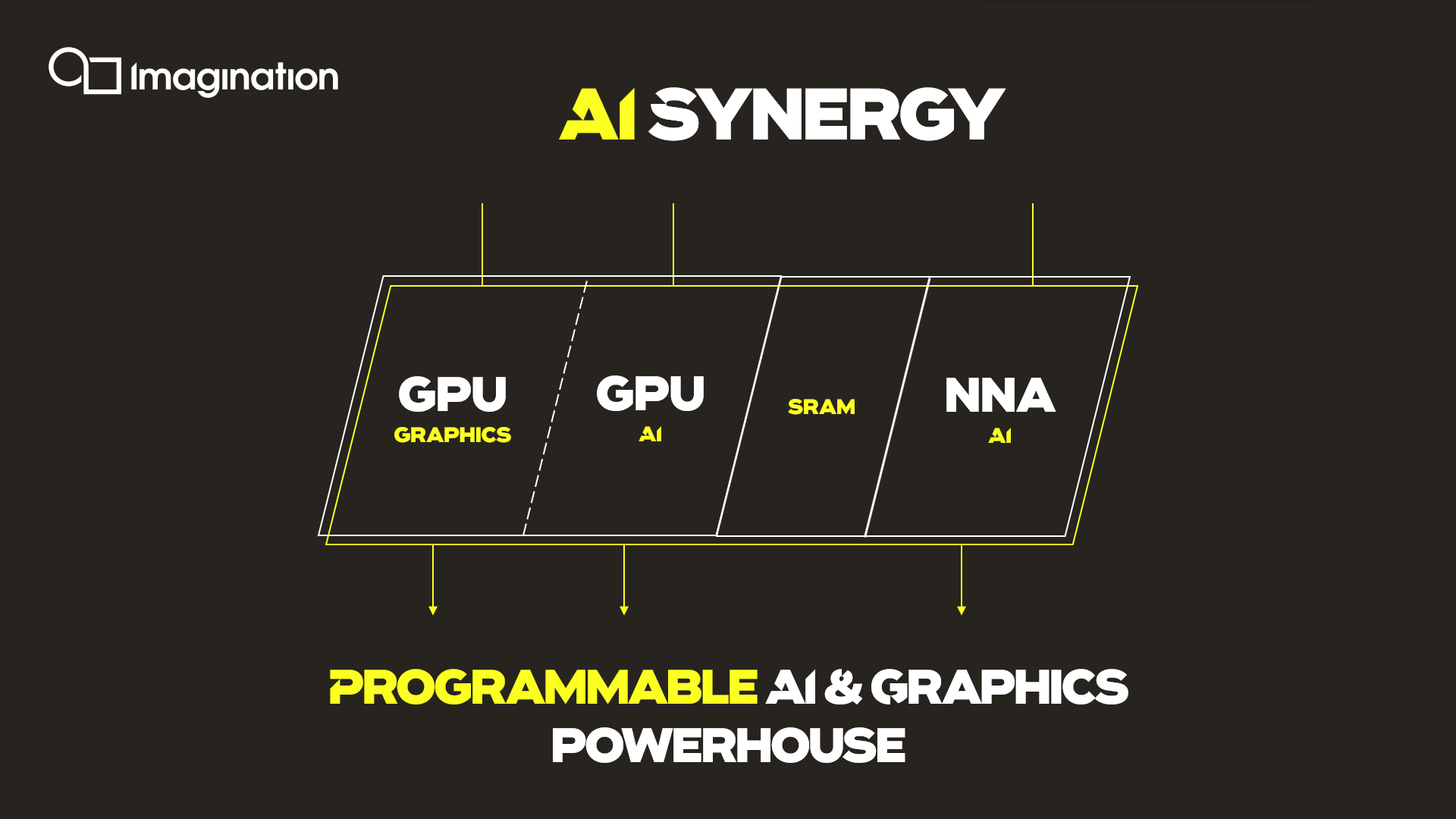

NNA除了可以单独使用外,还可以和Imagination的传统优势产品GPU配合使用,Imagination将这种技术称为AI协同(AI Synergy)。

“我们的GPU在边缘侧和云端都可以支持硬件虚拟化,因此可以将GPU的部分能力用于图像渲染,另一部分能力与NNA加速器配合用于AI计算,从而形成异构AI计算平台。同时,为了减小内存墙的影响,我们采用了片上存储器,可以降低存储带宽和延迟,并且可以和芯片上的其他内核分享存储,从而在提高性能、支持快速处理的同时可以降低成本。”时昕介绍道。

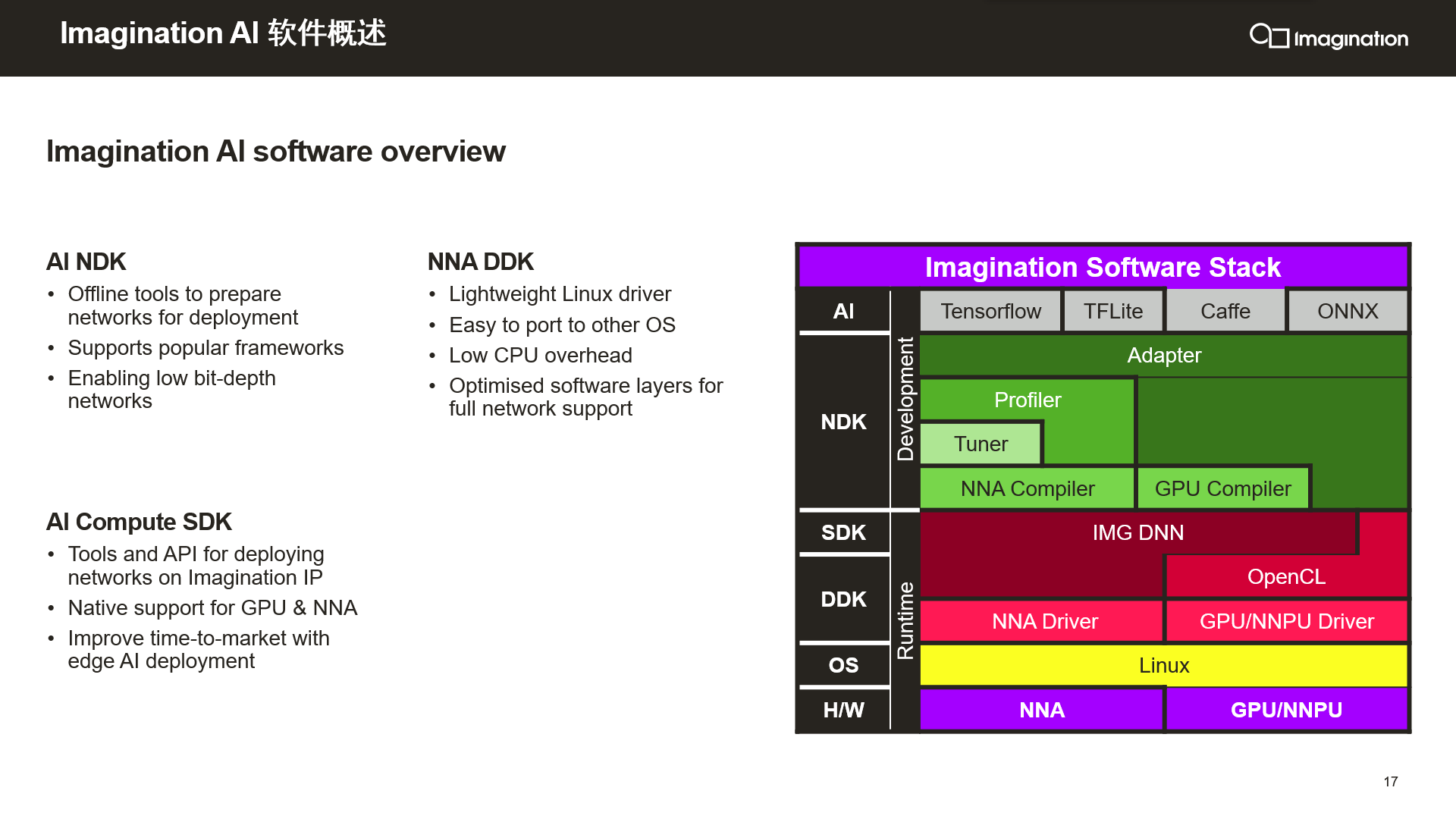

除了硬件外,为了方便AI应用开发者,Imagination还提供了完整的驱动和软件开发套件。一套API即可满足多种方案的开发需求,还支持在GPU和NNA之间互联互通。

此外,Imagination作为Android神经网络API标准的制定和参与者,其软件还可以支持Android开发,开发人员使用NNA API可以将神经网络功能带入基于Android的移动设备。在Android之外,Imagination的软件也完全支持各种常见的Linux和RTOS操作系统。