本文由半导体产业纵横(ID:ICVIEWS)编译自natlawreview

基于5个问题阐述GPU在增强AI和机器学习技术中的作用。

在21世纪初期,研究人员意识到,由于机器学习算法通常具有与图形处理算法相同类型的计算,因此GPU可以为机器学习提供基于CPU计算的更有效的替代方案。尽管近年来基于CPU的可用性和成本限制,但基于GPU的计算已经成为机器学习或神经网络训练的事实标准。基于5个问题阐述GPU 在增强 AI 和机器学习技术中的作用。

GPU是什么?

顾名思义,专业的图形处理单元(GPU)最初是在几十年前设计的,用于高效的执行图像和视频处理等常见的操作。这些过程以基于矩阵的数学计算为特色。人们通常更熟悉中央处理器(CPU),它存在于笔记本电脑、手机和智能设备中,可以执行许多不同类型的操作。

在21世纪初期,研究人员意识到,由于机器学习算法通常具有与图形处理算法相同类型的计算,因此GPU可以为机器学习提供基于CPU计算的更有效的替代方案。尽管近年来基于CPU的可用性和成本限制,但基于GPU的计算已经成为机器学习或神经网络训练的事实标准。

使用GPU的好处是什么?

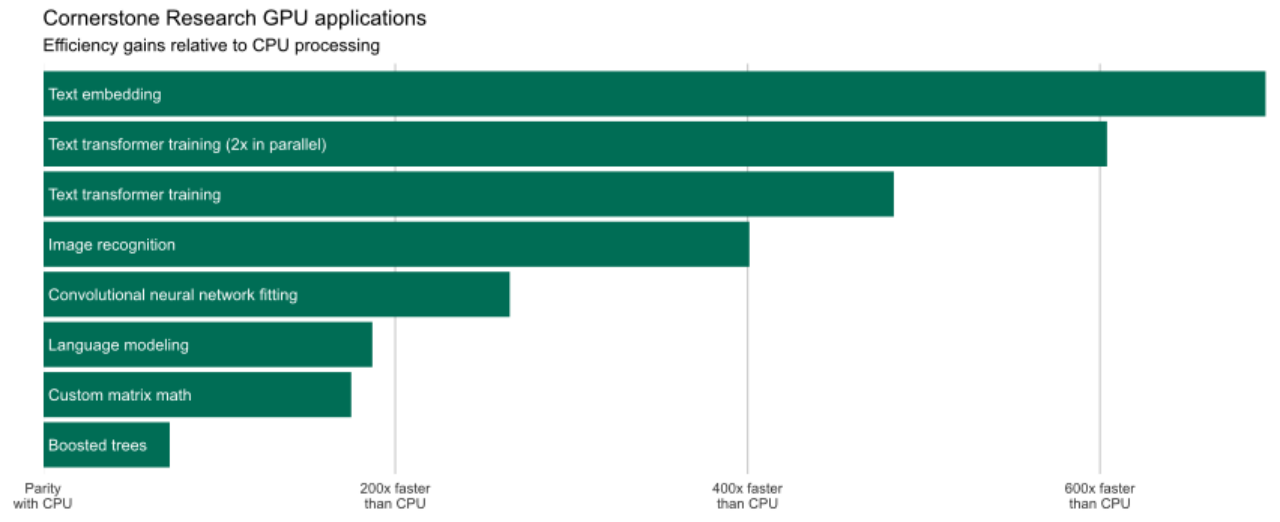

使用GPU最关键的好处就是效率高。GPU提供的计算效率不仅仅是简化了分析过程,它还促进了更广泛的模型训练以获得更高的准确性,扩大了模型搜索过程的范围以防止替代规范,使以前无法实现的某些模型变得可行,并允许对替代数据集增加额外的敏感性以确保其稳健性。

GPU如何支持专家证词?

基于人工智能的系统用数据驱动的决策取代了人类决策。这可以使得在处理大量复杂信息时减少主观性和错误。我们利用人工智能和机器学习来推动越来越复杂的任务的自动化,并解锁新的分析方法,包括使用监督和非监督学习,这些技术都由我们内部的GPU支持。

数据科学中心如何利用GPU进行计算?

我们在案例生命周期的所有阶段(从发现到经济分析)以及从标准表格数据到文本和图像的所有类型的数据都使用GPU。其中一些应用程序依赖于GPU计算已经被广泛使用的应用程序,如神经网络,而另一些应用程序则依赖于更定制的分析框架。下面是一些例子。

矩阵运算

GPU使我们能够快速地执行自定义矩阵运算。例如,在反垄断问题中,我们经常需要计算所有供应商和所有消费者之间的距离(坐标对)。将计算从CPU迁移到GPU使我们能够每秒计算近1亿个坐标对之间的距离。

深层神经网络

围绕基于GPU计算的许多关注的重点都集中在神经网络上。虽然能够处理常规的分类和回归问题,但附加的特定于任务的神经网络体系结构为文本、图像和声音的特定分析提供了一个框架。考虑到这些模型的复杂性和生成可靠结果所需的数据量,如果没有GPU计算资源,它们的使用实际上是无法实现的。当在GPU上训练一个流行的多类图像模型时,与在单个CPU上运行相同的进程相比,我们体验到了25,000%的速度提高。我们在针对消费者欺诈问题的内容分析中利用了这种效率,我们设计文本和图像分类器来表征有问题的营销材料的目标受众。

增强树

随着GPU计算变得越来越普遍,流行的机器学习软件包越来越多地在其产品中包含基于GPU的计算选项。我们经常在回归和分类问题中使用增强树。这些模型依次将多个简单的决策树聚合为一个更大、更准确的学习器。与可能具有数亿个参数的深度神经网络相比,这些模型更小,因此需要更少的数据和训练时间来产生可概括的推理。这些优势使得它们在我们经常遇到的许多类型的分析中比深度神经网络更有用。切换到基于GPU的训练过程使我们能够为这些任务训练模型,其速度比相应的 CPU 规范快近 100 倍。

语言模型

语言模型通常基于一种或多种深度学习技术,可以对文本进行分类、解析和生成。我们使用大型语言模型来提取特定的信息片段,解析实体之间的关系,识别语义关系,并在文本分类问题中补充传统的基于术语的特征,例如在诽谤事件中量化围绕公共实体的社交媒体情绪。

不出所料,考虑到这些模型可以做的所有事情,利用CPU通过这些模型处理文档会给分析过程带来显著的延迟。仅仅使用一个GPU,我们就可以将文档分割成独立的组件,并且每秒可以完全处理几百个句子。

未来我们可以期待这个领域的哪些发展?

GPU和与其相关的软件将继续发展。新的硬件可能具有更多的内核、更快的内核和更多的内存,以适应更大的模型和数据批。新的软件可能会使跨多个GPU,共享模型和数据变得更加容易。

其他发展可能涉及完全不同的设备。为了解决GPU计算中仍然存在的一些效率低下的问题,机器学习从业者越来越多地转向应用特定的集成电路(ASIC)和现场可编程门阵列(FPGA)。例如,谷歌的张量处理单元(TPU)是一个专门为其机器学习TensorFlow软件包执行计算而设计的ASIC。FPGA提供了更大的灵活性,通常用于在需要低延迟、高带宽和最低能耗的生产环境中部署机器学习模型。

本文转自:半导体产业纵横,转载此文目的在于传递更多信息,版权归原作者所有。如不支持转载,请联系小编demi@eetrend.com删除。