摘译 | 李秋娟/赛博研究院实习研究员

来源 | CEPS

2022年9月,CEPS发布题为《使人工智能价值链与<欧盟人工智能法案>相协调》(Reconciling the Ai Value Chain with the Eu’s Artificial Intelligence Act)的研究报告,以七种不同的场景为特征,提出了人工智能价值链的多种类型,讨论了根据《法案》对每种场景的可能处理。

欧盟委员会早在2021年4月提出了《欧盟人工智能法案》(AI Act,以下简称“《法案》”),其试图制定人工智能规则并减轻人工智能风险。目前的法案文本基于人工智能价值链的“线性视图”对人工智能系统进行了规定。但实际上,人工智能价值链可呈现多种配置。有学者呼吁在整个人工智能“价值链”中平衡分配责任,通常的基本假设是人工智能“价值链”可以用标准化的方式来描述。然而,欧盟立法者在起草《法案》时似乎并未充分考虑到市场上已经出现的多种人工智能价值链配置。

事实上,人工智能业务模型多样性的重要作用对《法案》提出了挑战。为了帮助解决这些挑战,本报告研究了人工智能供应链的特定配置,同时考虑了GPAI模型所呈现的复杂性以及开发人员的潜力。本文节选自报告的第1-3部分,拟围绕人工智能价值链进行展开。

什么是人工智能价值链

《法案》在第一个具体目标(1.4.2-1)中提到了人工智能价值链:“为人工智能系统设定特定要求和价值链参与者的义务,以确保投放市场和使用的人工智能系统是安全的、尊重基本权利和联盟价值观的法律”。不过,《法案》尚未明确地定义人工智能价值链。

CEPS将人工智能价值链定义为:开发人工智能系统并投入使用的主体过程。其功能是考虑哪些主体可以在人工智能价值链的哪些部分发挥作用,以确定哪个主体最符合监管要求,保障人工智能系统的安全性。这种对主体过程的关注将人工智能价值链与算法开发区分开来,算法开发的关注点更狭窄地集中在构建人工智能系统的技术步骤上。

《法案》如何构想人工智能价值链

尽管拟议的《法案》没有定义人工智能价值链,但可以从文本中推断出很多东西。它设想了一个相对简单的线性价值链,关键实体被归类为人工智能系统的“提供者”或“用户”。

第3条第(2)款将提供者定义为“开发人工智能系统,或开发人工智能系统以将其投放市场,并以自己的名称或商标提供服务的自然人、法人、公共机构或其他组织”,本质上是在销售或使用之前开发或将人工智能系统集成到产品或软件中的最后一个实体。

第3条第(4)款将用户定义为“在其授权下使用人工智能系统的自然人、法人、公共机构或其他组织,但在个人非专业活动过程中使用人工智能系统的情况除外”。

其中,当人工智能系统在被归类为高风险时,其提供者必须遵守《法案》规定的标准或透明度义务。因此,确定哪些实体被归类为高风险人工智能系统的提供者(PHRAIS)尤为重要。

《法案》第3章详细说明了对PHRAIS和高风险人工智能系统用户的具体要求,包括关于风险管理系统、数据治理、技术文档、记录保存、透明度要求、准确性和稳健性的规定。如果发现人工智能系统违反上述任何规定,PHRAIS必须采取纠正措施。最后,PHRAIS必须经过正式的事前合格评定程序,在欧盟范围内的数据库中注册高风险人工智能系统,建立监管机构联络点,并应监管机构的要求证明其合规性。

与此相比,面向用户的规定相当有限。高风险人工智能系统的用户必须按照PHRAIS提供者的指示使用,保留其功能的相关记录,并监控系统是否存在可能破坏《法案》要求的严重事件或故障。此外,当用户可以控制人工智能系统的输入数据时,它必须确保数据“与预期目的相关”。

至关重要的是,根据《法案》第28条,如果用户、经销商或进口商以自己的名义在市场上投放预先存在的人工智能系统,改变人工智能系统的预期用途或对人工智能系统进行另一次“实质性修改”,那么他们自己将成为提供者,并因此受到提供者的监管要求的约束,而原始PHRAIS将不再被视为《法案》下的提供者。

人工智能价值链的类型及其与《法案》的关系

如上一节所述,《法案》对提供者和用户之间作了相对明确的区分。然而,在考虑不同人工智能商业模式时,对人工智能价值链的解释可能会有所不同。下面考虑的是具有一个实体(类型1)、两个实体(类型2-6)和两个以上实体(类型7)的场景。

类型1-内部人工智能开发和部署

一家公司编写代码并全面训练人工智能模型,供同一公司职能部门内部使用。例如,由仓库公司开发和运营、用于管理和分配任务给仓库员工的人工智能系统。在这种情况下,只存在一个实体,它既是提供者又是用户。如果人工智能系统符合高风险条件,则提供商将是PHRAIS,因此必须通过合格评定流程并满足《法案》的其他要求。

类型2-人工智能系统承包:一个实体为另一实体开发人工智能系统

开发实体作为另一个实体(如公司或政府,发包商)的承包商定制人工智能系统,开发实体本身并不使用人工智能系统或将其投放市场。例如,承包商可以开发用于财务管理的人工智能系统,以识别银行软件中的欺诈行为。

在这种情况下,承包商不被视为《法案》下的提供者。而从承包商处购买人工智能系统的实体如果将人工智能模型投入使用或投放市场,则它将被视为提供者;如果人工智能系统被归类为高风险,则同一实体将成为PHRAIS。

由于承包商没有被定义为提供者,这会激励研发公司通过合同服务开发人工智能系统,从而回避《法案》的规制。最初的PHRAIS通常会通过合格评定流程以出售其人工智能系统,因此结果可能是它们不受欧盟监管机构对这一特定高风险人工智能系统的上市后监督和验证。客户将承担控制和管理人工智能系统的责任。需要确定的是,这种情况是否会促进两个实体加强合作和信息共享,以便PHRAIS能够完全满足《法案》的监管要求。

类型3-受限人工智能系统访问权限:一个实体编写代码并训练系统,然后通过品牌应用程序或API出售访问权限

在这种情况下,该公司允许他人访问人工智能系统,但只能通过闭源软件或API(Application Programming Interface,应用编程接口)访问,防止对模型进行任何更改。

类型1和类型3是对《法案》的简单解释,因为该实体显然是提供者,它开发了人工智能系统并将其投放市场。如果人工智能系统具有高风险,则该公司将被视为PHRAIS。该公司的客户只能访问输入和输出数据,显然是《法案》下规定的用户。商业面部识别应用程序是这种商业模式的典型案例。值得注意的是,API背后GPAI模型的商业化将使这种情况复杂化,因为客户可能会将GPAI模型应用于高风险场景。

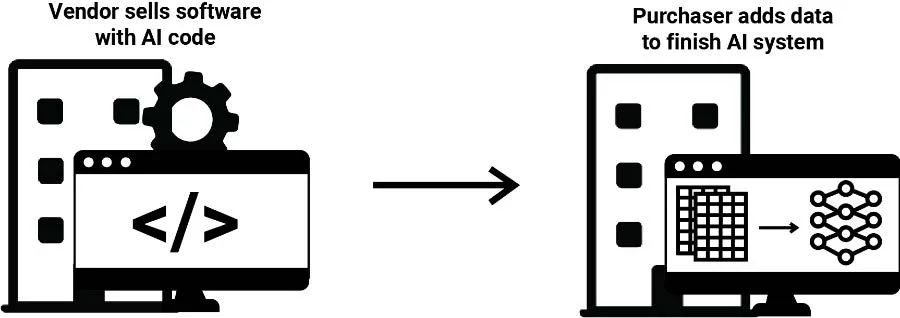

类型4-AI代码软件:为人工智能系统编写代码,但不对其进行预训练或提供训练数据

在这种情况下,代码编写者开发的软件包含客户输入训练数据的过程,之后软件代码会自动运行统计分析并将结果呈现在软件中。代码编写者销售此软件并提供技术协助,采购者输入AI模型使用的所有数据进行使用。在美国,用于设定大学学费的商业软件采用这种方法。高校购买软件后自行添加数据,软件自动训练人工智能模型,进行统计分析并呈现结果。

销售带有AI代码软件的行为并不完全符合《法案》,哪个实体有资格作为提供者以及在何种情况下可能会发生变化尚不清晰。对《法案》的文本解读表明,代码编写者就是提供者,因为他开发了一种技术,一旦添加了数据,就可以满足人工智能系统的定义。但是,有争议认为,由于代码编写者尚未创建人工智能系统,无法“生成输出”,直到采购实体添加训练数据,人工智能系统才能最终完成,因此代码编写者不是提供者。

另有假设认为代码编写者确实有资格成为提供者。如果人工智能系统的预期目的使其成为《法案》下的高风险人工智能系统,那么该代码编写者将是PHRAIS。但是,采购实体也有可能成为PHRAIS,这取决于将培训数据添加到软件中是否算作实质性修改,这由提供者在其合格评定中定义。

类型5-学习人工智能系统

学习人工智能系统,是指人工智能系统作为商业软件包或产品的一部分,可以在用户提供数据时更新其模型,也被称为在线学习。例如,亚马逊Alexa中的语音识别人工智能系统可以适应来自特定人类声音的新数据,使用时能够继续收集数据并进行更新。

在这种情况下,采购实体可以提供足够的输入数据来改变软件或产品的功能。这是否构成“重大修改”,将取决于原始提供商的预定标准。基于此,未来关于人工智能系统责任的立法倡议可能会以“合理可预见的使用”为标准释明用户对人工智能系统“滥用”的定义。

类型6-人工智能系统微调:一个实体的初始开发和另一个实体的微调

一个开发人员训练了一个人工智能系统,然后将其出售给另一开发人员,第二个开发人员对人工智能系统进行微调意味着他将使用额外的训练数据来改进人工智能系统的功能或使其适应更具体的环境或任务。这与类型3、4和5不同,因为此种类型中第二个开发人员可以直接访问人工智能系统并进行自由操作。

通常,用于训练第一个人工智能系统的数据集更大、更通用,而用于微调的数据集更小、更具体。由第一个开发人员训练的通用问答聊天机器人,在与第二个开发人员相关的特定领域知识(例如保险信息)上重新训练并出售给用户,就是这种商业模式的典型例子。

在这种情况下,一旦他们销售或使用人工智能系统,则两个开发者都是提供者。但是,哪个开发者是PHRAIS要取决于具体情况。如果最初的人工智能系统风险不高,那么它的开发者只是提供者,而不是PHRAIS。如果第二个开发者购买了该人工智能系统,然后针对高风险应用程序对其进行微调,从而改变其用途,那么该第二个开发者就是唯一的PHRAIS。

然而,如果原始系统是高风险的,而第二个开发人员为了相同或其他高风险的目的对模型进行微调,那么第一个开发人员就是PHRAIS;第二个开发人员也可以是PHRAIS,但这取决于其是否符合第一个开发人员在合格评定中设定的实质性修改条款。由于第二个开发者可以直接访问人工智能系统并且评估和修改其功能,因此第二个开发人员承担PHRAIS监管责任更为合理。

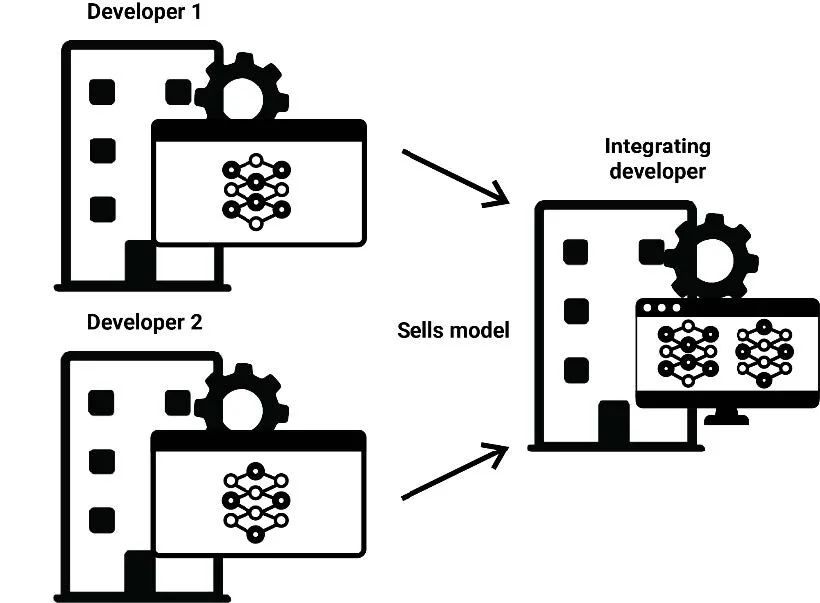

类型7-人工智能模型集成:一个实体将不同的人工智能系统集成到新的系统中

在这种情况下,可能存在很多开发人员。例如,一家公司可以将来自不同开发人员用于计算机视觉、音频分析和自然语言处理的人工智能系统整合到一个软件中。或者,模型集成中可能包括多个人工智能系统,以改善它们在某种特定任务(集成)上的集体功能。在这一类型中还含有“苏格拉底模型”——一种通过训练而在给定的几个人工智能系统之间进行选择的新技术。在学生参加考试时使用人工智能模型分析视频、音频、文本输入的商业监考软件即为此典型。

如果预先存在的人工智能系统风险不高,而集成开发人员将其重新用于高风险系统投放市场,则集成开发人员将是唯一的PHRAIS。如果预先存在的人工智能系统具有高风险,那么第一批开发人员将是PHRAIS;同时集成开发人员也可能是PHRAIS,因为将人工智能系统组合到更广泛的软件中可能会构成实质性修改,并且符合《法案》第28条规定的预期目的改变。和最初的开发人员一样,集成公司必须对新的集成人工智能系统进行合格评定。

3.1 人工智能价值链类型的要点

上述的人工智能价值链的异质性,至少有七种不同的流程类型,揭示了《法案》未来应用的一些要点,包括:

1、在几种类型的人工智能价值链中,关于哪个实体通常是PHRAIS存在相当大的歧义。对于第2类(人工智能系统承包)和第6类(人工智能系统微调)尤其如此,尽管它也可能适用于第4类(带有人工智能代码的软件)、第5类(学习人工智能系统)和第7类(人工智能模型集成)。

2、在具有两个实体的人工智能价值链中,任何一个实体都不能完全有能力评估和改变人工智能系统,以满足PHRAIS的监管义务。这对于带有AI代码的软件来说尤甚,因为任何单一实体都无法控制代码和数据。

3、在现实情况下,PHRAIS将在实体之间转移。《法案》第28条规定了具体的发生场景,即人工智能系统的预期目的已经改变,或者对该人工智能系统的更改符合“重大修改”的定义。

4、合同语言将在多种类型的人工智能价值链中发挥关键作用。它可以确保两个实体在第2类(人工智能系统合同)和第4类(具有人工智能代码的软件)中就合格评定过程或特定人工智能要求(如风险管理)进行合作。

本文转自:赛博研究院,转载此文目的在于传递更多信息,版权归原作者所有。如不支持转载,请联系小编demi@eetrend.com删除。