问题描述

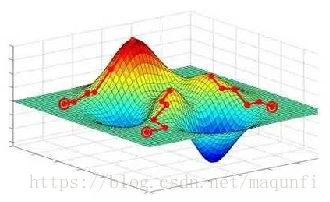

一般的梯度下降方法寻找的是loss function的局部极小值,而我们想要全局最小值。如下误差曲面图所示,我们希望loss值可以降低到右侧深蓝色的最低点,但loss有可能“卡”在左侧的局部极小值中,也就是图中红线所走的路径。

方案

为了防止卡到'局部最优点',我们有以下几个方法:

[1]使用随机梯度下降代替真正的梯度下降。可以这样理解,每次针对单个数据样例进行摸索前进时,本质上是在一个样例形成的误差曲面上摸索前进,而每个样例的曲面大体类似,又不尽相同,当你掉入一个坑里时,往往能被别的曲面拽出来。

[2]设置冲量。人如其名,本次前进的步伐,根据上一次的步伐,适当调大,好比从高处降落的石头,会更有机率跨过一些小坑,如果坑非常大,依靠冲量的惯性是没法逃出的。

[3]不同的初始权值进行训练。假定误差曲面是个坑坑洼洼的曲面,我们尝试第一次降落到随机的起点,然后再开始摸索前进,也许会有运气好的一次,能够不落在某个小坑附近,多次尝试权重,可能会找到好的全局点。

来源:CSDN,作者:马飞飞

原文:https://blog.csdn.net/maqunfi/article/details/82634529

版权声明:本文为博主原创文章,转载请附上博文链接!