在本篇我们会讨论HMM模型参数求解的问题,这个问题在HMM三个问题里算是最复杂的。在研究这个问题之前,建议先阅读这个系列的前两篇以熟悉HMM模型和HMM的前向后向算法,以及EM算法原理总结,这些在本篇里会用到。在李航的《统计学习方法》中,这个算法的讲解只考虑了单个观测序列的求解,因此无法用于实际多样本观测序列的模型求解,本文关注于如何使用多个观测序列来求解HMM模型参数。

隐马尔科夫模型HMM(一)HMM模型

隐马尔科夫模型HMM(二)前向后向算法评估观察序列概率

1. HMM模型参数求解概述

HMM模型参数求解根据已知的条件可以分为两种情况。

第一种情况较为简单,就是我们已知 D 个长度为 T 的观测序列和对应的隐藏状态序列,即 { ( O1 , I1 ) , ( O2 , I2 ) ,... ( OD , ID ) } 是已知的,此时我们可以很容易的用最大似然来求解模型参数。

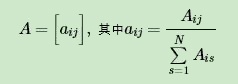

假设样本从隐藏状态 qi 转移到 qj 的频率计数是 Aij , 那么状态转移矩阵求得为:

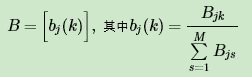

假设样本隐藏状态为 qj 且观测状态为 vk 的频率计数是 Bjk , 那么观测状态概率矩阵为:

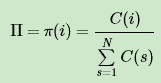

假设所有样本中初始隐藏状态为 qi 的频率计数为 C(i) , 那么初始概率分布为:

可见第一种情况下求解模型还是很简单的。但是在很多时候,我们无法得到HMM样本观察序列对应的隐藏序列,只有 D 个长度为 T 的观测序列,即 { ( O1 ) , ( O2 ) , ... ( OD ) } 是已知的,此时我们能不能求出合适的HMM模型参数呢?这就是我们的第二种情况,也是我们本文要讨论的重点。它的解法最常用的是鲍姆-韦尔奇算法,其实就是基于EM算法的求解,只不过鲍姆-韦尔奇算法出现的时代,EM算法还没有被抽象出来,所以我们本文还是说鲍姆-韦尔奇算法。

2. 鲍姆-韦尔奇算法原理

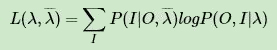

鲍姆-韦尔奇算法原理既然使用的就是EM算法的原理,那么我们需要在E步求出联合分布 P ( O , I | λ ) 基于条件概率 P ( I | O ,  ) 的期望,其中

) 的期望,其中 为当前的模型参数,然后再M步最大化这个期望,得到更新的模型参数λ。接着不停的进行EM迭代,直到模型参数的值收敛为止。

为当前的模型参数,然后再M步最大化这个期望,得到更新的模型参数λ。接着不停的进行EM迭代,直到模型参数的值收敛为止。

首先来看看E步,当前模型参数为 , 联合分布 P ( O , I | λ ) 基于条件概率 P ( I | O ,

, 联合分布 P ( O , I | λ ) 基于条件概率 P ( I | O ,  ) 的期望表达式为:

) 的期望表达式为:

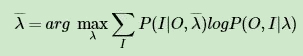

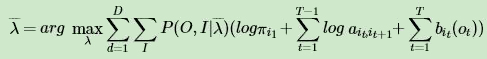

在M步,我们极大化上式,然后得到更新后的模型参数如下:

通过不断的E步和M步的迭代,直到 收敛。下面我们来看看鲍姆-韦尔奇算法的推导过程。

收敛。下面我们来看看鲍姆-韦尔奇算法的推导过程。

3. 鲍姆-韦尔奇算法的推导

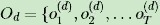

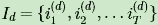

我们的训练数据为 { ( O1 , I1 ) , ( O2 , I2 ) ,... ( OD , ID ) } ,其中任意一个观测序列 , 其对应的未知的隐藏状态序列表示为:

, 其对应的未知的隐藏状态序列表示为:

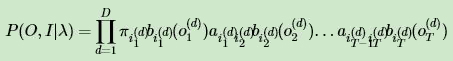

首先看鲍姆-韦尔奇算法的E步,我们需要先计算联合分布 P ( O , I | λ ) 的表达式如下:

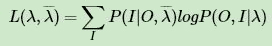

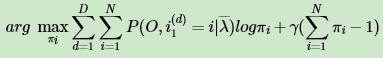

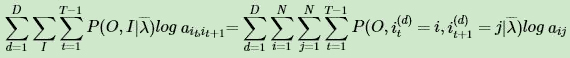

我们的E步得到的期望表达式为:

在M步我们要极大化上式。由于 P ( I | O ,  ) = P( I , O |

) = P( I , O |  ) / P ( O |

) / P ( O |  ) , 而 P ( O |

) , 而 P ( O |  ) 是常数,因此我们要极大化的式子等价于:

) 是常数,因此我们要极大化的式子等价于:

我们将上面 P ( O , I | λ ) 的表达式带入我们的极大化式子,得到的表达式如下:

我们的隐藏模型参数 λ = ( A , B , Π ) , 因此下面我们只需要对上式分别对 A , B , Π 求导即可得到我们更新的模型参数

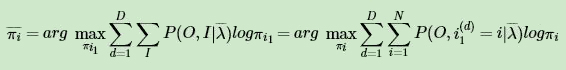

首先我们看看对模型参数 Π 的求导。由于 Π 只在上式中括号里的第一部分出现,因此我们对于 Π 的极大化式子为:

由于 πi 还满足 ,因此根据拉格朗日子乘法,我们得到 πi 要极大化的拉格朗日函数为:

,因此根据拉格朗日子乘法,我们得到 πi 要极大化的拉格朗日函数为:

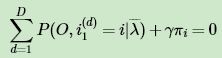

其中,γ 为拉格朗日系数。上式对 πi 求偏导数并令结果为 0, 我们得到:

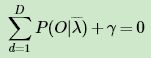

令 i 分别等于从 1 到 N ,从上式可以得到 N 个式子,对这 N 个式子求和可得:

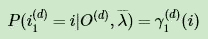

从上两式消去 γ , 得到 πi 的表达式为:

利用我们在隐马尔科夫模型HMM(二)前向后向算法评估观察序列概率里第二节中前向概率的定义可得:

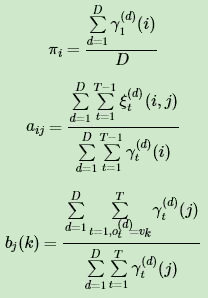

因此最终我们在 M 步 πi 的迭代公式为:

现在我们来看看 A 的迭代公式求法。方法和 Π 的类似。由于 A 只在最大化函数式中括号里的第二部分出现,而这部分式子可以整理为:

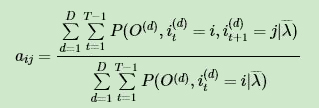

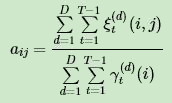

由于 aij 还满足 。和求解 πi 类似,我们可以用拉格朗日子乘法并对 aij 求导,并令结果为 0 ,可以得到 aij 的迭代表达式为:

。和求解 πi 类似,我们可以用拉格朗日子乘法并对 aij 求导,并令结果为 0 ,可以得到 aij 的迭代表达式为:

利用隐马尔科夫模型HMM(二)前向后向算法评估观察序列概率里第二节中前向概率的定义和第五节 ξt( i , j ) 的定义可得们在 M 步 aij 的迭代公式为:

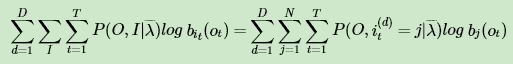

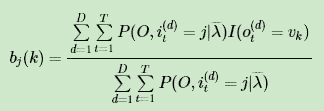

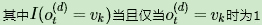

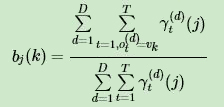

现在我们来看看 B 的迭代公式求法。方法和 Π 的类似。由于 B 只在最大化函数式中括号里的第三部分出现,而这部分式子可以整理为:

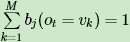

由于 bj ( ot ) 还满足 。和求解 πi 类似,我们可以用拉格朗日子乘法并对 bj ( k ) 求导,并令结果为 0,得到 bj ( k ) 的迭代表达式为:

。和求解 πi 类似,我们可以用拉格朗日子乘法并对 bj ( k ) 求导,并令结果为 0,得到 bj ( k ) 的迭代表达式为:

,否则为0。利用隐马尔科夫模型HMM(二)前向后向算法评估观察序列概率里第二节中前向概率的定义可得 bj ( ot ) 的最终表达式为:

,否则为0。利用隐马尔科夫模型HMM(二)前向后向算法评估观察序列概率里第二节中前向概率的定义可得 bj ( ot ) 的最终表达式为:

有了 πi , aij , bj ( k ) 的迭代公式,我们就可以迭代求解HMM模型参数了。

4. 鲍姆-韦尔奇算法流程总结

这里我们概括总结下鲍姆-韦尔奇算法的流程。

输入: D个观测序列样本 { ( O1 ), ( O2 ) , ... ( OD ) }

输出:HMM模型参数

1)随机初始化所有的 πi , aij , bj ( k )

3) 更新模型参数:

4) 如果 πi , aij , bj ( k ) 的值已经收敛,则算法结束,否则回到第2)步继续迭代。

以上就是鲍姆-韦尔奇算法的整个过程。

(欢迎转载,转载请注明出处。欢迎沟通交流: liujianping-ok@163.com)

本文转自:博客园 - 刘建平Pinard,转载此文目的在于传递更多信息,版权归原作者所有。