卷积神经网络的发展主要是为了解决人类视觉问题,不过现在其它方向也都会使用。发展历程主要从Lenet5->Alexnet->VGG->GooLenet->ResNet等。

Lenet5

上世界80年代发明了卷积层,但由于硬件限制无法构建复杂网络,直到后面90年代才开始有实践。

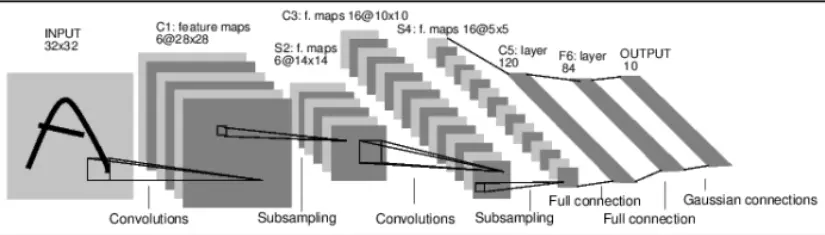

1998年LeCun提出卷积层、池化层和完全连接层组合,以此来解决手写数字的识别问题。此时的效果已经很不错了,能与其它经典的机器学习模型相比。架构如下,一个32 x 32的输入,通过卷积提取特征,然后进行下采样,再一次卷积和下采样,后面进行全连接和高斯连接。

Alexnet

后来随着可用的结构化数据和处理能力呈指数增长,使得模型能进一步增强,特别是Imagenet开源数据集的出现,数百万张被标记分类的图像。

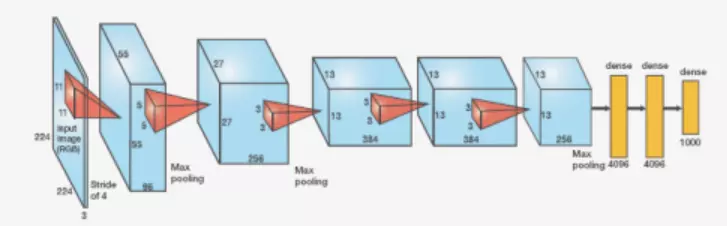

2012年的LSVRC挑战赛,Hinton和他学生Alex Krizhevsky开发了Alexnet深度卷积网络,结构类似Lenet5,但是卷积层深度更深,参数总数达数千万。结构如下,多个卷积层且每个网络深度都达数百。

VGG

2014年LSVRC挑战赛强大的竞争者,由牛津大学视觉几何组织提出的VGG模型。比起Alexnet,它主要是将卷积核缩小了,全部改用3x3。如下图为VGG结构,大体结构一致,但卷积配置可以不同。激活函数使用ReLU,池化使用max pooling,最后使用softmax输出各项概率。

GoogLenet

2014年,该网络模型赢得LSVRC挑战赛,该系列赛首次由大型公司参赛并获得成功,此后也一直由拥有巨额预算的大公司赢得比赛。

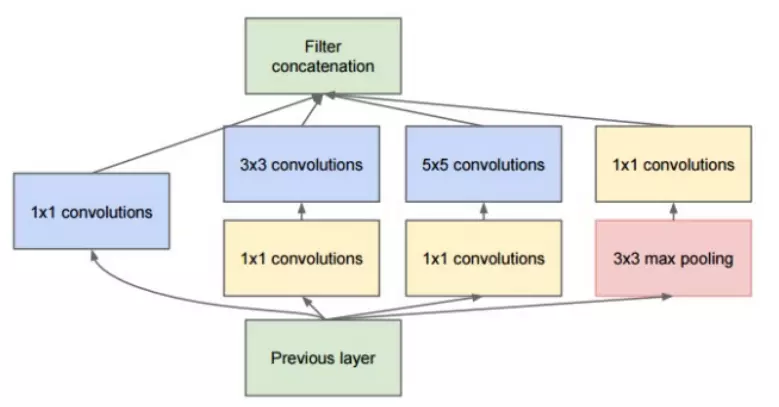

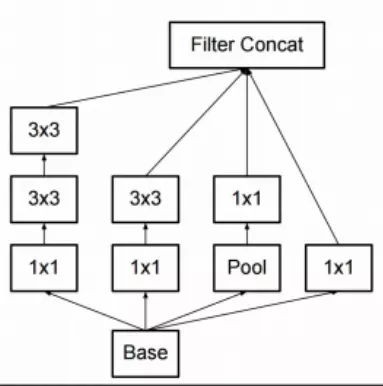

GoogLenet 主要由9个Inception模块组合而成,其中只进行很小的改动。Inception模块结构如下图,

GoogLenet参数数量降到了一千多万,并且准确性比Alexnet提高,误差从16.4%降到6.7%。

2015年随着《重新思考计算机视觉的Inception架构》文章发表,google研究人员发布新的Inception架构,主要解决协方差移位问题,其中将规范化应用于原始输入及每层的输出值。除此之外卷积核大小也有所变化,且增加了网络总体深度及卷积的分解。

ResNet

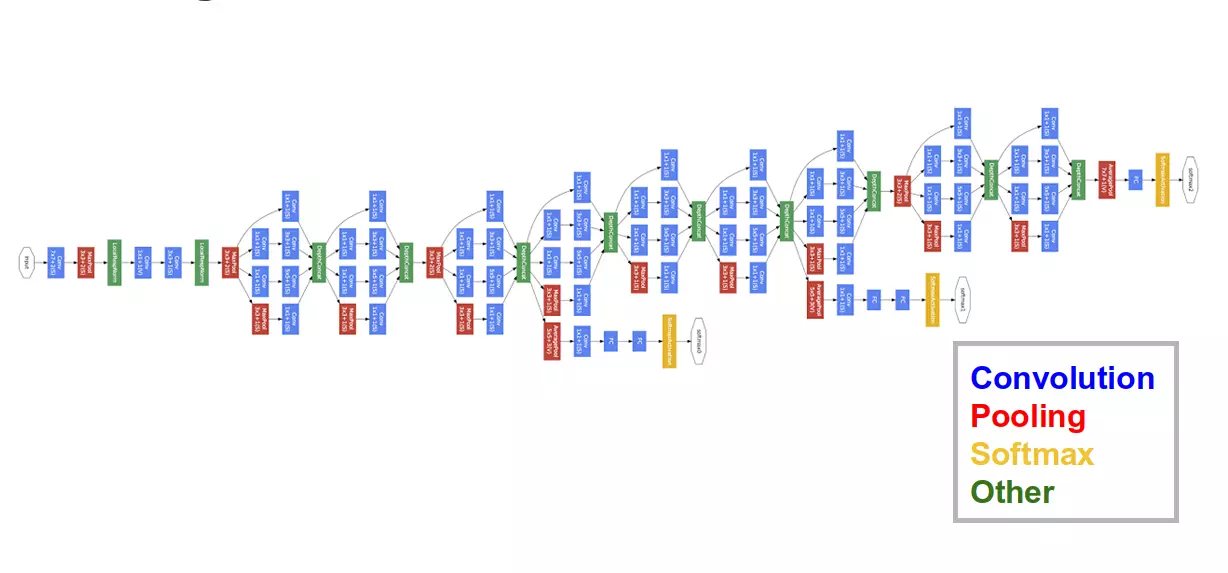

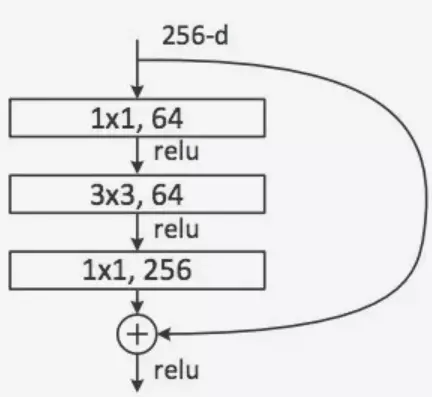

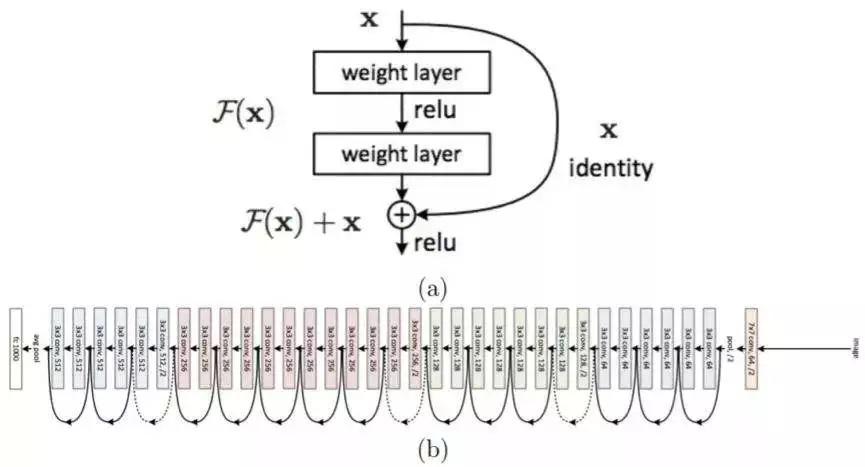

2015年ResNet被提出,由原来微软研究院何恺明博士提出,现为Facebook AI研究科学家。ResNet战绩辉煌,当年一下取得5项第一。ResNet网络中的模块如下图,

该模块的卷积部分第一个1 x 1的卷积把256维降到64维,接着进入3 x 3滤波器层,最后再通过1 x 1卷积恢复256维。组合的形式大致如下。

作者:超人汪小建

链接:https://juejin.im/post/5ba6fb366fb9a05d1b2e54c8

来源:掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。