在讨伐算法导致的偏见和产生的作用时,更重要的问题是:与完全没有使用算法的情况相比是怎样的?我们应该比较算法的缺陷与人类的缺陷,而不是简单地询问算法是否存在缺陷。

一场革命正在悄然进行。

这场革命与大部分新闻报道中出现的人工智能的进展有所不同。

新闻媒体往往聚焦于感知型机器人军团的重大发展,而更重要的角逐是在全国各类机构传统人为决策过程中展开,很显然,自动化比重正在稳步增加。

不同于AlphaGo Zero这样占据头条新闻的先进成果,这场革命通过相当传统的机器学习和统计技术如普通最小二乘法、逻辑回归、决策树等,为许多组织创造了真正的价值。

这些技术应用的领域是很广泛的,包括医疗诊断、司法判决、公共机构的专业招聘和资源分配等。

这场革命是好事吗?

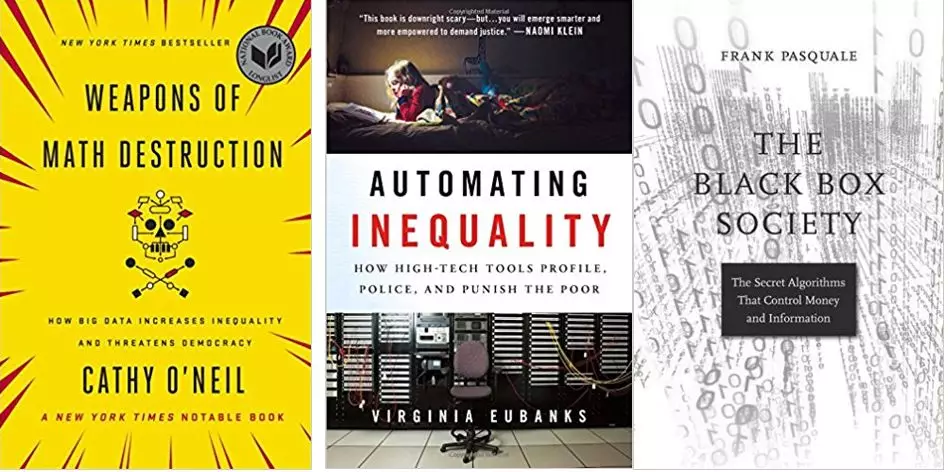

似乎有越来越多的作者、学者和记者给予否定的回答。这一类型的书包括《数学毁灭武器》,《自动化不平等》和《黑匣子协会》等。还有一连串的曝光式长篇文章,如“机器偏差”,“紧缩是一种算法”,“算法是否在构建种族主义的新基础设施?”等。

人们关注的焦点是,算法通常是不透明、有偏差并且难以解释的工具,而这样的工具正在被权利组织加以利用。那么,对于算法逐渐上升的决策地位,人类需不需要感到担忧呢?

这些批评和调查往往很具有洞察力和启发性,并且成功地让人们认为“算法是完全不受主观影响”是不可能的。但是这些批评者之间存在一种模式,即他们很少会探讨他们分析的系统在没有算法参与的情况下运行得如何。

对于从业者和政策制定者而言,这是最相关的问题:算法导致的偏见和产生的作用,与完全没有使用算法的情况相比是怎样的?我们应该比较算法的缺陷与人类的缺陷,而不是简单地询问算法是否存在缺陷。

研究结果怎么说?

关于算法决策的大量研究可以追溯到几十年前。与这一主题相关的研究都得出了一个非常相似的结论:算法比他们所取代的人类更少偏见、更准确。

下面是一个研究样本,调查了当算法控制了传统上由人类执行的任务时会发生什么:

2002年,一个经济学家团队研究了自动承保算法对抵押贷款行业的影响。他们的主要发现是“[自动承保]系统比手动承销商更准确地预测违约”并且“提高了预测借款批准率的准确性,特别是对于通常服务不到的申请人。”在传统的方法中,资源匮乏的消费者往往被边缘化;但算法系统使这部分消费者受益最多。

Bo Cowgill来自哥伦比亚商学院(Columbia Business School),他在研究一家软件公司的工作申请筛选算法的效果时得出了类似的结论。当公司通过算法来决定哪些申请人应该接受面试时,算法实际上比人类筛选者更喜欢“非传统”候选人。与人类相比,该算法对公司中代表性不足的候选人(例如没有个人引荐或没有拥有名牌大学的学位)的偏见显著偏少。

在纽约市审前保释听证会中,一支由著名计算机科学家和经济学家组成的团队判定,与目前作出保释决定的法官相比,算法有可能实现更为公平的决策,“监禁率减少高达41.9%,犯罪率没有增加”。他们还发现,在他们的模型中,“所有类别的犯罪,包括暴力犯罪中,都显示出监禁率的降低。这些成果可以在减少种族差异的过程中同时实现。”

《纽约时报》杂志最近报道了一个长篇故事来回答这个问题,“算法可以判断孩子何时处于危险之中吗?”

事实证明答案是肯定的,并且算法可以比人类更准确地执行这项任务。有些政府服务加剧了种族偏见,而“阿勒格尼郡的经验表明,它的筛选工具在权衡偏见方面不像人类筛选者那么糟糕”。

最后一个例子是,一个由财务教授组成的团队开始通过查看公开交易公司的历史数据构建算法,为特定公司选择最佳董事会成员。研究人员发现公司在由算法选择的董事会的管理下业绩更好,而且与他们提出的算法相比,“没有算法的公司倾向于选择拥有庞大的社交网络与丰富的董事会经验、目前在董事会参与更多、具有财务背景的男性董事。”

在每个案例研究中,数据科学家都做了一件看起来惊人事情:他们根据过去的数据训练他们的算法,而这些数据肯定会受到历史偏见的影响。所以这是怎么回事呢?

在很多不同的领域 ——信用申请、工作筛选、刑事司法、公共资源分配和公司治理 ,算法都可以减少偏见;但为什么许多评论家和批判者告诉我们的却正好相反呢?

人类是非常糟糕的决策者

我们可以看到,上述提到的算法实际上是存在偏见的,但它们正在取代的人类显然有更大的偏差。毕竟,如果不是一直被人为控制,制度偏见从何而来?

人类是糟糕到极点了么?也不尽然。虽然存在着偏见,但在某些维度上看,我们也做过一些较好的决策。不幸的是,近几十年来,判断和决策方面的心理学研究已经一次又一次地证明了人类在各种背景下的判断非常糟糕。我们至少在20世纪50年代就已经知道,在预临床环境中的重要结果方面,非常简单的数学模型就已优于所谓的专家。

在上面提到的所有例子中,人类决策者的表现并不好,用算法取代他们既提高了准确性,又降低了制度偏差。这就达到了经济学家所说的帕累托改进,即一项政策在我们关心的每一个方面上都有更优越的表现。

虽然许多批评者喜欢暗示前沿公司以牺牲公平和公正为代价来追求运营效率和更高的生产力,但当前的证据都表明其实没有这样的让步。算法可以提供更高效,更公平的结果。

如果有什么事情会让你感到惊恐,那么应该是这样一个事实:我们的许多重要决策是由前后矛盾的,有偏见的,非常糟糕的决策者做出的。

改善现状

当然,我们应该尽一切努力消除制度偏见及其对决策算法的有害影响。对算法决策的批评催生了机器学习的研究的新浪潮,人们更加重视算法的社会和政治后果。

统计学和机器学习中出现了一些新技术,专门用于解决算法歧视问题。每年甚至还有一次学术会议(https://www.fatml.org),研究人员不仅讨论机器学习的伦理和社会挑战,而且还提出了确保算法对社会产生积极影响的新模型和新方法。

随着深度学习等不太透明的算法变得越来越普遍,这项工作可能会变得更加重要。 即使技术不能完全解决制度偏见和偏见歧视的社会弊端,这里所回顾的证据表明,在实践中,它在改善现状方面发挥着微小但重要的作用。

这不是在鼓吹算法绝对主义或对统计力量的盲目信仰。如果我们在某些情况下发现算法与当前的决策过程相比具有不可接受的高度偏差,那么接受这样的结果并维持人类决策现状也不会造成任何损害。

但是,维持现状也是有利有弊。

我们应该承认,在某些情况下,算法将会为减少制度偏见起到一些作用。因此,下次当您读到有关算法偏差风险的标题时,请记得冷静下来,并想一想人类偏见带来的危险是否会更严重。

相关报道:

https://hbr.org/2018/07/want-less-biased-decisions-use-algorithms

转自:大数据文摘

编译:倪倪、陈同学、Alieen