传统意义上的AI模型,主要分为判别式模型(Discriminative Models)和生成式模型(Generative Models)。

判别式模型(Discriminative Models):用于解决回归或分类任务,重点在于区分不同类别的数据。与生成模型不同,判别模型不生成新数据,而是专注于学习输入特征与输出标签之间的关系,以便准确地进行分类或预测。判别式模型在各种应用中广泛使用,特别是在需要分类或回归任务的场景中,例如:BERT(用于各种NLP任务)、金融风险评估的信用评分系统(如FICO)、癌症检测系统等等。

而生成式模型(Generative Models):是生成式AI背后的技术,是一类能学习和模仿数据分布的模型,它们能够创建看起来与训练数据相当相似的新数据样本。举个例子,如果我们有一个人脸生成模型,它可以生成看起来像真人脸的图片,而这些图片与模型用来训练的真实人脸图片很相似,甚至很难区分哪个是生成的,哪个是真实的。生成式模型已被广泛应用于各种领域,特别是在需要生成新数据样本的任务中,例如:GPT、DALL-E(图像生成)、DeepArt和Prisma(图像风格转换)等等。

大模型是“大算力+强算法”结合的产物。大模型通常是在大规模无标注数据上进行训练,学习出一种特征和规则。基于大模型进行应用开发时,将大模型进行微调,如在下游特定任务上的小规模有标注数据进行二次训练,或者不进行微调,就可以完成多个应用场景的任务。

从参数规模上看,AI大模型先后经历了预训练模型、大规模预训练模型、超大规模预训练模型三个阶段,参数量实现了从亿级到百万亿级的突破。从模态支持上看,AI大模型从支持图片、图像、文本、语音单一模态下的单一任务,逐渐发展为支持多种模态下的多种任务。

人工智能领域中的一些重要基础技术概念如下:

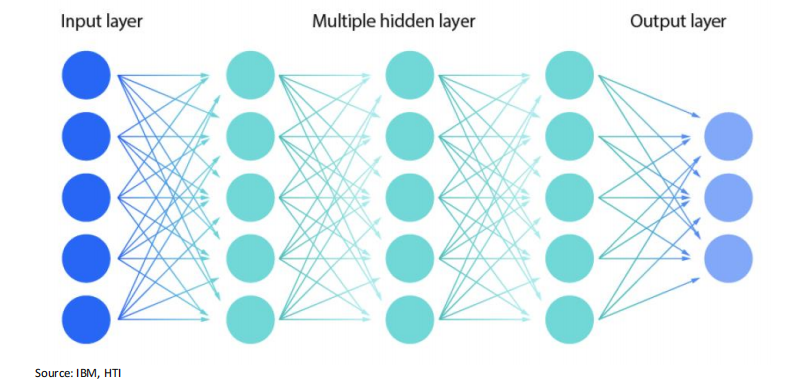

(1)神经网络技术(Neural Network Technology):是一种模仿生物神经系统结构和功能的计算方法。神经网络的结构通常分为输入层、隐藏层和输出层。输入层接受原始数据,隐藏层负责数据的特征提取和处理,输出层生成预测结果。神经网络技术可以处理复杂数据和任务,已在人工智能和机器学习领域中广泛应用。

(2)神经符号推理(Neuro-Symbolic Reasoning)结合了神经网络和符号推理的混合方法,利用两种技术的优势来解决复杂的推理和学习任务。这种方法在人工智能领域具有广泛的应用前景,因为它能够处理复杂的数据和关系,同时保留符号逻辑的可解释性和规则性。

(3)尺度定律(Scaling Law)是指在训练模型时,模型性能随模型规模(如参数数量)、训练数据量和计算资源的增加而变化的规律。这些定律帮助研究人员和工程师更好地理解和预测扩展模型时的效果和需求。在GPT-3的开发过程中,OpenAI遵循了尺度定律,通过大幅增加模型参数数量(达到1750亿),显著提高了模型的自然语言处理能力。而摩尔定律(Moore's Law)应用于半导体和计算机硬件领域,具体说的是当价格不变时,集成电路上可容纳的晶体管数目,每隔18个月便会增加一倍,意味着性能也将提升一倍。两个定律应用领域不同,但都体现了技术进步在各自领域内的驱动力。

(4)自然语言处理技术(Natural Language Processing,NLP):包括词法分析、句法分析、语义理解等。这些技术帮助模型更好地理解和生成自然语言文本,使得生成的文本更加准确和语义丰富。

(5)大规模数据集(Dataset):海量的高质量数据是训练生成式 AI 模型的关键。这些数据集包含丰富的语言知识和模式,能够帮助模型学习到更好的表示和生成能力。

( 6)无监督学习算法(Unsupervised Learning):能够从数据中自动发现模式和特征,无需人工标记的监督信息。这对于生成式AI 模型的训练至关重要,可以使模型从大量未标记的数据中学习到有用的知识。

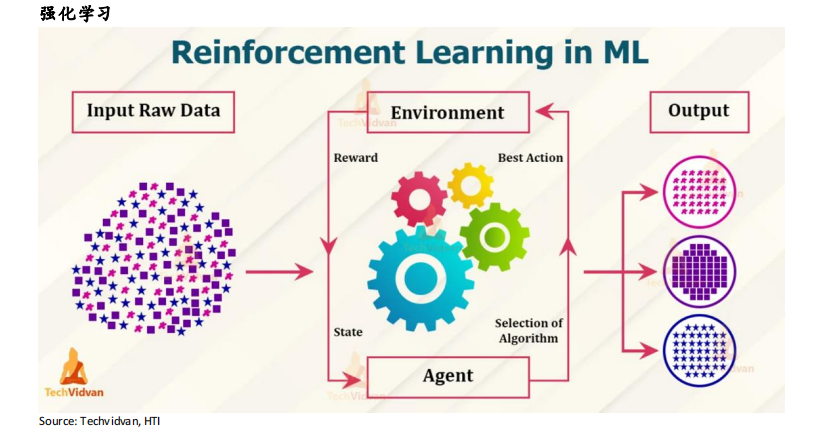

(7)强化学习(Reinforcement Learning,RL)是一种机器学习方法,用于训练模型做出决策,以实现最佳结果。通过反复试错和奖惩制度,与环境交互来学习最优策略,有助于实现目标的软件操作会得到加强,而偏离目标的操作将被忽略,从而在不同状态下选择最佳处理路径以获得最大化预期回报。强化学习广泛应用于机器人控制、游戏AI、推荐系统等领域。例如,著名的AlphaGo在训练过程中结合了强化学习策略,以寻找最佳落子策略。

(8)强化学习与人类反馈(Reinforcement Learning with Human Feedback, RLHF)结合强化学习的自动学习能力和人类的反馈,通过人类反馈指导学习的过程,显著加速学习速度,提高性能及安全性。强化学习与AI反馈(Reinforcement Learning with AI Feedback,RLAIF)是结合了强化学习的自动学习能力和AI模型的智能反馈。其智能体不仅从环境中获得奖励,还从另一个AI系统中获得反馈。这种方法利用AI反馈来指导和改进智能体的学习过程,从而加速策略优化,提高整体性能。

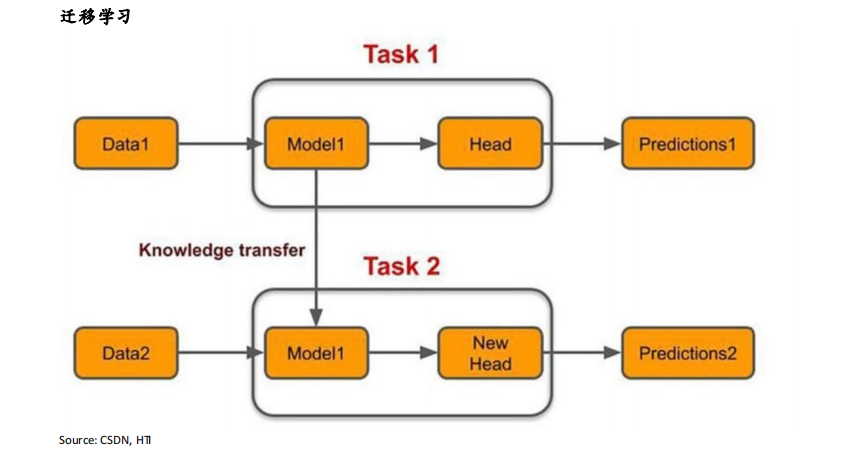

(9)迁移学习(Transfer Learning)是一种机器学习方法,其中一个模型在某个任务上学到的知识被应用到另一个相关的任务中。通过这种方法,迁移学习能够利用已有的经验,提高新任务的学习效率和性能。尤其是在数据有限的情况下,迁移学习能够显著提升模型性能。

(10)联邦学习(Federated Learning)是一种分布式机器学习方法,允许模型在多个设备或节点上训练。这种方式能够在保护数据隐私的前提下,利用分散的数据进行模型训练,可以在全局模型的基础上,进一步调整和优化个性化模型,满足不同用户的需求。

(11)生成对抗网络(Generative Adversarial Networks, GAN):GAN包括两个部分:生成器和判别器。生成器尝试生成与真实数据相似的假数据,而判别器尝试区分真假数据。通过不断的对抗训练,生成器最终能够生成较为逼真的数据。

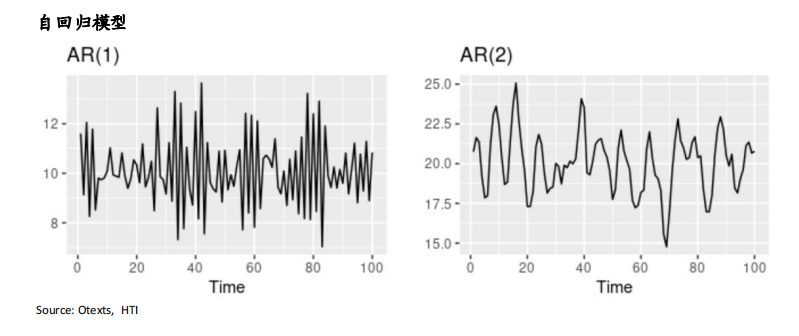

(12)自回归模型(Autoregressive Model):通过前一个时刻的输出来预测下一个时刻的输出,广泛应用于文本生成和音频生成等领域。

(13)变分自编码器(VAEs):由编码器和解码器组成。编码器将图片信息压缩成一个“潜在空间”。这就像画家将复杂的画面概括成简单的草图,这个草图包含了图片的关键要素,但省略了细节。解码器根据这些草图画出新图片。就像画家根据草图创作出一幅新画。这些新画看起来像是从原始图片中生成的,但又是独一无二的。在训练过程中,VAE会不断调整编码器和解码器,让生成的图片越来越逼真。

(14)优化算法(Algorithms Optimization):用于训练模型,调整模型参数以最小化损失函数,提高模型性能。常见的优化算法包括随机梯度下降(Stochastic Gradient Descent, SGD)和其变种,以及自适应学习率算法如Adam等。例如,随机梯度下降是指不使用全量样本计算当前的梯度,而是使用小批量(mini-batch)样本来估计梯度,大大提高了效率。

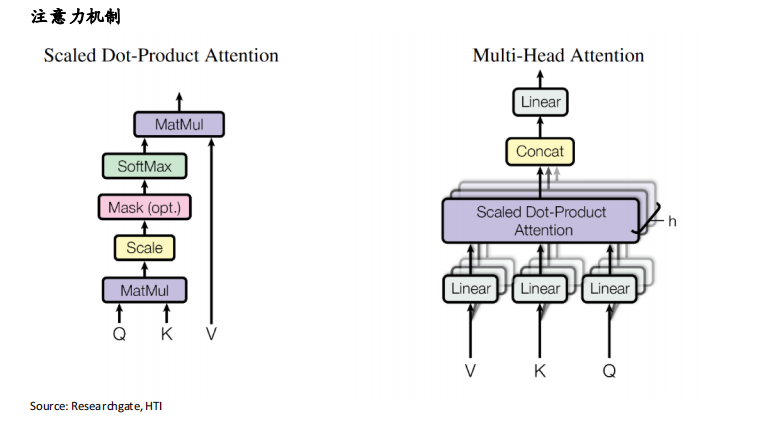

(15)注意力机制(Attention):使模型聚焦于输入中的关键部分,提高处理效率和效果。注意力机制在生成式AI 中被广泛应用,例如用于自然语言处理任务中的注意力机制模型(如Transformer)能够有效处理长距离依赖关系和提升生成性能。

以上的这些技术在过去的20年中快速发展,直到2017年的历史性的突破Transformer的到来,才有了生成式AI的基础。而在2022年ChatGPT的横空出世,进一步将生成式AI模型从需要大量标注数据而进行训练的时代带入到不需要标注数据而进行海量数据训练的时代。

本文转自:海通国际,转载此文目的在于传递更多信息,版权归原作者所有。如不支持转载,请联系小编demi@eetrend.com删除。