作者:邵乐峰

来源:电子工程专辑

"后摩尔时代,CPU已经无法满足指数级增长的算力需求,异构加速计算为满足世界对算力的日益增长提供了可行的解决方案。CPU、GPU、FPGA、ASIC、专用AI加速器的异构融合为提高算力开辟了新的方向,能够有效地解决日渐增长的算力需求。"

数据在过去30年间发生了三次重要的转变:起初数据以纯PC计算形式为主,2000年之后的10年则是PC计算、服务器、Web2.0时代共同产生,2010年之后数据又辐射到了手机、汽车、云计算、IoT、区块链、智能生活、自动驾驶等多个领域。

海量数据处理推动算力增长

根据IDC的报告,全球数据量正以25%增速呈指数级增长。Imagination Technologies公司副总裁兼中国区总经理刘国军在由AspenCore主办的2022国际集成电路展览会暨研讨会(IIC)上指出,过去20多年是互联网高速发展的时代,在给信息社会和人类生活带来巨大改变的同时,也带来了空前的挑战。

“互联网让地球上的几十亿人互联互通,随之而来的智能物联网又连通了数万亿的设备,每时每刻都在产生海量的数据。”他用下图展示了这种趋势,例如每人每天会产生1.5G的数据;自动驾驶汽车一天会产生5TB的数据;一座智慧城市每天产生的数据则高达250PB……等等。然而,未经处理的数据毫无价值,只有将数据转化为业务价值,才能创造新的服务和体验,才能给人类社会带来福祉。

同时,这又是一个人工智能(AI)赋能的时代,世界充满了对算力的渴求。从互联网到物联网,从指纹解锁到高性能计算,无一不是算力的体现。其实,人工智能并不是新概念,早在1955年到1956年间,AI就得到了定义,但它被应用于实际应用领域却是最近二十年的事情。

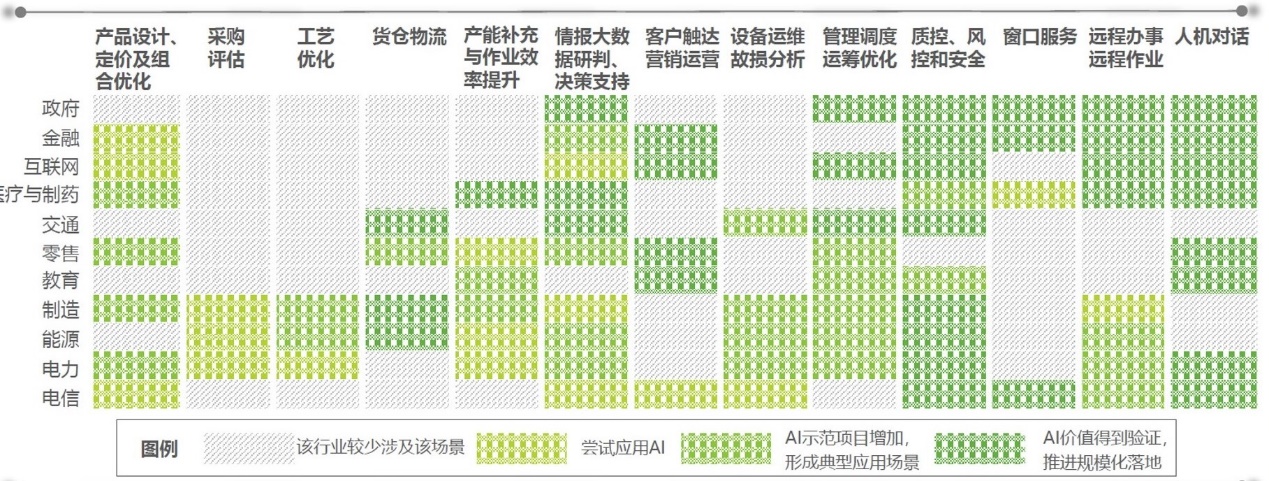

具体到中国,在刘国军看来,中国企业的数字化转型整体仍处于早期阶段, 目前中国大型企业基本都已在持续规划投入实施人工智能项目,而规模以上企业中约有超过10%的企业已将人工智能与其主营业务结合,实现产业地位提高或经营效益优化。

从上图中可以看到,纵轴代表包括政府、金融、互联网、交通在内的各行各业,横轴代表人工智能运用方法。不难发现,AI实际上已经渗透到了社会的方方面面,给人类的生活方式和生活质量带来了根本改变,与此同时,人和人、AI与AI、人与AI之间的关系,也在不断变化中。

目前来看,计算机视觉、语音识别、自然语言处理、知识图谱、机器学习是AI在企业中的主要应用场景。“最近在科学研究当中发生的一件大事,就是AI做出的新的蛋白质结构预测,与实际产生的几乎一模一样,这是非常大的突破。”刘国军说。

异构加速计算时代

众所周知,AI技术根据应用不同被分为“训练(Training)”和“推理(Inference)”两大类,前者主要在云端由CPU、TPU负责执行,目的是不断增加数据库资源以建立数据模型;后者则比较适合应用于边缘装置和特定应用,常由ASIC、GPU、FPGA类芯片进行处理,依托已经训练好的数据模型进行推理。

IDC的统计数据显示,2020年到2021年间,全球AI服务的年复合增长率达到了17.4%,预计到2024年,这一数字将上升至18.4%,市值约为378亿美元。这其中包括了定制化的应用和针对定制化平台所提供的相关支持与服务,例如一些深度学习架构、卷积神经网络、与AI相关的芯片产品(CPU、GPU、FPGA、TPU、ASIC)等。

同样是来自IDC的数据,全球数据储存量将从2018年的33ZB猛增到2025年的175ZB,这其中超过50%都来自IoT设备。如果考虑到2025年,全球将会部署约140亿部IoT设备,那么我们是不是大量地增加云端的计算单元数量与算力,才能应对海量的数据增长。

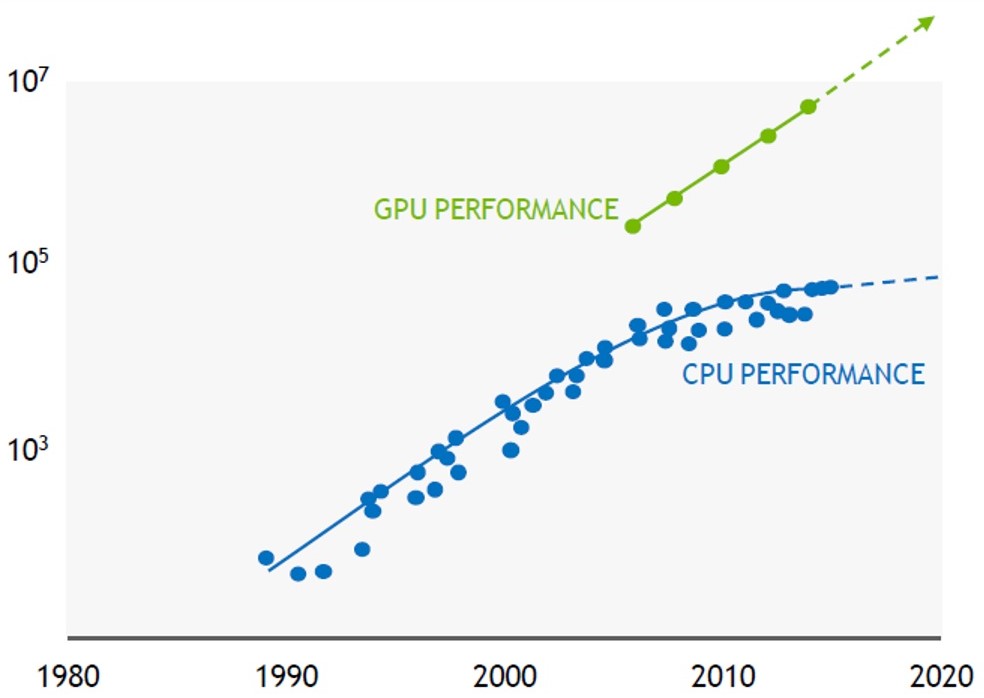

答案是否定的。刘国军指出,后摩尔时代,CPU已经无法满足指数级增长的算力需求,异构加速计算为满足世界对算力的日益增长提供了可行的解决方案。CPU、GPU、FPGA、ASIC、专用AI加速器的异构融合为提高算力开辟了新的方向,能够有效地解决日渐增长的算力需求,将在游戏、运输、医疗、云计算、机器人、物联网、专业视觉、人工智能、高性能计算等多个领域发挥重要作用。

作为GPU技术的拥有者,Imagination公司的GPU产品目前在游戏、计算机视觉、医疗图像和大算力计算方面得到了广泛应用,这与Gartner 2020年Priority Matrix for AI显示的趋势保持了一致。数据显示,GPU加速器是最接近步入主流的技术,未来2-5年内,GPU加速器的采用率将提高100%,即从2021年的5%-20%增加到2022年的20%-50%,未来,GPU加速计算可以在HPC、DNN训练和推理中为高度并行的计算密集型工作负载提供出色的性能。

之所以会产生这样的趋势,刘国军认为,这得益于AI在企业组织中的普及和广泛采用。换句话说,AI的普及程度越高,开发人员创建企业级应用的重要性就越高。AI平台的产业化、AI的可重用性、可伸缩性、安全性和负责任的使用、以及AI治理都是这个趋势的催化剂。

几把利器

架构弹性扩展一直以来都是Imagination GPU的特色:即模块化、层级化的方式,通过一种架构的弹性化扩展,将任务分配至CPU、GPU和NNA加速器,覆盖从手机到服务器市场的各类需求。这种设计也在其它很多层面带来了好处,比如说硬件虚拟化、汽车功能安全的冗余设计,以及各chiplet之间的异步操作等等。

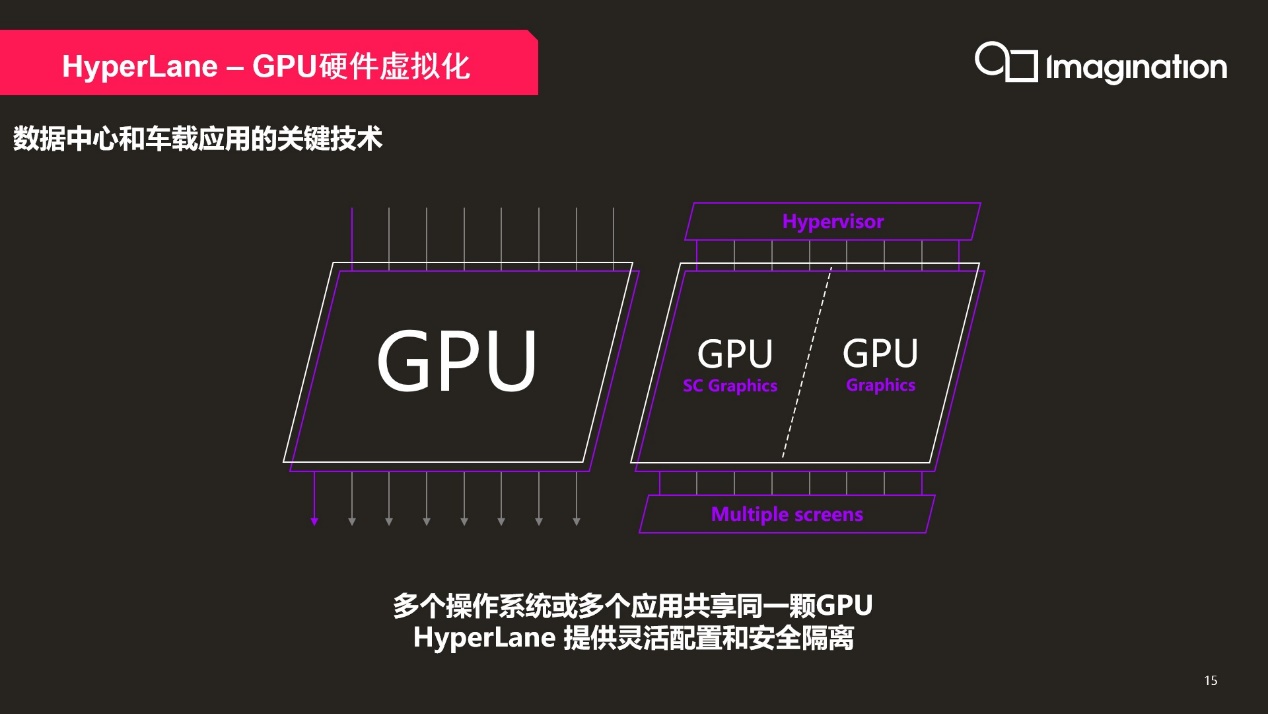

HyperLane–GPU硬件虚拟化技术在数据中心和车载应用中有着举足轻重的作用。通过硬件虚拟化技术,我们可以同时运行多个操作系统,运行多个应用在同一颗GPU上。同时每个应用和操作系统在硬件层面上实现了物理隔离,确保每个实例的数据安全。

举例而言,当GPU应用于汽车之时——当代座舱内就有好几块屏幕,用途各异——它们在系统内可能会由同一个GPU来驱动。那么虚拟化在此就能发挥作用,包括从操作系统层级来做性能负载的分配。

还有负载的安全和隔离——比如仪表盘、导航、娱乐系统都跑在一个GPU上,则在某个系统崩溃时不会影响到仪表盘,即功能安全相关负载——GPU在此就是将使用场景,在硬件级上实现切分。另外在其他一些使用场景上,比如手机之上,对应的特性就能对神经网络加速,和UI特性做到资源均衡分配。当然还有在云服务器上,硬件虚拟化多租户也是十分必要的特性。

Imagination对于光线追踪技术的投入,在移动领域应该算是移动GPU IP产品中最早的。光线追踪是一种渲染技术,一直被认为是3D图形处理领域的乌托邦。它可以精确地追踪场景中光线的路径,相比传统的光栅化技术,它可以渲染出可信且具有更高真实感和保真度的反射、折射和光照效果。Imagination方面认为光线追踪要到Level 4才能实现最好的用户体验、更高算力、更低带宽,可实现桌面级高效性能的提升。

基于这样的认知,2020年9月,Imagination开发了一套光线追踪等级系统(Ray Tracing Levels System),旨在帮助开发人员和原始设备制造商对光线追踪加速的先进功能进行等级鉴别,获得更高的真实世界光线追踪性能和更佳的效率,实现更复杂的效果和更高的分辨率,进而找到合适的技术来满足自身需求。

而最新的PowerVR Photon光线追踪架构,则是“业界首款RTLS 4级光线追踪架构”,“全球第一个做到L4的硬件处理,而且是在移动端——当然也可以在PC和数据中心实现”。与此同时,“功耗比现有的RTLS 2/3级解决方案高2.5倍”。

此外,2017年发布的神经网络加速器NNA也非常值得一提。它专为要求ISO 26262的汽车应用而设计,具备可扩展的高性能100 TOPS多核集群,可用最小的外部带宽获得最高的性能。凭借出色的架构和软件生态,以及设计工具的简洁性,在推出短短两年内就在中国获得了10家客户的青睐。