人工智能改善零售体验的20个实例

demi 在 周四, 03/07/2019 - 10:53 提交

多年来,零售体验并没有发生太大变化:走进商店,寻找合适的产品,然后购买。但人工智能的出现正在改变一切,通过个性化、自动化和效率提高将零售体验提升到新的水平。下面让我们来看看20个人工智能改善零售体验的实例。

多年来,零售体验并没有发生太大变化:走进商店,寻找合适的产品,然后购买。但人工智能的出现正在改变一切,通过个性化、自动化和效率提高将零售体验提升到新的水平。下面让我们来看看20个人工智能改善零售体验的实例。

Gartner公布了七大新兴的安全和风险管理趋势,这些趋势将在长期内影响安全、隐私和风险领导者:风险偏好声明与业务成果挂钩;安全运营中心正在实施,重点是威胁检测和响应;数据安全治理框架应该优先考虑数据安全投资;无密码认证正在引领市场;安全产品厂商正在越来越多地提供高级技能和培训服务;投资云安全,将其作为主流计算平台的能力;在传统安全市场中增加Gartner CARTA。

机器学习中涉及到了很多的概念,当然要想了解机器学习的话就需要对这些基础知识有一个深入的了解才能够入门机器学习,那么机器学习的基础知识都有哪些呢?本文给大家列举一下机器学习的基础知识。

噪声在图像上常表现为一引起较强视觉效果的孤立像素点或像素块。一般,噪声信号与要研究的对象不相关,它以无用的信息形式出现,扰乱图像的可观测信息。通俗的说就是噪声让图像不清楚。噪声来源两个方面:图像获取过程中;图像信号传输过程中。

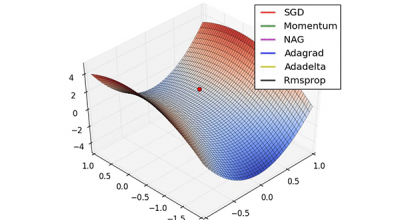

梯度下降法,是当今最流行的优化(optimization)算法,亦是至今最常用的优化神经网络的方法。本文旨在让你对不同的优化梯度下降法的算法有一个直观认识,以帮助你使用这些算法。我们首先会考察梯度下降法的各种变体,然后会简要地总结在训练(神经网络或是机器学习算法)的过程中可能遇到的挑战。

CNN的结构,包括输出层,若干的卷积层+ReLU激活函数,若干的池化层,DNN全连接层,以及最后的用Softmax激活函数的输出层。在CNN的模型基础上,看看CNN的前向传播算法是什么样子的。重点会和传统的DNN比较讨论。

随着竞争的加剧,2019年业界将出现最大的云提供商。云将低成本基础设施与高价值开发服务的结合,将成为新的企业数字应用平台。同时也将使企业在云上的支出比几年前预测的更快。

本文将介绍自动驾驶汽车决策系统的相关技术,包含路线规划、行为选取、运动规划和控制子系统。路线规划子系统负责计算出一条穿过道路网的路线,让自动驾驶汽车能从起始位置到达用户定义的终点位置。如果将道路网表示为一个加权的有向图,其边权重表示遍历一个道路片段的成本,则计算路线的问题就可约简为在一个加权有向图中寻找最短路径的问题。

如今,AI炒得很热,但AI到底发展到了哪一步,很难看清。好在近日,一群AI政策研究人员发布了一份报告,披露了大量数据,有助于我们认清这股热潮的发展状态。报告集结了来自麻省理工大学、斯坦福大学、哈佛大学以及OpenAI等非营利组织的研究人员,考察了AI领域的投资、招聘以及论文与专利情况,甚至连政府会议期间提及AI的频率,也考察在内。

过去几十年中,人工智能的出现导致了人类的集体焦虑。然而,必须注意的是,并非所有的工作最终都会被人工智能取代。那么,人类保持领先并更好地就业的秘诀是什么呢?答案在于需要知道人工智能在哪些方面比人类做得更好,人类在哪些方面比人工智能做得更好。