Android MVP 十分钟入门!

demi 在 周二, 11/27/2018 - 10:44 提交

前言

在日常开发APP 的过程中,随着业务的扩展,规模的变化。我们的代码规模也会逐渐变得庞大,每一个类里的代码也会逐渐增多。尤其是Activity和Fragment ,由于Context 的存在,基本上所有对视图的操作我们只能在Activity和Fragment中完成;即便是对某些逻辑进行封装,Activity和Fragment 依旧会显得过于臃肿。因此,我们需要换一种思路去写代码,这个时候MVP模式就应用而生了!那么MVP 怎么用呢,下面就来说一说。

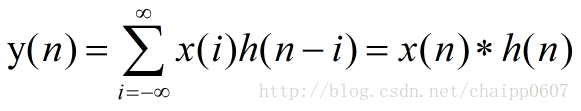

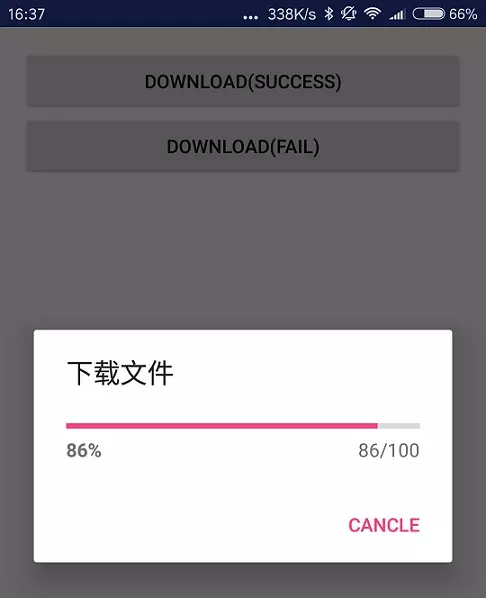

假设你现在如要实现下图中的功能:

这个需求很简单,就是点击按钮,下载一张图片,显示下载进度;下载完成后,在ImageView中显示这张图片。

下面我们就分别用传统的方式(也就是所谓的MVC)和MVP 模式分别取实现这个功能。然后分析一下MVP 到底好在哪里。