随着人工智能技术在大模型训练、边缘计算、自动驾驶等领域的深度渗透,核心算力硬件的竞争进入白热化阶段。图形处理单元(GPU)与专用集成电路(ASIC)作为两大主流技术路线,正围绕性能、成本、灵活性等核心维度展开激烈角逐,各自凭借独特优势占据细分市场,同时也面临着技术迭代与市场需求变革带来的挑战。

GPU凭借其与生俱来的并行计算基因,成为当前AI训练与复杂推理任务的中坚力量。最初为图形渲染设计的GPU,通过集成数百乃至数千个计算核心,能够高效处理深度学习中大量重复的矩阵乘法、卷积运算等并行任务。以英伟达的DGX系列硬件平台为例,其搭载的多颗GPU通过CUDA编程框架的优化,能够为Transformer架构大模型、计算机视觉中的多尺度图像特征提取等提供强大算力支撑,让科研机构和企业在短时间内完成海量数据的模型训练。这种强大的通用性是GPU的核心竞争力,它无需针对特定算法进行定制,能够适配自然语言处理、图像识别、语音合成等多种AI应用场景,支持TensorFlow、PyTorch等主流深度学习框架,开发者无需重构代码即可快速部署不同类型的模型。

成熟的软件生态进一步巩固了GPU的市场地位,英伟达的CUDA工具包提供了丰富的开发接口和优化资源,降低了并行编程的门槛,吸引了全球数百万开发者参与生态建设,形成了“硬件性能领先—生态持续完善—用户粘性增强”的良性循环。

然而,GPU的短板也在大规模应用中逐渐显现。为维持强大的并行计算能力,GPU需要搭载复杂的电路设计和大容量显存,导致其硬件成本居高不下。英伟达最新的DGX B200 8GPU平台功耗高达14.3kW,单台设备采购成本动辄数百万元,对于中小企业和预算有限的研究机构而言,无疑构成了巨大的资金压力。高功耗带来的不仅是能源成本的增加,更对数据中心的散热系统提出了严苛要求,限制了其在边缘计算、移动终端等对功耗敏感的场景中的应用。此外,GPU的通用架构使其在处理特定算法时存在算力冗余,部分计算单元无法充分发挥作用,导致能效比低于专门定制的芯片,这在大规模推理等场景中尤为明显。

与GPU的通用性形成鲜明对比,ASIC以“定制化”为核心卖点,在特定AI场景中展现出极致的性能与能效优势。ASIC通过针对具体算法和任务优化电路设计,去除了不必要的通用计算模块,能够将算力集中投入到核心运算中,实现性能与功耗的精准匹配。

谷歌研发的TPU(张量处理单元)作为典型的AI ASIC芯片,通过高密度乘法器和累加器阵列(MAC)优化矩阵运算,在深度学习推理任务中,相比通用GPU性能提升显著,同时功耗大幅降低。亚马逊推出的Trainium芯片在推理场景中,相比英伟达H100 GPU的成本降低30%至40%,随着量产规模扩大,单位成本优势进一步凸显,成为大型数据中心大规模部署AI推理任务的优选。华为昇腾则是华为为AI时代量身打造的“神经网络处理器”(NPU),在大模型训练、深度学习推理等核心场景中,展现出极强的“专精性”。据海外专业机构SemiAnalysis的数据证实:昇腾384超节点的整体计算能力是英伟达GB200机柜的1.6倍。

这种高能效比让ASIC在边缘计算设备、智能终端等功耗受限场景中具备不可替代的优势,例如自动驾驶汽车的传感器数据实时处理、智能家居设备的语音唤醒功能,都需要ASIC在低功耗前提下提供稳定的算力支持。

但ASIC的定制化特性也带来了天然的局限性。芯片设计周期长、研发投入大,一旦完成流片生产,其支持的算法和任务类型便基本固定,难以适应AI技术快速迭代的节奏。当新的深度学习算法出现时,旧款ASIC可能面临被淘汰的风险,这对于技术路线尚未完全稳定的新兴应用场景而言,无疑增加了市场风险。

此外,ASIC的软件生态尚不完善,开发工具和适配资源相对匮乏,开发者需要针对特定芯片进行专门的代码优化和模型迁移,不仅提高了开发成本,也延长了产品落地周期。这种“专用性”与“灵活性”的矛盾,使得ASIC难以像GPU那样覆盖广泛的应用场景,更多局限于算法成熟、需求稳定的大规模部署场景。

当前,AI芯片市场的竞争并非非此即彼的零和博弈,而是呈现出“差异化竞争+生态互补”的格局。GPU凭借通用性和完善生态,继续主导大模型训练、科研创新等需要灵活适配多算法的场景,尤其是在生成式AI爆发的背景下,对高性能GPU的需求持续旺盛。博通虽为谷歌、AWS定制ASIC芯片,其CEO Hock Ta坦言:“通用GPU仍是复杂AI工作流的基石。”

而ASIC则在数据中心大规模推理、边缘计算、智能终端等场景加速渗透,随着AI应用从实验室走向产业化,算法逐渐固化,ASIC的成本和能效优势将进一步放大。谷歌、亚马逊、华为等科技巨头纷纷加大ASIC研发投入,同时英伟达等GPU龙头也在通过芯片架构优化、专用计算单元集成等方式提升能效比,双方技术路线呈现相互借鉴的趋势。

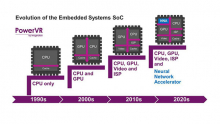

展望未来,AI芯片市场将朝着“异构融合”的方向发展,GPU与ASIC并非相互替代,而是通过合理搭配实现算力效率的最大化。在数据中心,“CPU+GPU+ASIC”的异构计算架构将成为主流,GPU负责灵活的训练任务和复杂推理,ASIC承担规模化的标准推理任务,CPU则统筹调度,充分发挥各类芯片的比较优势。

技术创新将成为打破当前格局的关键变量,3D堆叠技术、新型半导体材料的应用将进一步提升芯片的算力密度和能效比,而机器学习辅助芯片设计的方式,有望缩短ASIC的研发周期、降低定制成本。软件生态的互联互通也将成为竞争焦点,无论是GPU厂商还是ASIC开发者,都需要通过兼容主流框架、提供便捷迁移工具等方式降低用户使用门槛。

对于企业而言,选择GPU还是ASIC路线,本质上是对应用场景、成本预算和技术迭代速度的综合考量。科研机构和创新型企业更倾向于选择GPU以快速响应算法变化,而大规模部署的成熟应用则更适合采用ASIC降低长期成本。随着人工智能产业的持续升温,GPU与ASIC的竞争将推动整个AI芯片行业不断突破性能、功耗和成本的边界,为人工智能技术的规模化应用注入源源不断的算力动力,而这场博弈的最终受益者,将是整个AI产业生态与终端用户。

本文转自:TechSugar,转载此文目的在于传递更多信息,版权归原作者所有。如不支持转载,请联系小编demi@eetrend.com删除。