本文来源:图灵编辑部

2025 年,人工智能已经不再只是前沿科技圈的热词,而是真真正正地走进了我们的日常:生成图像、写代码、自动驾驶、医疗诊断……几乎每个行业都在讨论 AI,拥抱 AI。

但今天的大模型奇点不是一夜之间到来的,它背后是一条充满突破、争议、冷寂与复兴交织的进化之路。从 1956 年达特茅斯会议开始,到如今数千亿参数模型引发的全球技术竞赛,AI 的发展史是一部关于人类如何模拟、拓展,乃至重新定义智能的故事。

本文将带你一起回顾这条历程中的 10 个关键的历史性时刻,帮你理清人工智能是如何一步步从纸上设想,走向今天这场技术浪潮核心的。

1、达特茅斯会议(1956年)

1956 年的达特茅斯会议被广泛认为是人工智能(AI)诞生的标志性时刻。会议由四位人工智能领域的先驱人物约翰·麦卡锡、马文·明斯基、内森·罗切斯特和克劳德·香农发起,汇聚了一群志同道合的研究者,他们共同的目标是探索机器智能这一未知领域。

在为期六周的会议中,与会者进行了深入的讨论、辩论与合作,奠定了人工智能作为一个正式学科的基础。他们尝试定义人工智能的概念、明确其研究目标,并规划可能的研究方向。会议成员探讨了一系列深刻问题,包括问题求解、机器学习和符号推理等。

这次关键性的会议不仅开启了之后数十年人工智能研究与创新的大门,也凝聚了一个充满信念的学术群体——他们相信机器有能力复制人类的认知能力。达特茅斯会议的深远影响在于,它确立了人工智能作为一门学科和实践领域的地位,推动人类迈向一个智能机器与人类协作的未来。

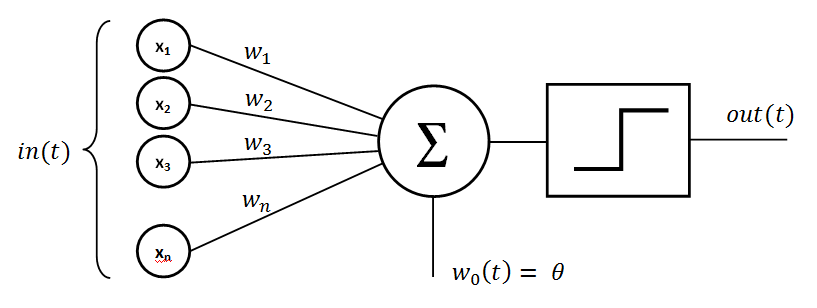

2、感知机(1957年)

1957 年,弗兰克·罗森布拉特(Frank Rosenblatt)开发了感知机(Perceptron),这是最早的人工神经网络之一。感知机是模仿生物神经元的简化模型,用于进行二值分类决策。

尽管模型结构简单,感知机却首次提出了“用训练数据优化模型”的思想。这种“训练-预测”范式后来成为机器学习和深度学习的核心方法。感知机为我们今天所熟知的神经网络和深度学习技术奠定了基石。

尽管感知机存在一些局限(如不能处理非线性可分问题),它却促成了后续更复杂模型的研究。感知机的影响延续至今,被广泛应用于图像识别、语音处理、自然语言理解等前沿领域。

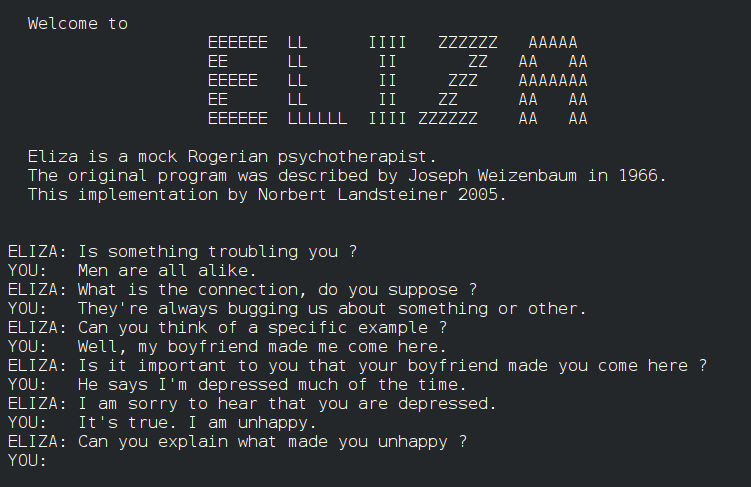

3、ELIZA(1966年)

由 MIT 计算机科学家约瑟夫·维森鲍姆(Joseph Weizenbaum)于 1966 年开发的 ELIZA,是第一个被广泛认可的聊天机器人,能够模拟人与人之间的对话。它以心理治疗为模拟场景,将用户的回答转化为追问,从而延续对话——也被称为“罗杰式对话法”。

维森鲍姆本想用 ELIZA 证明机器智能的“拙劣”,结果却适得其反——许多用户认为他们在与真正的心理医生交谈。他在论文中写道:“有些被试很难相信 ELIZA 不是人类。”

尽管以今天的标准来看功能十分基础,ELIZA 却展示了人工智能在自然语言处理方面的潜力。通过与用户进行对话,它证明了计算机可以生成类似人类的回应,激发了人们对对话式 AI 领域的浓厚兴趣。

4、专家系统(20世纪70年代)

20 世纪 70 年代,AI 研究主要集中在符号主义,以逻辑推理为中心,专家系统的兴起(如 Dendral 和 MYCIN)标志着人工智能首次在实际领域中展现出类人智能。

Dendral 是一个面向化学领域的专家系统,能分析质谱数据,推断有机化合物的分子结构,展现了 AI 在专业领域内模拟专家推理的能力。而 MYCIN 则聚焦于医疗诊断,能够识别细菌感染并推荐抗生素治疗方案。

这些系统证明,AI 不仅能处理通用逻辑问题,也能转化为特定领域的“知识专家”。专家系统的出现,奠定了 AI 在医疗、法律、金融、工程等专业领域广泛应用的基础。

5、深蓝赢得象棋比赛(1997年)

深蓝(Deep Blue),一台 IBM 超级计算机,与世界象棋冠军加里·卡斯帕罗夫之间的历史性象棋对局,吸引了全世界的关注。深蓝的胜利标志着人工智能的一个重要里程碑,证明了机器能够在需要战略思维、评估和决策的复杂游戏中超越人类。

6、机器学习(1990-2000年代)

计算机科学家汤姆·米切尔(Tom Mitchell)将机器学习定义为“一个有关计算机算法的研究,旨在允许程序通过经验积累自动提高其性能”。这一定义标志着人工智能研究方向的转变,强调了数据驱动算法的重要性,并推动了能够随着时间不断适应和提升性能的人工智能系统的发展。

7、深度学习兴起(2012年)

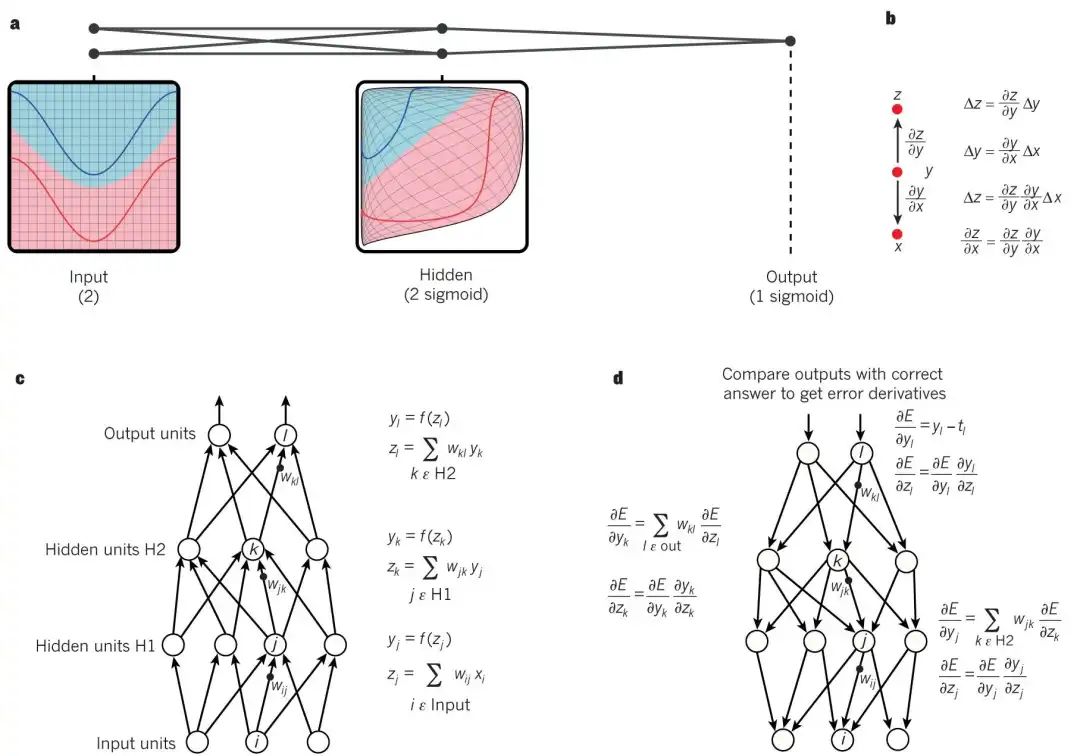

Deep Learning 是一种机器学习算法,核心在于通过多层神经网络结构,以及“反向传播”(Backpropagation)技术来进行模型训练。这一领域由 Geoffrey Hinton 奠定基础。

早在 1986 年,Hinton 与合作者发表了关于深度神经网络(DNN,Deep Neural Networks)的开创性论文,首次系统引入了反向传播算法。这种算法能够在训练过程中动态调整网络中的权重,使神经网络更有效地逼近正确输出,从而实现了对多层网络的高效训练,打破了 Minsky 在 1966 年提出的感知器局限,成为神经网络发展的关键转折点。

AlexNet 在 ImageNet 竞赛中取得了震撼业界的成绩,成为深度学习浪潮的引爆点。

8、生成对抗网络(2014年)

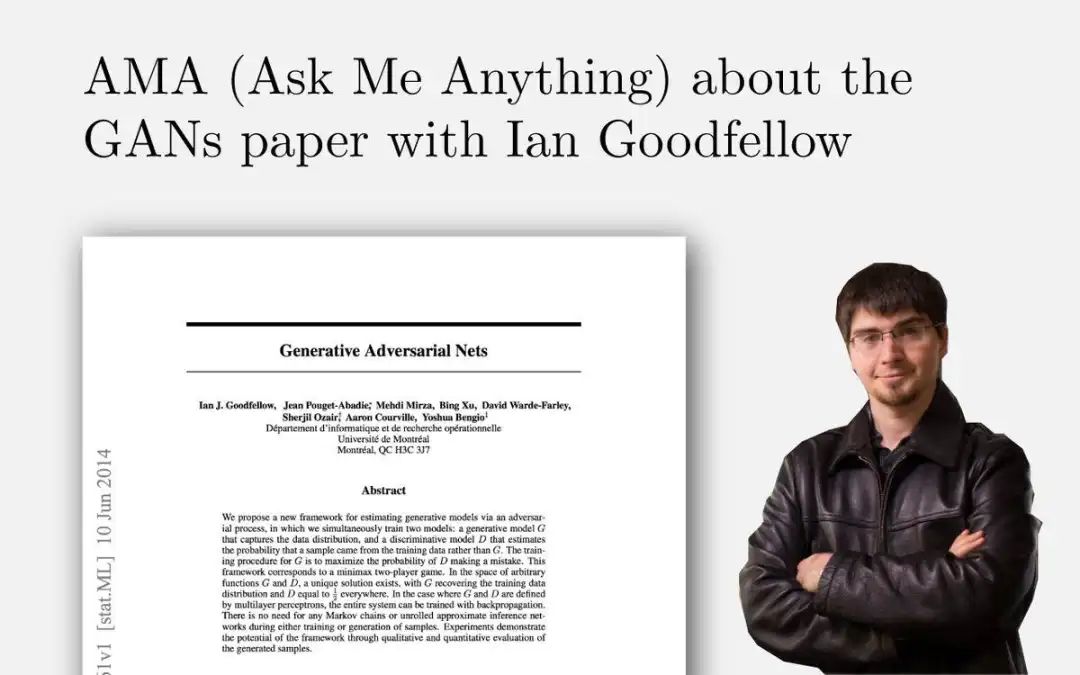

伊恩·古德费洛(Ian Goodfellow)提出了生成对抗网络(GANs)的概念,彻底改变了生成模型领域。GANs 由两个神经网络——生成器和判别器——相互竞争组成。这一框架使得创建逼真的合成数据成为可能,如图像和文本,并对图像合成、视频生成和数据增强等多个应用领域产生了深远的影响。

9、AlphaGo(2016年)

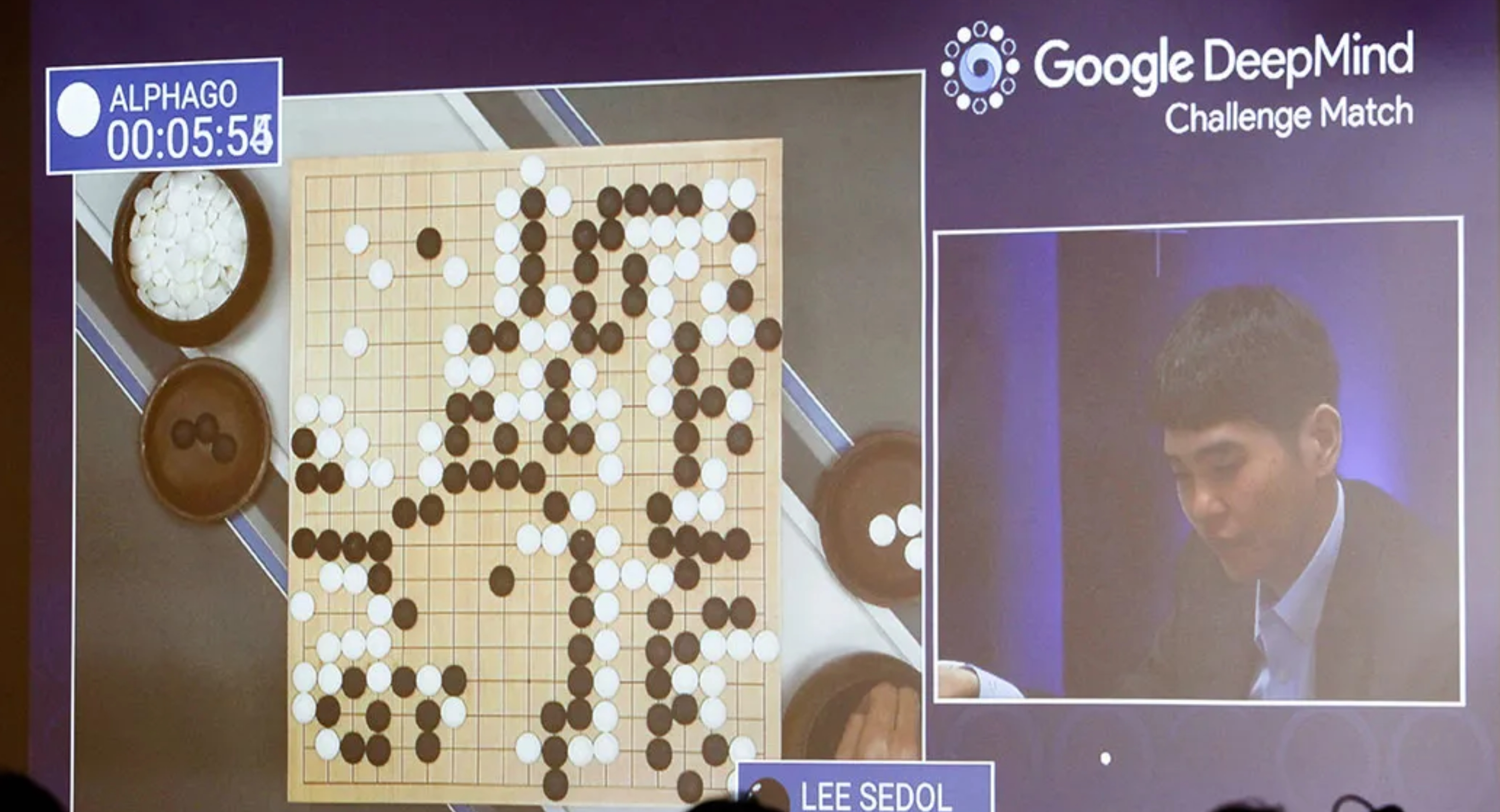

由 DeepMind 开发的 AlphaGo,通过击败世界围棋冠军李世石,达成了一个非凡的壮举。这一里程碑标志着人工智能在一个拥有大量可能棋步、需要直觉和战略思维的复杂游戏中取得了胜利。AlphaGo 的成功突显了人工智能在解决曾被认为是人类独有的挑战中的潜力。

10、Transformer与大模型(2017-2025)

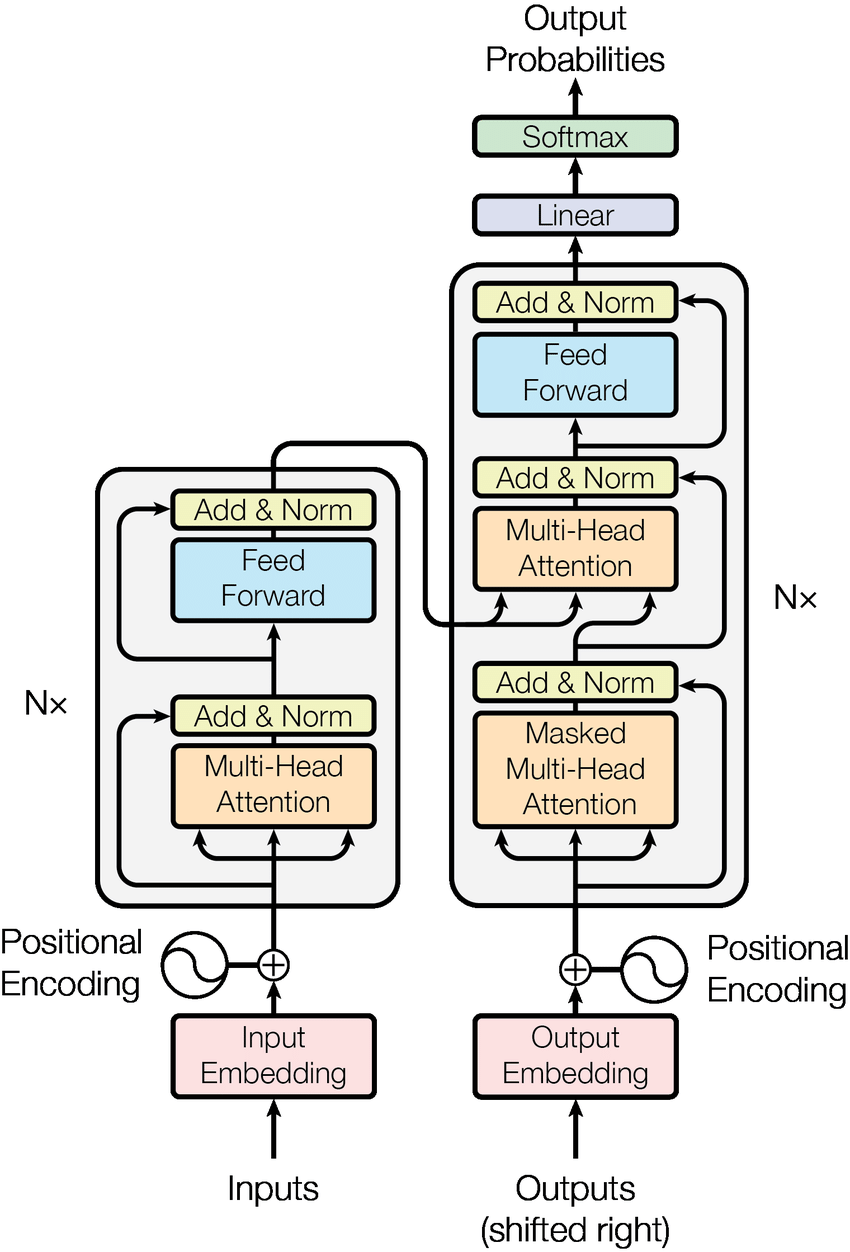

大语言模型的发展始于 2017 年 Transformer 架构的提出,其自注意力机制有效解决了长距离依赖问题,为理解和生成长文本奠定了基础。2018 年,GPT-1 与 BERT 分别基于自回归和遮蔽语言模型的预训练方式,确立了“预训练+微调”范式,使模型能从海量无标注语料中学习通用语言能力。2020 年,GPT-3 凭借 1750 亿参数初步展现出“涌现能力”,包括零样本学习、逻辑推理与代码生成,标志着模型规模带来的质变。

2023 年,GPT-4 进一步融合文本与图像的多模态能力,并通过人类反馈强化学习(RLHF)显著提升了模型的安全性与实用性。同时,Anthropic 推出了 Claude,Google 则发布 Gemini 系列,Meta 也发布了开源模型 LLaMA。

国内大模型生态也在迅速演进。百度的文心一言、阿里的通义千问、字节的豆包等等,而 DeepSeek 则以一己之力掀起大众 AI 热潮,凭借其开放参数和高性价比模型引发广泛关注。

从 1956 年达特茅斯会议上的一纸设想到 2025 年大模型走入千行百业,人工智能的发展从未是一帆风顺的直线,而是一条曲折、迂回却令人惊叹的演化之路。这 10 个关键时刻,是人类在探索智能本质、突破技术边界时一次次重要的集体跃迁。回望过去,不只是为了致敬里程碑,更是为了理解今日种种现象的来龙去脉。而下一次“奇点”,也许正在悄然靠近。

本文转自:图灵编辑部,转载此文目的在于传递更多信息,版权归原作者所有。如不支持转载,请联系小编demi@eetrend.com删除。