Sam Altman 深夜发布一条推文:her。大半夜看到这里觉得一定不简单,果真又放大招了!

OpenAI 刚刚发布了一款名为 GPT-4o 的“旗舰级”生成式人工智能模型。它不仅有超强的文本、图像、视频和语音处理能力,关键还免费。

当你打开 ChatGPT,如今它已经变成了一个无所不能的语音助手,这一切越来越接近 2013 年的那部电影《Her》。没想到 2050 年才会发生的事情,2024 年 OpenAI 就让我们大开眼界。

我们来简单回顾一下发布会内容:

0. ChatGPT 桌面版及用户界面优化:ChatGPT 桌面版发布。新的用户界面旨在提供更自然、轻松的交互体验,减少用户对界面的关注,更专注于与模型的协作。

1. 新的 GPT-4o 模型:GPT-4o 中的"o"代表“omni”,意味着模型的全能性,源自拉丁语“omnis”,表示“全部”或“所有”的概念。GPT-4o 能够实时对音频、视觉和文本进行推理,处理超过 50 种不同的语言。

2. 免费开放与 API 的经济优势:GPT-4o 将向免费用户开放,但会限制数量,超过限制后将自动降级到 GPT-3.5。GPT-4o 将开放相应 API 给开发者,价格是 GPT-4-turbo 的一半,速度是其两倍。

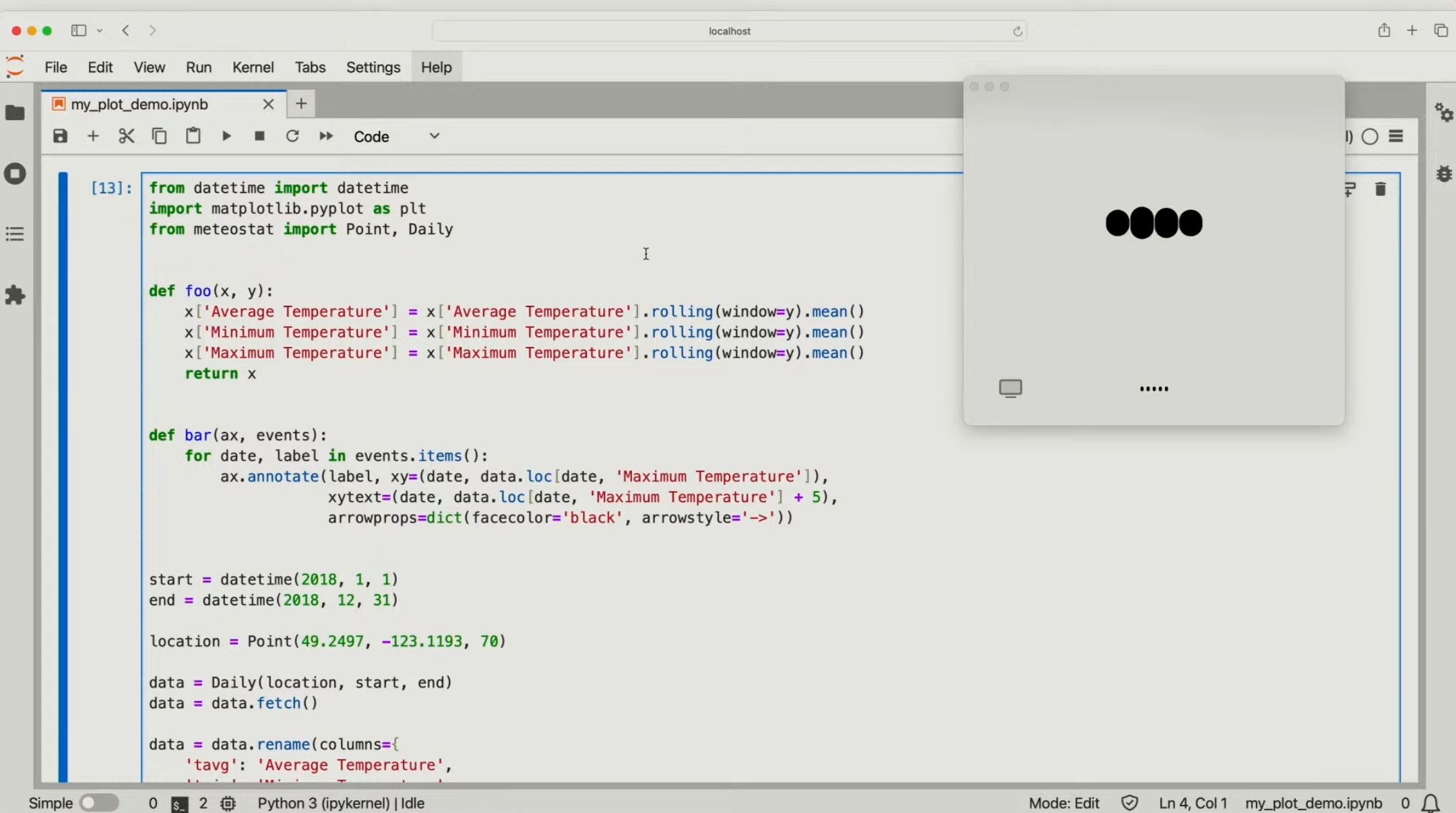

6. 编程助理:工作人员打开电脑页面,只需要 highlight 代码,并通过语音交流,GPT-4o 就可以给出答案。

7. 实时翻译:现场展示了意大利语和英语的即时互译,非常快速且准确。

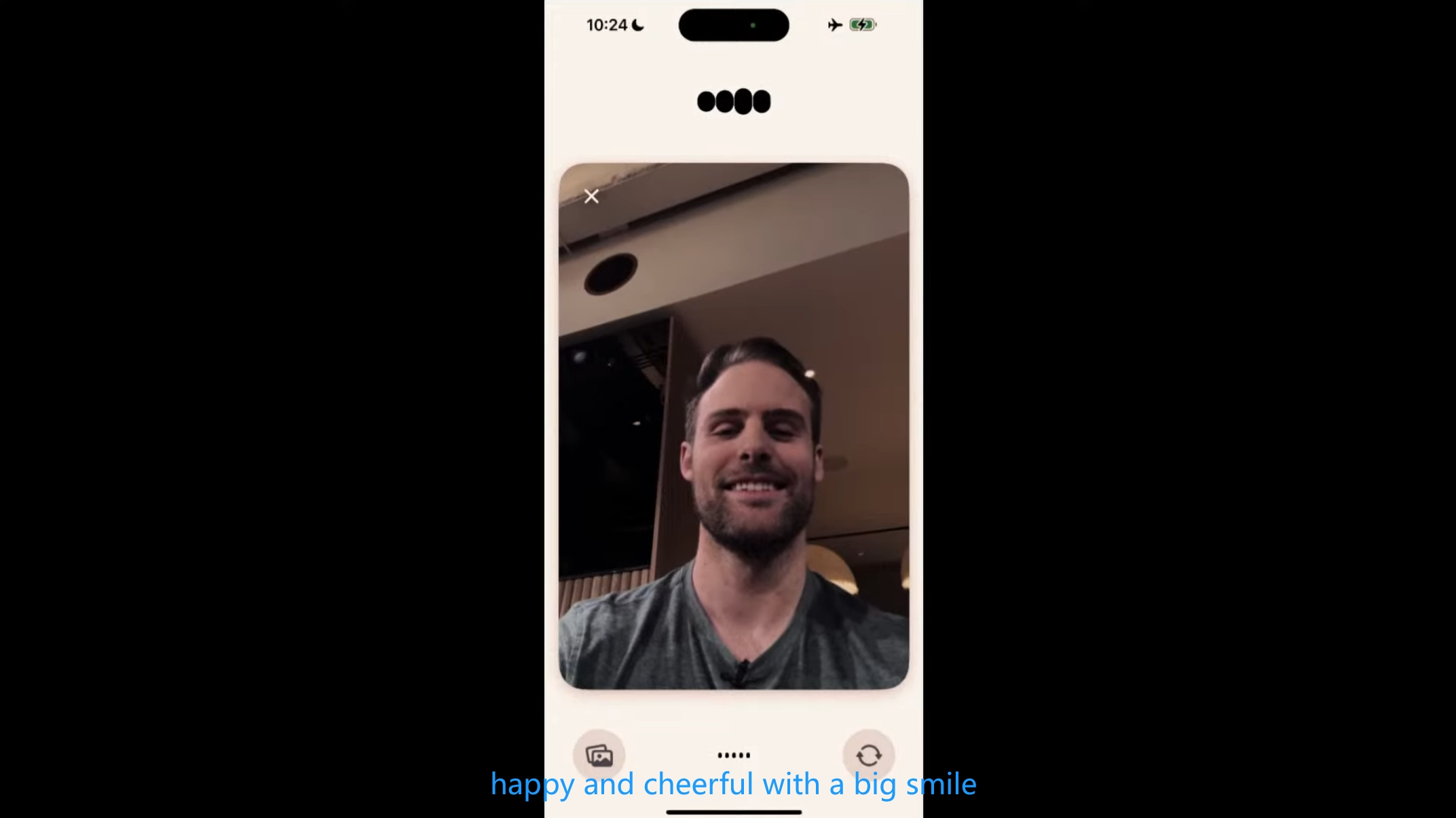

8. 情绪感知:最后演示人员拍摄一张自拍照,让 ChatGPT 通过他的面部表情推断情绪,成功识别出他愉快和兴奋的情绪状态。

尽管此次发布会没有提及 GPT-5,但通过 GPT-4o 的发布,Sam Altman 放的这些“神奇”大招,我们也可以看到其对 AI 技术持续进步的承诺,也预示了语音交互和 AI 技术的新纪元。

直播回放地址:https://www.youtube.com/watch?v=DQacCB9tDaw

本文转自:图灵编辑部,转载此文目的在于传递更多信息,版权归原作者所有。如不支持转载,请联系小编demi@eetrend.com删除。