本文由半导体产业纵横(ID:ICVIEWS)综合

深度学习及其驱动的硬件不断发展。

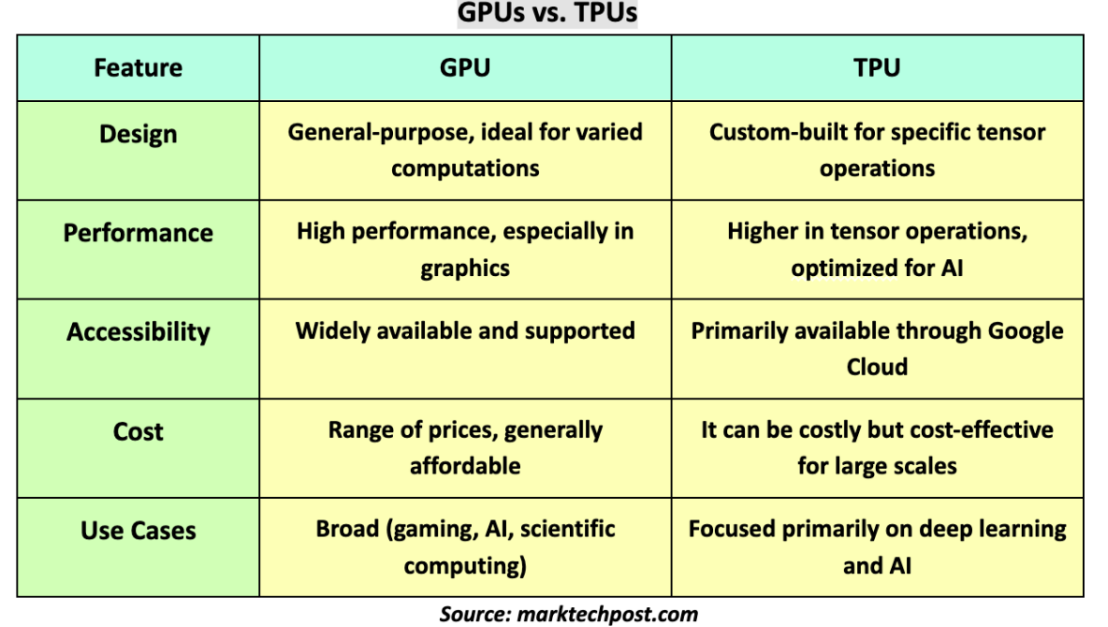

深度学习极大地改变了从医疗保健到自动驾驶的各个行业。然而,如果没有硬件技术的并行发展,这些进步就不可能实现。一起探讨深度学习硬件的演变,重点关注 GPU 和 TPU 以及未来的发展。

GPU 的兴起

图形处理单元在深度学习革命中发挥着关键作用。GPU 最初设计用于处理计算机图形和图像处理,在执行深度学习核心的矩阵和向量运算方面非常高效。

GPU适合深度学习的原因有以下几点:

首先,GPU相比于CPU拥有更多独立的大吞吐量计算通道,较少的控制单元使其不会受到计算以外的更多任务的干扰,拥有比CPU更纯粹的计算环境,所以深度学习和神经网络模型在GPU的加持下会更高效地完成计算任务。

其次,深度学习的核心是参数学习,各参数之间相对独立,可以并行处理,而GPU适合逻辑简单的并行处理。

此外,GPU的架构适合计算密集和数据并行的程序,而深度学习恰好满足这两点。

最后,GPU可以提供最佳的内存带宽,并且线程并行带来的延迟几乎不会造成影响,这也是GPU适合深度学习的原因之一。

TPU的介绍

张量处理单元(TPU)是一种定制化的 ASIC 芯片,它由谷歌从头设计,并专门用于机器学习工作负载。TPU 为谷歌的主要产品提供了计算支持,包括翻译、照片、搜索助理和 Gmail 等。Cloud TPU 将 TPU 作为可扩展的云计算资源,并为所有在 Google Cloud 上运行尖端 ML 模型的开发者与数据科学家提供计算资源。

为了比GPU更快,谷歌设计了神经网络专用处理器TPU,进一步牺牲处理器的通用性,专注于矩阵运算。TPU不再支持各种各样的应用程序,而是仅仅支持神经网络所需的大规模的加乘运算。

因为一开始就知道自己要计算的单一矩阵乘过程,TPU直接设计了数千个乘法器和加法器直连的大型物理矩阵。如Cloud TPU v2,包括2个128*128的计算矩阵,相当于32768个ALU。

TPU的计算过程如下:先将参数W从内存加载到乘法器和加法器矩阵中,然后,TPU从存储器加载数据X。在执行每个乘法时,计算的结果将传递给下一个乘法器,同时求和。因此,输出是数据和参数之间所有乘法结果的总和。该过程最大的特点是,在整个海量计算和数据传递过程中,不需要内存请求。

这种方式既提升了神经网络的运算效率又节省了功耗,低资源消耗带来的是低成本,对普通大众来说就是更加便宜。谷歌自己测算TPU的计算成本大概是非TPU的1/5,在谷歌云的TPU服务看上去也比较亲民。

超越 GPU 和 TPU的未来技术

深度学习硬件的格局正在不断发展。

以下是一些可能塑造未来的新兴技术:

FPGA(现场可编程门阵列):与 GPU 和 TPU 不同,FPGA 是可编程的,并且可以在制造后重新配置,这为特定应用提供了灵活性,它可以根据具体的深度学习模型和算法进行编程和配置。FPGA具有并行计算能力,可以快速执行深度学习中大量的矩阵运算和张量操作。在深度学习模型中,这些计算是非常耗时的,但FPGA可以通过硬件级别的并行计算,在同一时间内执行多个计算任务,显著加速计算速度。

ASIC(专用集成电路):是为特定应用量身定制的,可提供最佳的性能和能源效率。用于深度学习的 ASIC 仍处于早期阶段,但在未来的优化方面前景广阔。

神经形态计算:神经形态计算的想法是从大脑中汲取灵感,设计出融合内存和处理能力的计算机芯片。在大脑中,突触提供对处理信息的神经元的直接记忆访问。这就是大脑以很少的功耗实现令人印象深刻的计算能力和速度的方式。通过模仿这种架构,神经形态计算为构建智能神经形态芯片提供了一条途径,该芯片消耗很少的能量,并且计算速度很快。该技术有望大幅降低功耗,同时大幅提高处理效率。

挑战和未来方向

虽然深度学习硬件的进步令人印象深刻,但它们也面临着一系列挑战:

高成本:开发 TPU 和 ASIC 等定制硬件需要大量的研究、开发和制造投资。

软件兼容性:确保新硬件与现有软件框架无缝协作需要硬件开发人员、研究人员和软件程序员之间的持续协作。

可持续性:随着硬件变得越来越强大,它也会消耗更多的能源。使这些技术可持续发展对于其长期生存至关重要。

结论

深度学习及其驱动的硬件不断发展。无论是通过 GPU 技术的改进、TPU 的更广泛采用,还是神经形态计算等突破性的新技术,深度学习硬件的未来看起来令人兴奋且充满希望。开发人员和研究人员面临的挑战是平衡性能、成本和能源效率,以继续推动能够改变我们世界的创新。

本文转自:半导体产业纵横,转载此文目的在于传递更多信息,版权归原作者所有。如不支持转载,请联系小编demi@eetrend.com删除。