全文速览

机器学习模型由于其卓越的准确性,被越来越多地用于材料研究。然而,最精确的机器学习模型通常很难解释。解决这一问题的方法在于可解释人工智能,这是一个新兴的研究领域,致力于解决复杂机器学习模型(如深度神经网络的可解释性。本文试图为材料科学家提供一个可解释的切入点。定义概念是为了在材料科学的背景下澄清解释的含义。通过实例说明可解释性对材料科学研究的帮助,同时也讨论了挑战和机遇。

背景介绍

机器学习模型有不同的可解释性。像线性/逻辑回归、决策树、k近邻、贝叶斯模型、基于规则的学习者和一般的相加模型等简单模型通常被认为是透明的,可以直接检查。另一方面,像树集合、支持向量机和神经网络这样的复杂模型通常被认为是黑盒子,很难解释。实际上,在模型复杂性和模型可解释性之间通常存在权衡。虽然机器学习模型通常需要较高的复杂性,以在困难的问题上获得较高的精度,但同样的复杂性也带来了可解释性的挑战。本文讨论的大多数例子都涉及神经网络,但这里描述的一般原则适用于不同的ML模型和解释技术。

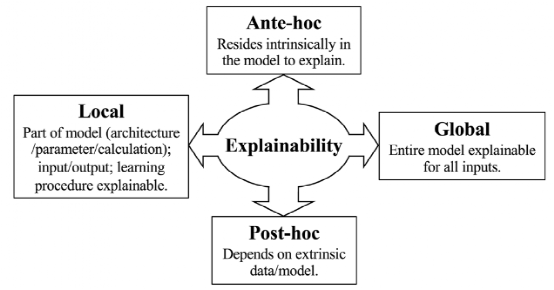

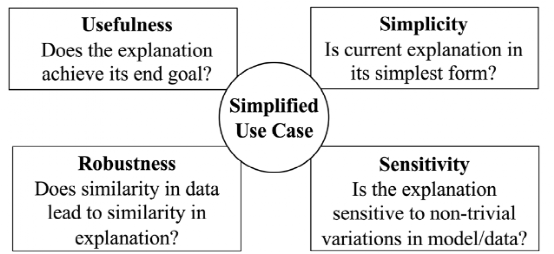

本文在下图中总结了不同的可解释性范围,并以下方式为材料科学应用定义一些基本的概念。如果所有模型组件都很容易理解,那么模型就是透明的。如果模型的一部分(例如函数形式、参数、计算)是明确可理解的或基于物理基础的,则该模型在本质上是可解释的。可以通过简化其工作逻辑或提供(数据)证据来支持其推理,从外部解释非透明模型。

图文解析

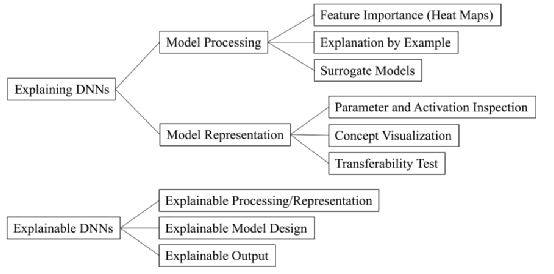

本节根据下图从不同的视角介绍了一些具有代表性的可解释性技术和最新的材料科学应用实例。

Feature importance

特征重要性在材料科学界是一个非常流行的模型处理解释方法,特征重要性技术解释模型如何处理输入数据,通过回答诸如“这个输入的什么独特特征使它能代表输出?”这样的答案通常表示为输入数据特征的权重。权重越大,从模型的角度来看对应的特征越重要。在对物理知之甚少的复杂或新颖材料系统中,特征重要性权重可以帮助材料科学家理解该系统及其基础物理。在物理已经被理解的材料系统中,特征重要性权重可以帮助材料科学家在模型预测中获得信任(如果特征权重符合物理定律)或提高模型性能(如果特征权重揭示了模型失败的原因)。

Explanation by example

第二种解释神经网络模型推理的方法是展示说明性数据示例。对人类推理的研究表明,举例对战略决策至关重要。一些例子有时比一长段的描述或一组复杂的预先确定的方程和系数更有表现力。数据示例解释的一个常见用例是ML模型可信性的评估。ML模型的可信度通常通过测试精度来评估,测试精度反映了模型在训练过程中未显示的新数据实例上的性能。然而,测试的准确性并不完美,因为并不是所有的新数据实例都是相同的。

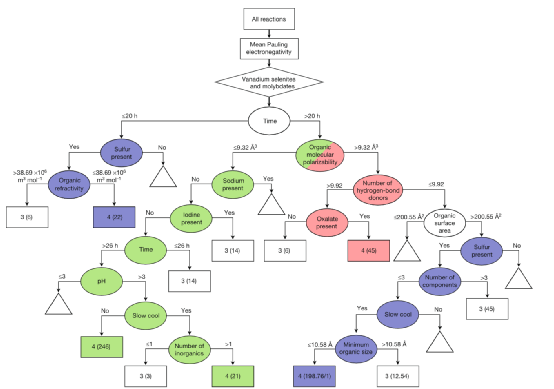

Surrogate models

第三种解释黑盒模型数据处理的方法是构建简单的代理模型,这些代理模型的行为与原始黑盒相似,但更容易解释。注意,前两种数据处理解释方法(热图和数据示例)旨在解释原始黑匣子的特定决策。代理模型方法的角度略有不同,它只使用原始黑箱来训练代理模型。换句话说,解释是从代理模型而不是从原始黑箱中派生出来的。隐含的假设是,原始模型和替代模型的相似行为表明它们已经学习了相似的知识集。

Parameter and activation inspection

神经网络通过针对训练数据优化其参数进行学习。网络参数是否包含有用的信息?这个问题可以通过直接在材料科学领域知识的背景下解释网络参数来回答。

Concept visualization

人们还可以将在单个网络组件中学习到的不同概念可视化。其思想是在网络组件中学习到的概念可以用高度激活该网络组件的原型输入来表示。

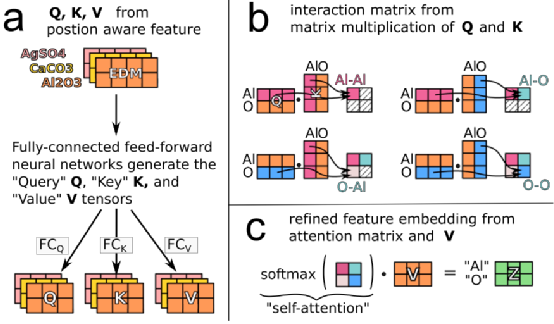

Explainable processing/representation

Transformer是一种基于可解释的自我注意机制设计的深度神经网络,近年来在许多不同领域取得了显著的成功。目前在材料科学问题中,Transformer可能还没有得到充分的应用,因此本文将详细介绍变压器的主要思想。Transformer的核心是一个可解释的数据处理设计,称为self-attention。如果网络能有效地搜索相关信息,它就有可能成功。现代搜索过程通常使用三个关键组件:查询、键和值。例如,要搜索一篇关于材料科学中的机器学习的论文,我们会在搜索引擎中输入一个查询“材料科学中的机器学习”。搜索引擎将查询与所有论文的键进行比较,并返回一个相关性排名。然后根据相关性排名来检查论文的细节。当然,在神经网络预测问题中,只知道预测的输入和输出,而不知道适当的查询、键或值。ML解决方案是实现三个数字矩阵,分别对应查询、键和值,然后让网络自动学习这些矩阵对于那些真正重要的特征稀疏或长期交互作用起重要作用的材料任务,注意机制可能有用。

Explainable model design

黑盒神经网络可以有一些可解释的设计选择。就像物理感知核有时被认为比默认的线性/高斯核更容易解释一样,具有材料科学领域知识启发的设计选择的神经网络比为一般用途设计的现成神经网络更容易解释。

Explainable output

最后,一些神经网络可以产生可解释的结果,尽管网络本身的数据处理非常复杂。这些神经网络可以帮助解决材料科学问题中缺乏基础真理的挑战。

挑战与机遇

将目前的可解释人工智能技术应用于材料科学问题的一个常见挑战是缺乏明确的基础事实。许多可解释人工智能技术最初是为自然数据设计的,这些数据包含明确的基础原理。这样的可解释人工智能技术通常对数据的显式、清晰性有一个隐含的假设,并相应地推导出模型解释。对这种缺乏基本真理的挑战的补救办法可能在于材料科学领域的知识、实验材料科学家、计算材料科学家和机器学习科学家需要合作,将抽象的材料科学领域知识转为明确的形式,然后利用这些明确的知识来接近可解释性。

另一个挑战是对解释的评估到目前为止,很多材料对可解释人工智能技术的解释还没有仔细评估。这种缺乏评价是可以理解的,因为解释评价是非常困难的。评估是XAI的一个重要组成部分,不应该被忽视。需要在三个方面进行更多的研究:(1)形式化的完整性检查; (2)设计新的自定义解释评估管道 (3)融入更多的人为互动,最大限度地提高解释评价的灵活性。

第三个挑战是解决机器学习模型和可解释人工智能技术的不当行为。即使遵循了适当的数据清理和模型训练过程,机器学习模型和可解释人工智能技术也可能表现得不合逻辑。

原文链接:https://doi.org/10.1038/s41524-022-00884-7