近日,清华大学温玉辉博士后作为第一作者、清华大学刘永进教授和中科院计算所高林副研究员作为共同通讯作者、与香港城市大学傅红波教授、新西兰惠灵顿维多利亚大学张方略博士和中科院计算所夏时洪研究员合作,在IEEE T-PAMI上发表论文[1],提出结合局部和全局时间模块的Motif图卷积网络模型用于人体运动识别,目前该方法已开源基于计图(Jittor)框架的代码。

Part1、研究背景

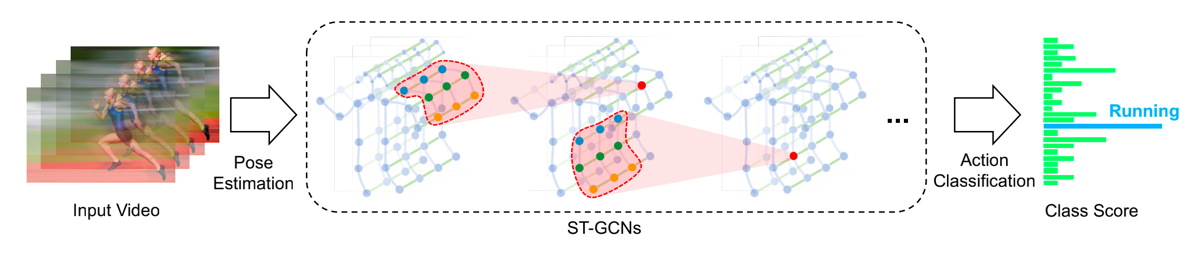

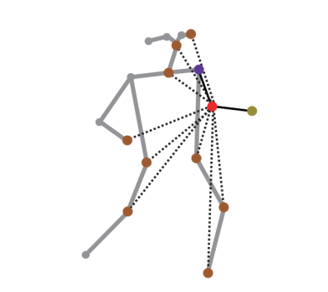

人体运动识别是计算机视觉研究中的经典问题,因其在人机交互、医疗监护和视频监控等场景的应用而受到广泛关注。基于图卷积网络自动提取骨架图序列的时空特征用于人体运动识别的方法(如图1所示),已经取得了很大进展[2-3]。

在骨架图中,关节和骨骼分别用图的节点和边表示。现有方法主要关注于改进图卷积操作建模骨架图空间特征[2-3],包括在关节之间引入对提升运动识别准确性具有重要意义的非物理连接关系[3],比如看表这一动作中,头部和手部之间的非物理连接关系。

非物理连接关系的引入为各关节建立了全局连接关系,能够在关节之间更高效地传递信息。然而,任意关节之间的关系十分复杂并存在层次结构,现有方法往往需要预训练来有效地建模这种关系[3]。此外,现有方法往往采用普通卷积操作提取骨架图序列的局部时序特征,无法高效地建模全局时序特征[2-3]。

Part2、方法简介

为了解决这些问题,论文提出了稀疏Motif图卷积子模块建模骨架关节之间的父子关节层次结构并且引入关节之间的稀疏非物理连接关系,从而提取骨架图空间特征[1]。具体地说,Motif图卷积受到复杂社会关系网络研究中定义不同语义连接关系的知名概念Motif的启发[4,5]。

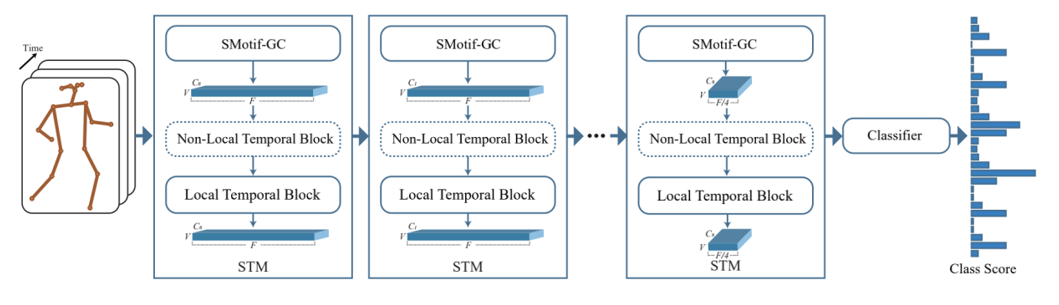

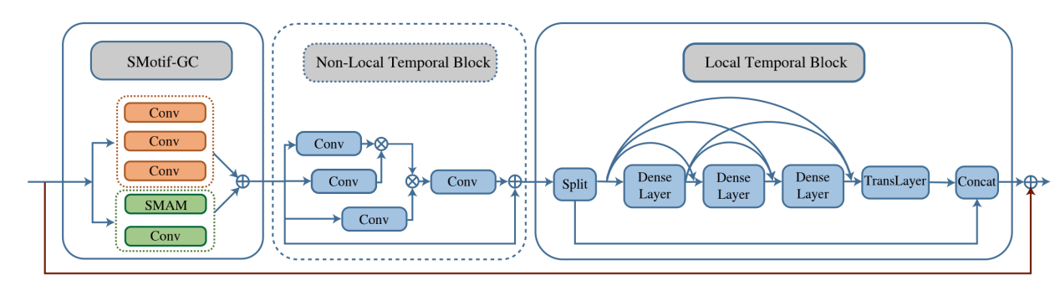

论文基于人体运动先验知识(关节之间的层级结构和稳定特性以及非物理连接关系的动态特性),引入Motif概念建模骨架图中的语义临近性。此外,结合局部和非局部时间子模块高效提取丰富的时间特征。论文提出的整体网络架构图如图2所示。

对于空间特征提取,稀疏Motif图卷积(sparse motif-based graph convolution,简称为SMotif-GC)建模骨架图(如图3所示)对各关节(以图3中红色节点关节为例)和其“邻居”关节之间建立不同的连接关系用于信息传递。论文中,“邻居”关节被定义为具有不同Motif语义角色的关节,包含关节本身(红色节点)、父关节(紫色节点)和子关节(黄绿色节点)以及非物理连接关节(橙色节点)。

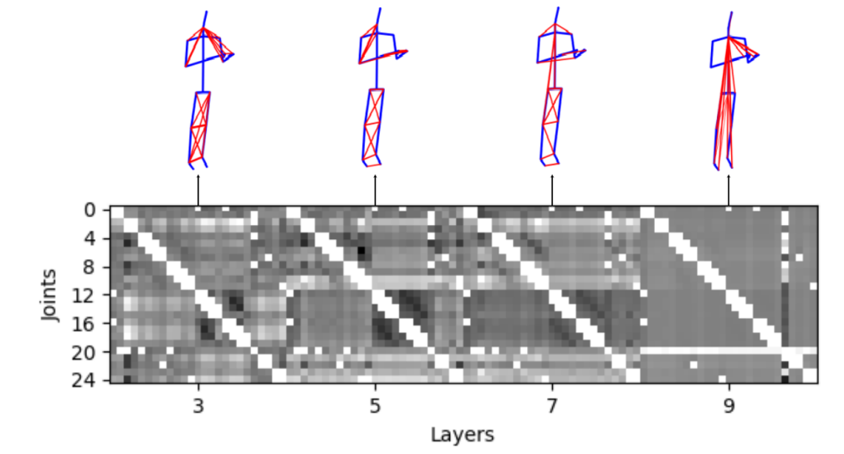

物理连接关节之间的关系较为稳定,不会随着运动过程发生变化,因此这种连接关系由预定义的邻接矩阵表示。非物理连接关节之间的关系较为复杂并且会随着运动过程发生变化,因此这种连接关系由可学习的稀疏Motif邻接矩阵定义,该稀疏矩阵可随着网络各层之间的信息传递更新(如图4所示),保留有效非物理连接关系,摒弃多余非物理连接关系,从而更高效准确地在关节之间传递信息提取空间特征。

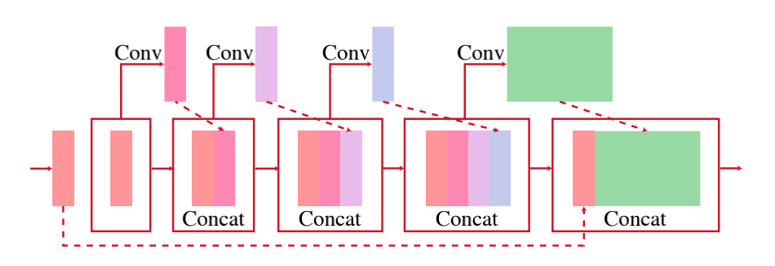

对于时间特征提取,首先, 利用局部时间模块(local temporal block ,简称为LTB)通过密集连接能够重用和保持不同局部时间窗卷积层的特征,提高时间特征传递效率,如图5所示。

进一步,利用基于注意力机制的全局时间模块(non-local temporal block, 简称为NLTB)在骨架图序列不同时间帧之间建立全局联系,并与局部时间模块相结合,从而更高效准确地提取时间特征。由SMotif-GC、LTB和NLTB构成的时空模块详细结构,如图6所示。

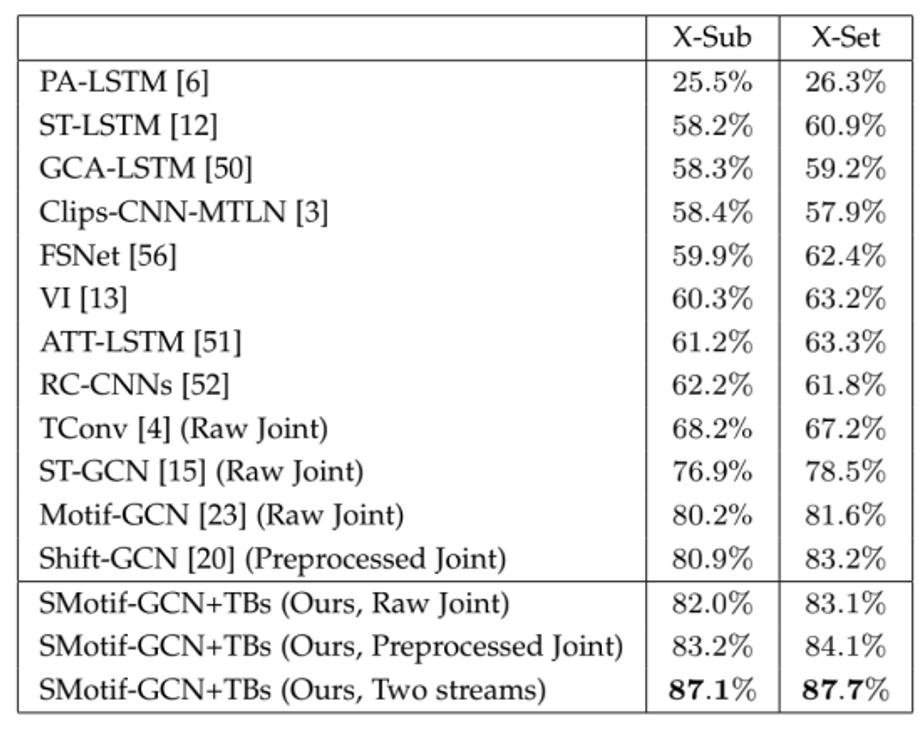

论文在四个具有代表性的人体运动识别数据集上的识别准确率优于现有方法,特别是在NTU-RGB+D-120数据集[6]上获得准确率的大幅度提升(Preprocessed Joint: 83.2% vs. 80.9(X-Sub)), 如表1所示,其他比较结果见论文。

该方法目前已基于计图(Jittor)框架开源,代码由清华大学计算机系大三本科生雷长松实现。在相同batchsize下,Jittor的训练速度较Pytorch版本代码提升约50%,效果显著。

论文网页:

https://ieeexplore.ieee.org/document/9763364

代码开源:

https://github.com/wenyh1616/SAMotif-GCN/tree/jittor

参考文献

Y-H Wen, L Gao, H Fu, F-L Zhang, S Xia, Y-J Liu, Motif-GCNs with local and non-local temporal blocks for skeleton-based action recognition, IEEE T-PAMI, 2022, doi: 10.1109/TPAMI.2022.3170511

Yan S, Xiong Y, Lin D, Spatial temporal graph convolutional networks for skeleton-based action recognition, AAAI, 2018, article No.: 912, 7444–7452.

Li M, Chen S, Chen X, et al. Actional-structural graph convolutional networks for skeleton-based action recognition, IEEE/CVF CVPR, 2019, 3595-3603.

Benson A R, Gleich D F, Leskovec J, Higher-order organization of complex networks, Science, 2016, Vol. 353, No. 6295, 163-166.

Fang Y, Lin W, Zheng V W, et al. Semantic proximity search on graphs with metagraph-based learning, IEEE ICDE, 2016, 277-288.

Liu J, Shahroudy A, Perez M, et al. Ntu rgb+ d 120: A large-scale benchmark for 3d human activity understanding, IEEE T-PAMI, 2019, Vol. 42, No. 10, 2684-2701.