科技正在复刻神话。在远古神话里,女娲模仿水中映像,抟土成人;在当代神话中,人类模仿自身智识和体能,创造AI。

AI看似是人的对立面,精准、冰冷且绝对理性;人则是偏见的集成,这偏见来源于既有的知识储备、思维方式、立场、情绪和习惯。

但在现实世界里,由人创造、从人类数据中学习观察的AI,却常常表现出和人类相似的偏见,从招聘中的性别歧视,到人脸识别下的种族误判。AI的偏见从何而来?在科技能量日益增强的当下,我们如何减少算法的歧视与偏见,让它发挥更多向善的力量?

算法的偏见:一面折射现实之镜

男性比女性更胜任技术岗吗?这一显然带有偏见的问题却曾经被AI当成招聘的依据。

2018年的一则报道指出,亚马逊的机器学习专家发现,他们的AI招聘引擎有“重男轻女”倾向。当AI在简历中识别到“女性”关键词时,会自动降低应聘者的分数。同时,AI还下调了两所女子学院的毕业生评级。在意识到这一系统性偏见之后,亚马逊终止了这一项目。

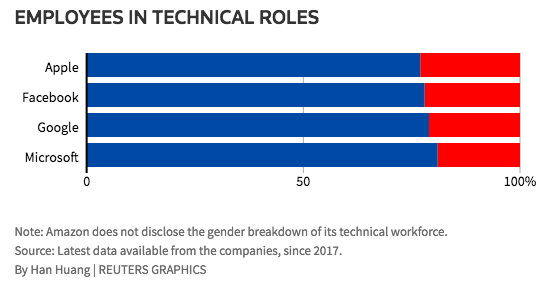

AI招聘引擎偏见的来源正是现实社会。通过学习过去十年软件开发等技术行业的简历,AI探索到一种固有模式并把它作为审查标准:大部分简历来自男性,女性相关数据较少。而这,也正是彼时男性在科技行业占主导地位的状态。

在应用更为普及的人脸识别领域,算法偏见同样存在。美国NIST(国家标准及技术研究院)2019年12月的一份研究报告揭示了人脸识别软件在不同种族、性别、年龄上的差异。该项研究检查了99家公司、学术机构等189种算法,涵盖包括英特尔、微软、松下、商汤等业界知名技术公司。

调研结果显示,在手机人脸解锁等一对一匹配中,亚裔和非裔的人脸识别错误率是白人的10到100倍;老年人和儿童更容易被认错,女性相较男性更容易识别错误,中年白人准确率最高。

算法的某些“偏见”,可能会导致手机无法解锁,造成生活上的麻烦;也有可能引发更严重的后果,让无辜的人蒙受不白之冤;更重要的是,它某种程度上在持续强化现实社会既有的偏狭与成见,阻碍人类追求公平、平等和文明。

透视算法偏见的三大根源

随着现代科技的快速发展与普及,越来越多的人们意识到科技并非纯然中性。只有理解算法“偏见”的来源和成因,我们才能更好地纠偏。以机器学习为例,其偏见的来源主要有以下三大因素:

不完整的或有偏差的训练数据集

当训练数据中缺少某种统计类别时,AI习得的模型就无法正确衡量这部分特征。

这很好理解,如果训练数据中男性比例过低,这一算法模型应用于男性时就有更大的误差;如果训练数据中关于“医生”的照片大部分是女性,搜索“医生”图片时,算法就会放大女性出现的概率。

上文提到的亚马逊招聘AI的性别偏见,正是训练样本不完整、不足的典型代表。

训练模型代入人的标签和偏见

据悉,绝大多数商业AI系统使用有监督机器学习,因此训练数据需要人为打上标签,这就难免会有意无意将人的偏见编码到算法模型中。如人在设定标签时,将“身材的胖瘦”与“美”联系起来,算法自然会继承这一偏见。

算法和技术的缺陷

算法的逻辑、机器学习模型的输入/训练上的偏差也会引发偏见。

举例来说,2020年,美国杜克大学提出一种新型算法PULSE,它是一款“去码神器”,经过运算与处理,能够将低分辨率、模糊的照片转换成清晰且细节逼真的图像。

但很快有人发现,它将很多低清少数族裔人脸图像生成为极强白人特征的人脸图片。除了训练数据不完整之外,也有学者认为是PULSE选择像素的逻辑出现了偏差,因为一张低分辨率图片,对应着可能的数百万种高分辨率虚构照片,选择哪条“解码”路径,则取决于算法逻辑。

如何日益消除AI偏见的负面影响?这不是一蹴而就的事。我们既要警惕并正视自身环境中习以为常的偏见,尽可能看到更多元、更丰富的人群和事物特征,减少有伤害性的标签;同时也要不断提升算法和技术实力,求得更优解。

我们能够信任算法吗? “可解释性”打开黑箱

从另一个层面讲,正如每个人都有偏见一样,AI也不可能做到绝对的理性客观。当我们致力于从源头减少“偏见”,寻找一种更公平共识的同时,也需要思考另一个问题:AI值得信任吗?

不可否认,AI给现代社会创造了极大的便利,从工业制造上高效的自动化发展,到生活中测温、人脸识别等无处不在的便捷。但关于算法的怀疑一直都在。算法和普通人的生活紧密相关,却以一种普通人无法理解的方式在黑箱操作,我们是否正在不知不觉间被算法奴役?

人和算法的“不可沟通性”,导致了这种不信任。简单来讲,人类使用高阶语言思考和交流,而算法关注低阶要素,一切元素都被扁平化为数据点。一张图片,人类看到的是颜色、大小、形状,而算法看到的是像素。只有实现两者语言转换,才能够让人们理解算法,从而减少自身或算法的偏见。

因此,自2016年起,世界各国政府及各类非官方社会组织都开始强调要加强AI的可解释性。2017年初,美国计算机协会、美国公共政策委员会发布了《算法透明性和可问责性声明》,提出了七项基本原则,要求对算法的过程和特定的决策提供解释。2018年5月25日,欧盟正式实施《一般数据保护条例》(GDPR),这一举措被认为正式确立了算法解释权。

同时,随着AI算法在娱乐、消费等各个领域渗透进普通人的日常生活,人们越来越关注数据隐私、算法偏见等问题。算法的透明性、可解释性成为迫切的需求,包括微软、谷歌、Oracle等诸多科技巨头,都在开展相关技术研发,推进AI模型决策的透明性。

偏见、歧视、错误、质疑……是科技进步必经之路。踏上AI这条惊喜与恐惧交叉的并行道,我们进步的永恒方式就是从错误中学习,由误解迈向沟通,叩问习以为常的现象,不断思考更公平、合理的目标,由此我们才能认识到AI的偏见,并努力减少偏见带来的固化和负面影响,让AI成为创造美好未来的向善力量。

参考链接

当AI有了“自由意志”

谷歌让普通人读懂 AI

改善AI性别偏见的4种方法

亚马逊 AI 在简历筛选中歧视女性?AI 犯错不是第一次了

本文转自:联想控股微空间,转载此文目的在于传递更多信息,版权归原作者所有。如不支持转载,请联系小编demi@eetrend.com删除。