来源: 华院计算

导读

智能机器最终会脱胎于我们对大脑的理解,还是独立诞生于与神经科学无关的工程学,这是一个开放的问题。我相信在很多场合,我们仍然需要理解人类智能,理解智能是如何在大脑中产生的。不过制造智能机器是否需要神经科学的参与,我认为很有可能这场有趣的角逐赛的结果值得在未来的几十年中期待。——Tomaso A.Poggio教授

AI的成功故事

在过去的25年中,尤其是在刚刚过去的十年中,AI,特别是机器学习,已经拥有了十足可观的进展。

两个主要的成功故事第一个是AlphaGo。在虚拟的游戏世界中,AI绝对已经战胜了人类。AlphaGo由DeepMind研发,Demis Hassabis作为发起人。另一个故事是Mobileye,现在已经属于Intel公司,Amnon Shashua作为奠基人。Mobileye已经成为了拥有视觉的自动驾驶系统的领军者。现今的Mobileye系统中,每跑五万公里才会出现一次错误。所以,在二十多年里,性能提升的比例是百万级,约等于在长达二十多年里每年的准确率都接近于翻倍。

这些成功故事的核心是现代机器学习的两个关键算法——强化学习、深度学习。DeepMind和Mobileye都使用了这两种算法。DeepMind着重于强化学习,Mobileye更倾向于深度学习。不过这两种算法都是它们成功的关键。值得一提的是这两家公司的创始人 Demis Hassabis 和Amnon Shashua都曾是Tomaso A.Poggio教授的博士后学生。

下一个突破点在何处

我们如何解决智能的问题?下一个突破点将在何处?Tomaso A.Poggio教授认为:“过去的经验告诉我们,历史上的突破口来自神经科学,所以我预计未来的一些突破性进展也将来自于神经科学。”

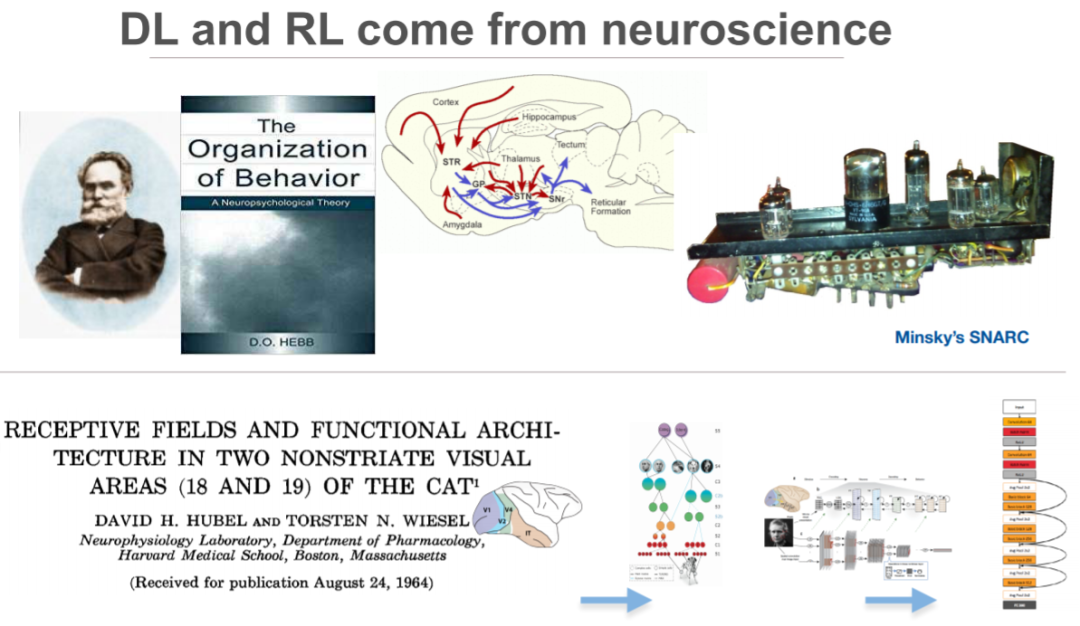

回溯强化学习和深度学习的历史,会发现它们都来自于神经科学。强化学习可以追溯自巴浦洛夫的行为神经学,而深度学习来自于哈佛大学David Hubel和Torsten Wiesel在研究视觉中枢的生理学中所做的工作。他们记录了猫和猴子的视觉神经结构,并提出了一种视觉中枢的神经架构。正是这种架构,而非模型训练技巧,在深度学习神经网络中得到了应用,甚至包括了最近的残差神经网络ResNet。

Tomaso A.Poggio教授带领的团队CBMM(大脑、思维和机器中心),主要目标是理解大脑和智力是如何实现的,并且从对此的理解出发,研发更多智能机器。而究竟智能机器最终会脱胎于我们对大脑的理解,还是独立诞生于与神经科学无关的工程学,这是一个开放的问题。Poggio教授认为在很多场合中我们仍然需要理解人类智能,理解智能是如何在大脑中产生的。制造智能机器需要神经科学的参与是极有可能的。这场有趣的角逐赛的结果值得在未来的几十年中期待。

深度学习的一些谜题

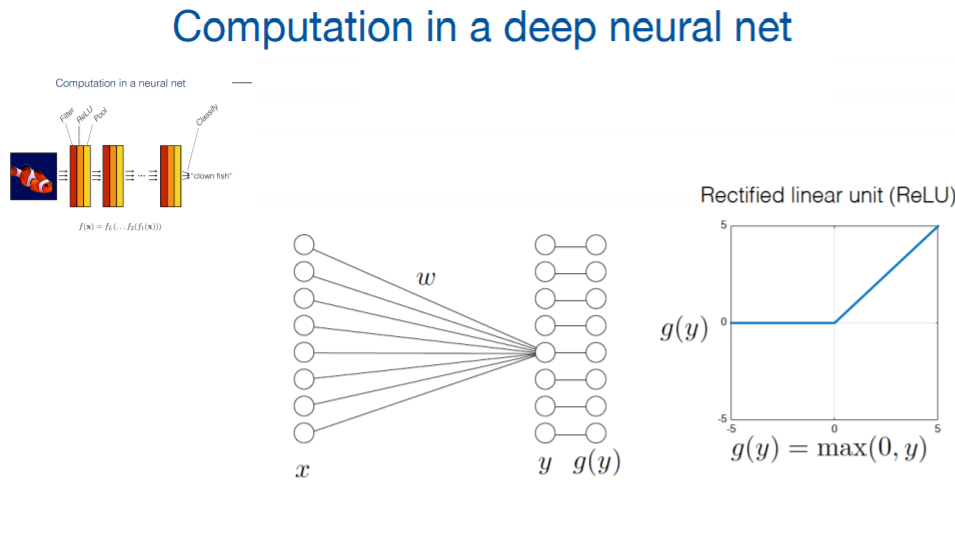

如果你了解一些机器学习,这些问题与深度神经网络的一个奇怪的特征相关,即神经网络中参数数量往往远多于训练数据。如果你有一个模型,并且你想要求解一些参数值,你最好准备两倍于参数数量的数据点,最好十倍。不过神经网络似乎违背了这个共识,实际上依靠少于参数数量的数据运行。在深度神经网络中,拥有多层神经元,每个神经元会提交大量输入数据,并被分配一个权重。这些输入的加权总和当然是一个数字,然后会通过一个整流函数(rectifier),这就是一个完整的操作。这个操作会在每一层网络的每一个神经元上重复。

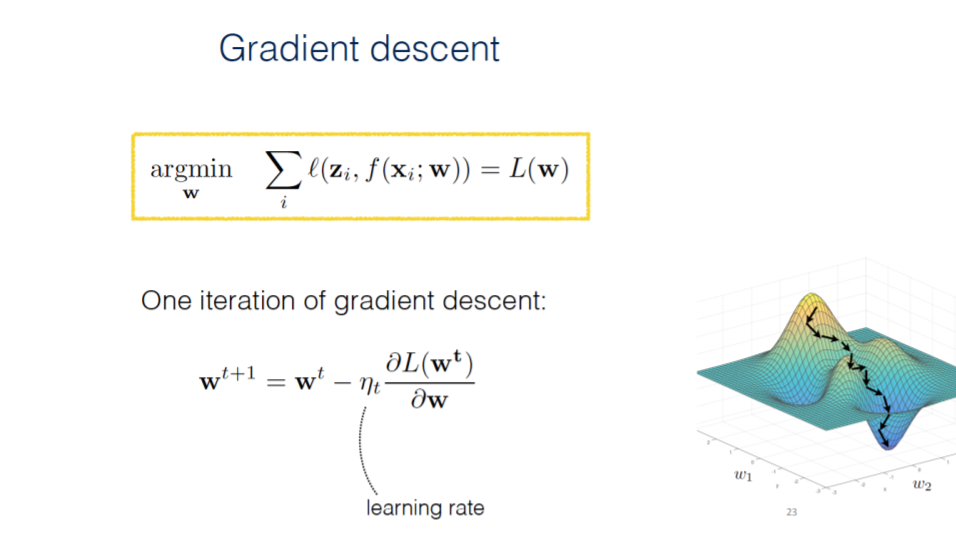

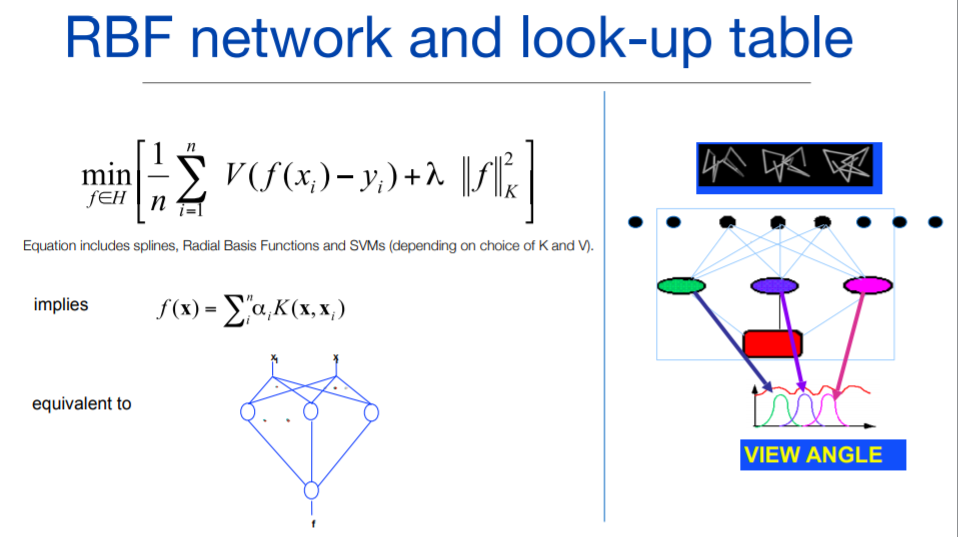

训练这样的一个计算网络的关键就在于找到这些参数的正确值。这些参数即为权重矩阵。每层网络,或多层网络会形成一个矩阵。你必须解出这些参数的数值。对于每一组数据,你想要找到能使该神经网络的预测值与结果的真值之间的差距测量值最小化的参数值。

如图所示训练数据,输入的向量可以是一幅图片,而输出值则为图片中所包含物体的标签。如果你试图找到训练数据的某个元素的测量值的最小二乘,而你使用了梯度下降算法,或者更具体的,随机梯度下降算法,则损失函数不是在所有样本上求和,而是在样本的随机子集上求和,会一步步改变梯度下降的方向。这种计算方法非常成功。现在这些深度网络中的数学谜题开始逐渐被解决了。剩下的便是理解深度网络中缺失的部分,与真正智能的差距。

联想记忆、进化和智力循环训练

从智能的科学的角度出发,现在的问题是,人类智力的底层回路是什么?大脑中存在着什么?进化是如何发现它们的?发现的结果是什么?回溯到五十多年前的一些研究成果,正是这些成果基于对所谓的“全息记忆”(holographic memories)的特性的模拟,提出了神经网络,早期神经网络。这些网络被称为联合内存/关联记忆(associative memories)实际上与当今的神经网络并无太大差别。当今的神经网络事实上在处理对于训练集中未曾出现过从而未进入记忆的输入值x的泛化问题,然而当年的研究重点在于记忆过的输入值。实际上,那些与现今神经网络相似的网络同样拥有记忆和泛化的能力。看起来仍然关于人类智力的很多方面仍然不能被大型关联记忆所解释。部分是由于我们没有像神经网络一样被大量训练数据所训练。所以,大型关联记忆的解释不足以解释人类智能。

那进化发现了什么呢?进化可能发现了一些优于关联记忆的技巧。最自然最简单的一种,就是可能自然进化出了类似于图灵机的回路,关联记忆是其中的一部分,不过本质上它是一个关联了输入和输出的程序。不过在一个连续状态的系统下,也有通关关联记忆产生的关联。这样你便拥有了一个远强于关联记忆的计算系统。图灵机是一种通用计算机。从神经回路的观点出发,进化的发现可能就是隐藏态的循环和输入输出的循环。

这并不是一个完整的解释,不过可能是一个开端,用于研究进化是如何使得中枢回路能够强力且通用地处理不同的输入,从视觉输入到听觉输入、语言输入。这些程序跑在这些图灵机上,它们是如何存储的?进化是如何发现了它们并且使它们优化?最后的部分是Poggio教授的推测,他希望它们能给大家一些构建智能问题的语境。

来源: 华院计算

转载此文目的在于传递更多信息,版权归原作者所有。如不支持转载,请联系小编demi@eetrend.com删除。