如今,人工智能无疑是最热门的技术之一。人工智能的发展离不开机器学习算法的不断进步,而作为机器学习的一个分支,深度学习也在其中起着重要的作用。然而,深度学习目前也是存在着一些棘手的问题。近日,《福布斯》采访了与人工智能相关的高管,就2019年人工智能发展趋势进行了预测。MediaMath首席技术官普拉萨德·查拉萨尼表示:“深度学习模型已经被证明很容易受到数据中难以察觉的扰动,这些扰动会欺骗模型做出错误的预测或分类。随着对大型数据集的依赖越来越大,人工智能系统需要防范此类攻击数据”。

深度学习真的万能吗?

当前,人工智能技术的发展突飞猛进,在很大程度上都得益于深度学习在基本的人类技能上取得的重大进步。深度学习的概念最早起源于20世纪50年代,但直到2006年才真正进入到大众的视野。深度学习作为机器学习研究中的一个新的领域,其目的是构建、模拟人类大脑进行分析学习的神经网络。在过去几十年的发展中,它大量借鉴了关于人脑、统计学和应用数学的知识。近年来,深度学习更是得益于高性能的计算机、大规模的数据集以及能够训练更深网络的技术,它的实用性和普及性都有了很大的发展。但是,随着应用的越来越深化,深度学习技术也逐渐暴露出不足之处。

近日,《福布斯》采访了与人工智能相关的120位高管,就2019年人工智能发展趋势进行了预测。其中,网络广告技术公司MediaMath首席技术官Prasad Chalasani表示:“深度学习模型已经被证明很容易受到数据中难以察觉的扰动,这些扰动会欺骗模型做出错误的预测或分类。随着对大型数据集的依赖越来越大,人工智能系统需要防范此类攻击数据,而最精明的广告商将越来越多地研究对抗性机器学习技术,以训练模型抵御此类攻击”。

尽管深度学习技术在众多领域表现出众,特别是在计算机视觉领域,出现了无人驾驶、人脸识别等能够通过深度学习模型自动识别人脸,完成路标等图像的自动理解。但是,伴随着深度学习应用范围的不断扩大,它在面对对抗样本时,也暴露出了其内在的缺陷。

什么是对抗样本,及深度学习对对抗样本表现出脆弱性的原因?

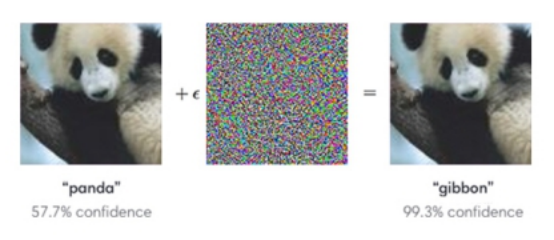

对抗样本是由Christian Szegedy等人提出的一个概念,即在数据集中通过故意添加细微的干扰所形成的输入样本,受干扰之后的输入导致模型以高置信度给出一个错误的输出。

如下图所示,如果在一张熊猫照片添加上一点细微的无法察觉的噪点之后,人工智能图像识别系统将无法进行正确的识别,系统就会错误地认为这是一只长臂猿。

当然,对抗样本不仅仅是图片所拥有的性质,也不仅仅是深度学习神经网络独有的性质。对抗样本是把机器学习模型应用到一些安全敏感性领域里的一个障碍。所以,深度学习对于对抗样本的脆弱性在很多的机器学习模型中普遍存在,因此,进一步研究有利于抵抗对抗样本的算法,实际上有利于整个机器学习领域的进步。

那么,是什么原因导致了深度学习对于对抗样本表现出脆弱性呢?其中一个解释是,深度神经网络的高度非线性特征,以及纯粹的监督学习模型中不充分的模型平均和不充分的正则化所导致的。

如何防御对抗样本?

对抗样本的存在,会造成深度学习在安全敏感性领域的应用受到威胁,而如何对其进行有效的防御是很重要的问题。事实上,对抗训练是防御对抗样本攻击的一种有效的方法。

对抗训练,指的就是通过在对抗样本上训练模型。因为,深度学习的对抗样本是由模型的线性特征所导致,所以,就可以设计一种快速的方法来产生对抗样本进行对抗训练。对抗训练有助于体现积极正则化与大型函数族结合的力量。纯粹的线性模型,由于它们被限制为线性而无法抵抗对抗样本。 神经网络能够将函数从接近线性转化为局部近似恒定,从而可以快速捕捉到训练数据中的线性趋势,同时学习抵抗局部扰动。

写在最后:

深度学习的火热得益于各行各业丰富的大数据发展以及计算机计算能力的提升,同时也要归功于过去积累的经验,今后深度学习将继续解决各种识别和演绎方面的相关问题。当然,深度学习本身也不是完美的,深度学习目前仍有大量工作需要研究,不应该被放大到一个无所不能的程度。

总而言之,目前对抗样本是一个不得不面对的问题,我们需要做的是,研究如何去克服对抗样本,来帮助我们避免潜在的安全问题,并且让深度学习算法对所要解决的问题有一个更准确的了解。

来源:Yesky天极新闻