会学习的软件正在改变世界,但需要监督。人类以两种方式监督它们。一是向机器学习算法展示描述当下任务的大量数据。例如有标记的猫和狗的图片,让算法学习区分两者。另一种监督是在高度结构化的环境中设定一个特定目标,例如在某款电子游戏中获得高分,再让算法尝试众多可能性,直到找到能实现目标的那一个。

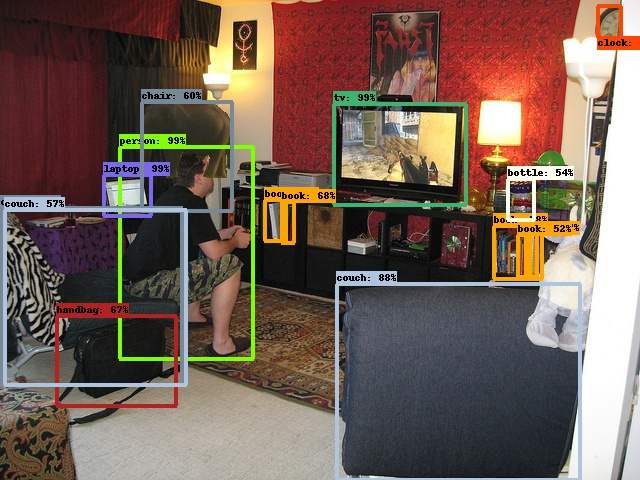

这两种「监督学习」的方法已经在人工智能(AI)领域带来了突破。2012 年,多伦多大学的一组研究人员用第一种方法构建了 AlexNet,这个软件在一项竞赛中识别出的图像比其最接近的竞争对手多了十分之一。2015 年,Alphabet 旗下的英国人工智能公司 DeepMind 的研究人员用第二种方法教一个算法玩电子游戏雅达利( Atari),水平超过人类。后来在围棋上取得的胜利正源自这一成果。

这些突破为今天 AI 很多令人兴奋的发展奠定了基础。但监督学习也存在缺陷。人工指导涉及标记数据或设计虚拟环境等人工作业,成本高昂。指导完成后还不能用于其他学习。监督学习也不大现实。现实世界通常不会标记事物或为学习进展提供明确的信号。AlexNet 和 DeepMind 的游戏智能体都需要几百万至几十亿个示例或模拟,以及消耗大量电力的强大计算机。位于巴黎的法国国家信息与自动化研究所(Inria)的 AI 研究员皮埃尔-伊夫·乌迪耶(Pierre-Yves Oudeyer)说:「如果你打算在每次新的训练任务中都这样做,那么就需要几十个核电站专门为你服务。」

因此,AI 若要真正腾飞,还需要些别的东西。乌迪耶说,这推动研究人员开始探索人类了解世界的基本机制之一:好奇心。乌迪耶和其他人不再使用由人类创建的函数来训练算法,而是在过去 20 年里开发人工智能体,用它们自己内在的奖励系统来检视周围的世界并收集数据。这样的工作正开始获得成功。

第一代「好奇心 AI」使用「预测错误」来激励智能体。该软件会探索它需要研究的实体或虚拟环境,寻找与它的预期差异很大的东西。换句话说,它是在搜索新奇数据。这种方法行得通,但有一个很大的缺陷。例如,观察过往车辆的智能体可能会沉迷于经过车辆的颜色顺序,因为它对下一部车的颜色做出的预测几乎总是错误的。但这样做没有实际用处。一个好奇的机器人如果不去学习怎么走下楼梯,而是为了寻求信息的刺激反复从楼梯上滚下去,同样也没有意义。

解决这个问题的方法是把注意力放在智能体的预测错误变化率而不是错误本身上。使用这种方法,机器人在刚开始观察日出日落时预测错误会很多,但随着它对一个物理系统实际属性的认识加深,错误逐渐减少。将预测错误系统的变化率用作智能体进入下一个任务的信号等于给它设了一个无聊阈值。如果一个要搞清过往车辆颜色规律的机器人使用这样一个系统,它会保持稳定的错误率,进而感到无聊。

乌迪耶在实际研究中尝试了他的好奇心算法。今年 6 月,他的研究小组在法国阿基坦地区(Aquitaine)的一些公立和私立学校对 600 名小学生开展了测试。他的构想是为每个孩子的数学学习过程建模,提供因人而异的优化练习。该系统名为 KidLearn,它把每个孩子都视为自己的好奇智能体,调整学习内容以适应孩子的理解水平和学习进度。与其他软件不同,KidLearn 不依赖从其他儿童那里收集到的数据作为引导,而主要是根据孩子的好奇心来调整。乌迪耶的研究人员很快将会公布这一系统的表现。

硅谷的研究人员也一直在研究好奇心。在最近的一篇论文中,来自加州大学伯克利分校和伊隆·马斯克资助的非营利性研究公司 OpenAI 的迪帕克·帕沙克(Deepak Pathak)及其同事表明,尽管他们的智能体在玩电子游戏时没有得到任何输入,也没有在被打败或过关时得到任何信号,好奇心驱动的学习仍然在一系列虚拟环境中运作良好。

好奇智能体展示了一些有趣的行为。它学会了在打砖块游戏 Breakout 中获得更高的分数,因为得分越高,砖块模式越复杂,智能体的好奇心就越能得到满足。两个好奇智能体在玩乒乓球游戏 Pong 时学会了没完没了地来回击球而不得分,一直打到游戏崩溃,因为它们发现这比获胜更有趣。死掉也很没意思。研究人员在最近发表的一篇论文中说:「智能体会避免在游戏中死掉,因为这会让游戏重头开始,而开始阶段它已经玩过很多次,也已经能很好地预测走向。」

还有其他方法可以赋予机器探索的冲动。旧金山优步 AI 实验室的研究员肯尼斯·斯坦利(Kenneth Stanley)模仿了进化过程。他的系统从一组随机算法开始运作,从中选出一个看起来适合手头任务的算法,由此派生出一组算法,最终演变出一个最适合这项工作的算法。斯坦利指出,进化可以产生目标驱动的优化所无法产生的偶然结果。生物进化对飞行没有明显的好奇,但仍然演化出了鸟类。

所有这些都表明,一套更完整的学习算法正在出现。由好奇心或进化驱动的人工智能体可应用于学习的早期阶段,也更适合缺乏大量数据的零散的环境。一旦找到有趣的东西,就可以接着进行监督学习,以确保能准确学到特定的功能。8 月,在温哥华举行的电子游戏大赛中,OpenAI 用目前最先进的监督学习技术创建的 AI 智能体在战略游戏 DOTA 2 中惨败给了人类。更好奇的学习模式可能有助于 AI 玩转游戏中的长期战略部分,因为其中很少有奖励信号,也没什么得分变化。

「我不想死两回,这可太无趣了。」美国理论物理学家理查德·费曼(Richard Feynman)临终前这样说道。这是他最后一次向好奇心致敬。他终生都在探索宇宙的内在运作方式,寻找新的事物来建模和理解。人类的这种倾向性不仅能激励人,也能驱动机器。

转自:www.cnbeta.com

稿源:superstition