作者:吴建明

智能座舱概念

多屏联动、智能表面、自动驾驶、新材料、情感引擎正在迅速普及到中高端豪华电动车型中,智能座舱的下一个十年,更多数字化技术将会完美融入到智能座舱中,智能座舱也势会以更全新的形式呈现出来!

电动化、智能化、网联化、共享化成为汽车行业未来发展趋势,已经成为行业共识。这些趋势将带来人的生活与出行的极大变革,也会导致汽车座舱形态、座舱功能、交互方式的变化,因而汽车智能座舱的设计成为未来汽车发展和创新的关键因素,也是打造差异化、吸引用户非常重要的方面。

长期以来,汽车座舱都是以机械按钮为主,整体信息显示简单、功能比较分散。近几年随着手机等电子设备的快速发展,电子信息技术开始向车内转移,产生了智能座舱。对于智能座舱,业内一直没有明确的定义,我们认为智能座舱就是通过各种智能化手段满足不同人在车内的不同需求,智能座舱相比现有座舱更加智能、人性,能够洞察到用户的需求,又能很好地满足用户的需求。

那么智能座舱是由什么构成的呢?首先是用户需求的实现,就是用户希望车机帮他完成什么功能,这是智能座舱最为基础也是核心的,其他的一切都是围绕着功能展开。其次为了实现这些功能,需要人将这些需求传递给车,也就是信息输入(控制)。车机实现了相应功能后,还需要将信息传递给用户,也就是信息输出(显示)。功能的实现、信息输入、信息输出就构成了我们所说的智能座舱,因此我们将从这三方面论述智能座舱的发展。

一、从被动到主动的交互模式

真实驾驶场景中,驾驶者视线与双手被驾驶任务占据,但驾驶员拥有与外界交互的需求,在人车交互体系中,驾驶员的核心注意力一定是被“开车”这件事占据的。所以,驾驶人员和车机系统进行“沉浸式”的交互短时间内并不现实。

除了注意力这种无形的交互限制外,驾驶人员的双手和视线两个重要的交互通道也被占用了。驾驶员可以偶尔单手操作,但可交互的距离被限制在了臂长范围内,同时,由于路面可能会颠簸、单手操作时的肘部是悬空的,这些都会导致操控的精准度下降。

而另一方面,驾驶员的视线无法离开路面超过3秒,尤其是在高速驾驶的场景下,1秒钟内汽车的移动距离最高可达30多米,眨眼间,可能就会造成惨剧。

但是,人们其实很难在驾驶过程中老老实实的,双手握好方向盘,视线紧盯路面,别的什么都不做。通过我们的调研发现,用户在开车时,会做很多事情,比如看看路况、听听音乐、和朋友聊聊天,甚至下班的路上顺便定个外卖,到家刚好能吃上。在这个数字化的智能时代,我们不可能让驾驶人员一坐进车里就突然断掉与外界的一切沟通,不去处理任何生活和工作的相关信息,只做开车这一件事。

结合前面说的驾驶场景下的交互特点,就会发现被动式交互是不适合在车内使用的。

用户需要发起和推进每一个节点,这样会导致视线需要频繁从路面上移开,不仅带来不安全的隐患,整个过程也是非常低效的。于是我们设想,人与车的交互可不可以打破这种由人来发起再逐层深入的方式?汽车能不能在我需要的时候主动的把对应的服务放到我面前,而不再需要我在开车时手忙脚乱的去找。这样美好的体验设想,我们把它称为“主动式交互”。

那么什么是主动式交互呢?不同于被动式交互由人来发起,主动式交互以机器为起点,主动输出执行结果或建议给使用者,其次,机器可以自己主动的从外界输入信息然后进行决策判断,不再需要人来输入指令。随着智能化,自动化,电子化的趋势发展,车舱交互目标方向都为之动态变化。

智能化:随着技术,硬件和成本的发展,车里会越来越智能,智能化对交互方式影响是机器会增加担任主动输入的能力,所以随着车越来越智能化,车主在输入方面投入加少,效率更快。

自动化:随着自动驾驶的技术越来越成熟和普及,车主会逐渐释放注意力资源和手眼,可以更多投入车舱更多的娱乐操作当中。也会导致在输入输出反馈中更好利用视觉反馈。

电子化:去掉实体控件,科技感,简化内饰,降低成本,变成一种趋势。但是无论是触摸屏还是语音,都没有办法完美取代实体控件交互。然而,趋势仍然是站在触摸屏这边的。所以这也导致在车舱里交互的变化。

我们把车舱交互阶段抽象归纳为3个阶段进程,用户主动式交互---机器建议式交互---机器主动式交互。我们目前处于用户主动式交互到机器建议式交互到过渡期。而我们能推理出用户输入,机器输出/反馈和场景信息采集在这3个阶段进程里的趋势。

所以我们在规划未来的多模交互时,要增加对机器输出/反馈界面的重视,逐渐降低对用户输入的投入,重视场景信息采集,让机器承担更多主动输入输出的角色,从而真正解放用户的思考,达到自然交互的目的。

主动式交互的车机系统,应该做到精准与无感知的主动输入

主动输入的体验目标有两个,精准度和无感知。如果一开始机器对外界的感知就不精准,判断出错,那么机器的主动输出很有可能不是用户需要的,所以我们要确保精准。另一方面,机器的主动输入过程也不能干扰用户,那最好的方式就是让用户感知不到,也就是无感知交互。

我们把车和人感知世界的方式做比较,人有感官,可以通过看和听来感知周围的环境。同样的,我们通过在车内搭建一套硬件传感系统作为车的感官,借助AI的识别技术,让汽车也具备和人类似的听、说、看的能力。

主动式交互的车机系统,应该做到简洁高效的主动输出

说完了主动输入,我们再来看看主动输出;输出是机器主动和人进行沟通的重要环节,在驾驶这个特殊的场景下,机器的主动输出要尤为注重减少驾驶干扰和提升传达效率。

主动式交互能有效减少用户视线转移次数,提升安全性,主动式交互能省去记忆和寻找功能入口的麻烦,提高效率,无人车时代的“主动式交互”将由车内拓展到车外。

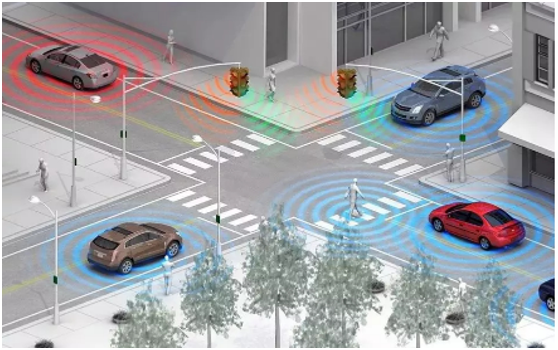

人工智能技术使得机器的自主性越来越强,机器会变得越来越智能,随之交互也会变得越来越主动。那么,在更加智能的无人驾驶时代,汽车又会怎样的“主动”的和人类交互呢?

事实上,在无人驾驶的时代,车不仅要和车内用户交流,还要主动的和车外行人、道路上行驶的其他车辆进行交互。

而车和外部环境的沟通方式,由于距离和噪声的影响,也会有很大不同。

当我们走向车辆,汽车会通过传感器或人脸识别等技术来以语音、灯光、全息影像、车外屏等形式来给我们来打招呼。同时,会对我们进行全面识别,以确定我们是否携带行李和儿童,从而为我们提供行李搬运机器人,并为我们打开车门,安排适合我们乘坐人数的座椅配置方案。

二、从按键-语音-到多模态交互进阶

语音成为多模态融合的主流交互方式

随着科技发展和车主的期望,车内外的信息和功能越来越多,作为HMI设计师的任务就是让车主减少注意力资源占用,减少驾驶分神,所以交互方式由此产生阶段性变化:

物理旋钮/按键——数字触屏——语音控制——多模态交互

车内信息和功能随着越来越多,物理旋钮/按键的交互方式已经满足不了内容的扩展,数字界面由此在车内出现。但是当网联化后,娱乐信息成为了车内一大内容,数字界面的弊端也逐渐暴露出来了。界面层级导致操作效率的下降,而数字组件控件虽然解决了空间,成本,扩展迭代的问题,但是同时也缺失了物理旋钮/按键原本的触感反馈,易定位性及效率精细操作等优势,一定程度上影响到驾驶安全。

而此刻语音的出现,可以有效的提高操作效率,减少车主视线移开路面的时长,提高了驾驶安全。那么语音交互就是最终的理想形态了吗?答案是否定的,功能不可见性/输入输出效率低/识别正确率/意图理解/勿扰性等等弊端导致语音交互并不能解决所有问题。而近几年多模态交互方式概念的提出并应用,试图改善这些问题。

个人觉得车舱交互的未来一定是以语音为主的多模态交互方式,从车辆、环境、驾驶员状态等全面的感知、融合、决策、交互。丰富多模的输入,语音作为主交互模式,其余模态作为辅助与增强作用。语音又是人工智能的先锋,也是最先落地的技术,当前还有很大的提升空间。

区别于以往的交互方式,语音交互在输入和输出方式上发生了质的变化,语音可以解放人们的双手和双眼,降低驾驶场景的操作风险,提高安全度。但目前语音交互仍不够自然,会受诸多条件限制,例如需要在安静环境下,先唤醒然后发出指令,使用普通话交流等,这些并不符合人们日常对话的习惯。

未来,随着语音技术的不断完善,语音交互的自然度将进一步提升,并愈加趋向人类自然对话的体验。

具体表现为:

1. 语音交互将从机械的单轮对话进阶到更流畅的多轮对话

2. 合成语音更自然、真实,接近真人水平

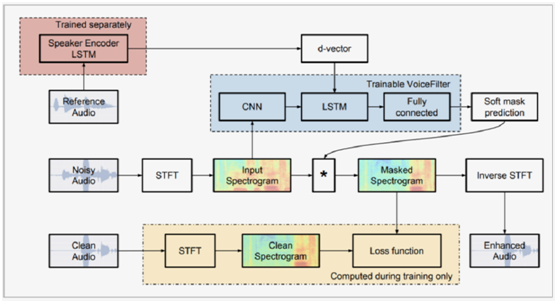

3. 语音交互具备听觉选择能力,提升多人对话体验

4. 语音交互将支持多种方言,并针对细分群体进行差异化设计

5. 语音具备人设,情感,智能

目前,语音形象的人设的设计和表达主要聚焦在语音(如音色,语气语调等)和语言层面(如表达方式),并且通常局限在部分场景,部分话术上,缺少一致性和全局感。

未来,语音形象人设的设计和表达将以多维度整体设计的理念解决全局感弱的问题:从语音,产品外观,虚拟形象等维度进行整体的设计,甚至聘用编剧设计具有统一形象特点的话术,利用混合现实,全息投影等技术将人设具象化,以让用户在不同场景下均感受语音助手一致,明显的人设特征。打造用户喜爱的人设也将成为企业在市场竞争中形成差异化,吸引更多用户的重要方式。

在情感识别的基础上,语音助手开始具备对情感的应对能力。通过合理借鉴人对于情感的应对策略,语音助手将从硬件层面(光效,肢体动作),VUI层面(如音乐,音效,话术),GUI层面(表情,颜色)等给出立体的情感反馈。智能体在人机交互过程中将体现出更多“情感智能”,带来更人性化的交互体验。

从语音交互到多模态交互

人脸交互利用人自身固有特征进行交互,具有自然,方便,快捷等特点;伴随计算机视觉技术发展,深度学习算法的不断突破,用于身份验证的人脸检测和识别技术已经成熟,被广泛应用于个人和公共场景的身份验证,并会继续扩大应用落地场景。

未来,车里还可以准确地识别人脸更多细节信息,如表情,微表情,精神状态(是否疲劳,是否专注),视线注意等,以判断人的情绪,疲劳状态,专注度等,并在情感互动,疲劳驾驶预警,专注力监测与应对等场景发挥作用。

三、智能互联,多场景衔接

未来,将会打破单车智能的孤岛效应,形成一个互联智能场景。在此场景下,设备之间将互联互通,场景直接实现无缝衔接:一种情况是一个大脑(中控)连接并控制多个终端,例如通过智能中控,控制家里空调,窗帘等等。通过设备互通,场景融合,形成数据交互,共享的崭新智慧生态,共同提升人们的生活品质。

智能互联下的多场景衔接需要人机信任

随着自动驾驶智能汽车的发展,智能汽车可以辅助甚至替代人们做出一些决策。在这种情况下,人类能否信任AI成为人机能否实现深度协同的重要前提。

人与人的信任通常建立在理解对方和了解其可靠性的基础上。而AI对于大多数人来说都较为陌生,决策过程也难以理解,这种不确定性往往会引发焦虑。同时,决策权和控制权的过渡也让我们对AI可能发生的错误异常敏感。

因此,信任构建的关键在于保证系统更加透明可靠(如在协作中给出决策依据),以及让人参与到AI的训练中,可以对智能系统进行指导和校正。通过人和AI的持续有效互动,AI成为可指挥,可纠正,可理解,可自我解释的系统,而人也学会如何更好地理解AI,用户AI来满足自己的需求。

车联网与家庭物联网正在逐渐整合,汽车与家庭之间的互联性增加,对汽车到家庭门户网站的需求将不断增长。

宝马和SmartThings合作,让宝马客户在旅途中与家人保持联系。从BMW数字仪表板,任何配备ConnectedDrive服务功能的BMW都将允许驾驶员在智能家居中单独配置房间和连接设备、打开和关闭家庭报警系统、在家庭紧急情况下接收警报等操作。

可以通过手机远程控制车门、车窗、车灯、空调 等,提供用车相关服务,包括加油、违章提醒、停车位拍照寻车等,以后在大型停车场再也不会有找不到车的尴尬了。华为智能家居 HiLink 服务的演绎视频中显示 ,通过中控屏幕控制家里的智能设备,包括灯具、窗帘、门锁以及各种家用电器 。

四、AR-HUD等新技术的成熟与普及

在未来三年内有量产基础的八项交互新技术中,AR-hud、智能机器人、智能表面、空中手势等技术正在逐渐成熟。HUD抬头显示中,可以有效发挥车载AR在智能车舱中的应用价值。

不同用户如单一用户或多用户如驾驶员、副驾驶、车内乘客,针对不同的信息内容维度:安全、导航、车辆监控、娱乐交流工作等,在不同的驾驶模式下等都呈现出非常大的设计空间。分享相应的内容到HUD屏幕上,通过AR地图导航技术叠加眼动跟踪技术,可以让驾驶员体验到更加逼真的导航服务。

AR-HUD是通过内部特殊设计的光学系统将图像信息精确地结合于实际交通路况中,将胎压、速度、转速等信息投射到前挡风玻璃上。使车主在行车中,无需低头就能查看汽车相关信息。下面我们将结合部分案例,来看一下AR-HUD在未来的发展。

在驾驶安全方面,AR-HUD将结合ADAS、汽车传感器来做出安全提醒。比如,跟车距离预警、压线预警、红绿灯监测、提前变道、行人预警、路标显示、车道偏离、前方障碍物、驾驶员状态监测等等。同时,通过颜色的变化来提醒驾驶员安全度。

五、总结

下一个十年,随着5G和车联网技术的发展,科技、智能、人性化,正在重新定义未来智能座舱人机交互新体验。

本文转自:博客园 - 吴建明,转载此文目的在于传递更多信息,版权归原作者所有。

CSDN:https://blog.csdn.net/wujianing_110117/article/details/106169051

知乎:https://zhuanlan.zhihu.com/p/141502664