一、集成学习简介

集成学习的思想就是将多个弱学习器组合成一个强学习器。集成学习的优点在于保证了弱分类器的多样性,使得其得到的结果往往比单个学习器的效果好(可以理解为真理往往掌握在大多数人手中)。

常见的集成学习的思想主要有:

1)bagging (自举汇聚法)

bagging算法:对于有m个样本的原始数据集,进行n次有放回的抽样得到一个样本,重复s次操作得到s个数据集,对这s个数据集训练出s个弱学习器,将这s个弱学习器融合得到一个强学习器。

模型融合方法:对于分类模型,采用少数服从多数(多数投票)的方法。 对于回归模型,采用平均值的方法。

2)boosting (提升算法)

bagging算法不考虑构建的模型之间的关系,boosting考虑各个模型之间的关系,并且通过加权累加的方式生成新的模型(强预测模型)。boosting的算法由于考虑模型之间的关系,所以boosting只能串行执行。

3)stacking (模型融和算法)

二、Bagging算法

2.1 RF算法的思想(RandomForest,RF)

RF算法采用Bagging的冲采样的方法得到s个数据集,运用决策树的方法建立s个决策树模型,在进行模型融合得到结果。注意:这里的决策树建立的过程中采用随机选择特征属性的方法(局部最优的划分方法),有效的避免了会出现的过拟合的情况。

2.2 Extra_Tree

Extra_Tree是RF的一个变种算法,它和RF不同的在于以下几个方面:

1)它对于训练数据集不进行重采样的操作(使用原始数据集)

2)它是完全的随机进行特征属性的选择。

3)Extra_Tree具有较之于RF更强的泛化能力。

2.3 TRTE(Totally random Trees Embedding)==》将低维数据映射到高位空间中处理,也是RF的一个变种算法

2.4 异常点检测(IForest)

三、boosting(提升算法)

3.1 Adaboost==》分类、回归算法(考虑样本之间和每个样本的每个特征之间的权重不同,重点考虑分错的样本)

sklearn.ensemble.AdaBoostClassifier(base_estimator=None, n_estimators=50, learning_rate=1.0, algorithm=’SAMME.R’, random_state=None)

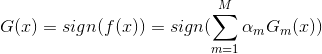

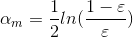

Adaboost是通过多个模型加权融合的方法,得到一个打分值函数f(x),最终的模型(强学习器)为:

其中,

sign函数为:

这里我们用一个例子来叙述Adaboost算法的过程。(后补)

3.2 GBDT(梯度提升迭代算法)==》分类、回归算法

GDBT的损失函数为均方差,这里就不写出了。它的基模型必须是CART,运用上一轮的模型预测的残差值作为目标值(标签)不断训练得到新的模型,直到残差为0,则将残差相加得到预测值。在实际的运用中,GBDT具有很好的预测能力。

GBDT实际上是一个回归模型,只是可以通过一些操作实现回归的操作的(这里可以参考Logistic回归和softmax的分类方法)。

GBDT中的GB(梯度)就是每一次迭代改变的方向都是沿着梯度最陡的方向降低损失的学习器来弥补模型的不足的。

3.3 XGBoost简介

XGBoost是GBDT的变种算法。与GBDT不同的是,XGBoost在GBDT的基础上,XGBoost既考虑了模型的预测误差,还考虑了模型的复杂度的问题。

对于采样的方法,XGBoost采用了随机列采样的方法(借鉴RF方法);XGBoost还可以对缺失值进行自动处理,在特征选择时使用的是并行处理的方法;它的基学习器可以是CART,也可以是其他模型如:Logistic归回、线性回归等。

四、Bagging和boosting的区别总结

1)样本选择方式和样本模型的权重不同。Bagging是通过对数据集进行重采样,而Boosting关注的是样本间的权重值不同,并且对于预测错误率较小的模型具有更大的权重。

2)计算方式不同。理论上讲,Bagging是并行计算的,Boosting是串行计算的。

3)效果不同。Bagging减少的是模型的方差(防止过拟合),而Boosting减少的是模型的偏度(防止欠拟合)。

4)分类器模型不同。Bagging里的分类器都是强分类器,而Boosting里的每个分类器都是弱分类器。

版权声明:本文为CSDN博主「笨拙的石头」的原创文章,遵循CC 4.0 by-sa版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/qq_32241189/article/details/79844611